En el panorama digital actual, la capacidad de generar palabras clave a partir de texto es esencial para la SEO, la creación de contenido y la investigación académica. Identificar los términos y frases que mejor representan tu contenido puede mejorar la clasificación de los motores de búsqueda, agilizar los esfuerzos de investigación y guiar estrategias de contenido efectivas. Los avances modernos en el procesamiento del lenguaje natural para la extracción de palabras clave hacen que este proceso sea más sencillo y preciso que nunca, y herramientas como Eskritor destacan como principales ejemplos de innovación.

En esta guía, exploraremos la importancia del análisis de texto para la generación de palabras clave, profundizaremos en varias técnicas, incluido el análisis de frecuencia de términos para palabras clave y el uso de TF-IDF para la extracción de palabras clave, y discutiremos el análisis semántico para generar palabras clave en contexto. También destacaremos las mejores herramientas para generar palabras clave a partir de texto y proporcionaremos un tutorial paso a paso para la generación de palabras clave.

¿Por qué generar palabras clave a partir de texto?

La extracción de palabras clave sustenta una variedad de tareas profesionales, desde mejorar la clasificación del sitio web hasta categorizar los documentos de investigación. A continuación se presentan algunas de las razones principales por las que este proceso es vital para las estrategias modernas de contenido y datos.

1 Optimiza el contenido para SEO

Las palabras clave forman la columna vertebral de cualquier estrategia eficaz de optimización de motores de búsqueda . Al identificar los términos más relevantes utilizados por su público objetivo, puede optimizar las publicaciones de blog, las páginas de destino y otros contenidos en línea para obtener una clasificación más alta en los resultados de búsqueda. Esto no solo aumenta el tráfico, sino que también mejora la participación de los usuarios al alinear su contenido con la intención del lector.

2 Mejorar la eficiencia de la investigación

Para los estudiantes, investigadores y analistas de datos, la extracción de palabras clave puede reducir significativamente el tiempo dedicado a examinar documentos grandes o trabajos académicos. Al resaltar las ideas principales y la terminología, puede categorizar rápidamente los hallazgos, localizar referencias importantes e incluso realizar un seguimiento de las tendencias en varios estudios. Herramientas como Google Scholar ayudan aún más a descubrir temas y artículos de investigación relacionados.

3 Mejorar la estrategia de contenidos

Comprender qué palabras clave resuenan con tu audiencia, ya sean palabras clave de cola larga para industrias de nicho o términos amplios con altos volúmenes de búsqueda, te ayuda a planificar tu calendario de contenido de manera más efectiva. Esto garantiza que cada pieza que produzca hable directamente de lo que sus lectores o clientes están buscando, lo que en última instancia aumenta las conversiones y la satisfacción del usuario.

4 Automatice los procesos manuales

Atrás quedaron los días en los que los equipos tenían que hojear manualmente páginas y páginas de texto para identificar temas y frases recurrentes. Las herramientas modernas de extracción de palabras clave ahorran tiempo y reducen el error humano al automatizar todo el proceso, lo que le permite centrarse en tareas de nivel superior como la estrategia, el análisis y la ejecución.

5 Resultados más rápidos

El procesamiento manual de grandes volúmenes de texto es engorroso. Una solución AI como Eskritor puede analizar cientos de páginas en cuestión de minutos, lo que le permite iterar rápidamente y tomar decisiones basadas en datos más rápido.

Técnicas comunes para generar palabras clave a partir de texto

Las diferentes técnicas satisfacen diversas necesidades analíticas, ya sea que desee un recuento de frecuencia simple o una comprensión semántica más profunda. Exploremos los métodos más utilizados y cómo ayudan a extraer palabras clave significativas.

1 Análisis de Frecuencia de Término

Un método fundamental, la frecuencia de términos (TF), identifica las palabras o frases más utilizadas dentro de un texto. Si bien este enfoque puede mostrar palabras clave obvias, no tiene en cuenta la singularidad o especificidad de esos términos en varios documentos.

2 TF-IDF (Frecuencia de Términos–Frecuencia Inversa de Documentos)

TF-IDF refina el análisis básico de la frecuencia de los términos teniendo en cuenta la importancia de un término en un conjunto de documentos. Las palabras que aparecen con frecuencia en un documento, pero rara vez en otros, reciben una puntuación más alta, lo que hace que esta técnica sea excelente para identificar palabras clave más especializadas o específicas del contexto.

3 Análisis semántico

El análisis semántico identifica frases contextualmente relevantes mediante el examen de las relaciones entre las palabras en lugar de solo las de uso frecuente. Esto es especialmente útil si desea capturar sinónimos, términos relacionados o ideas vinculadas temáticamente en lugar de palabras repetitivas que pueden no tener significado.

4 Enfoques basados en NLP

Las técnicas avanzadas de NLP , como el reconocimiento de entidades con nombre (NER) y el modelado de temas, van más allá de los simples recuentos de palabras. NER identifica personas, lugares, organizaciones y otras entidades específicas, que pueden ser palabras clave cruciales en el periodismo o el análisis empresarial. El modelado de temas revela temas más amplios dentro de un texto, lo que facilita la categorización de grandes volúmenes de datos.

Las mejores herramientas para generar palabras clave a partir de texto

La extracción de palabras clave se puede realizar utilizando una variedad de herramientas y plataformas especializadas. A continuación se muestra un vistazo a algunas de las principales opciones, cada una adecuada para diferentes requisitos del usuario, desde la optimización de SEO hasta el análisis integral de datos.

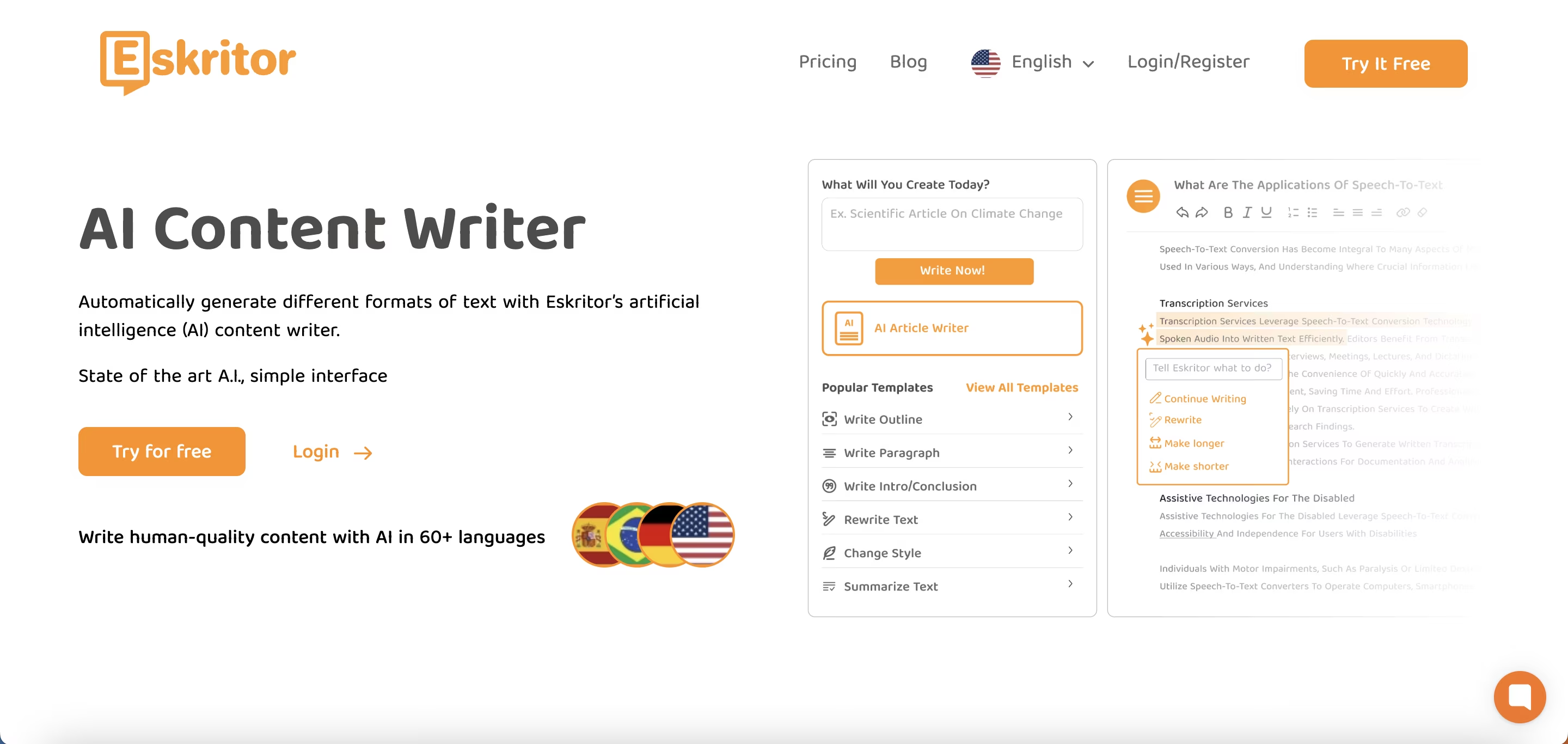

1 Eskritor

Eskritor es una plataforma de escritura avanzada y orientada a la AIdiseñada para simplificar y mejorar el proceso de extracción de palabras clave para los usuarios en varios campos, ya sea que esté optimizando para SEO, desarrollando campañas de marketing o realizando investigaciones académicas. Al aprovechar los potentes algoritmos de procesamiento del lenguaje natural (NLP Eskritor ), identifica automáticamente los términos y frases cruciales de su texto, destacando tanto las palabras clave basadas en la frecuencia como la información basada en el contexto.

Características principales

- AIherramienta de escritura diseñada para uso SEO, marketing y académico

- Interfaz sencilla para analizar texto y generar palabras clave accionables

¿Por qué se destaca?

- Acelera el análisis de palabras clave con algoritmos de NLP avanzados

- Ofrece opciones personalizables para el filtrado de frecuencia y el análisis semántico

2 Google Keyword Planner

Un elemento básico para los especialistas en marketing digital, Google Keyword Planner alinea las palabras clave sugeridas con los datos de volumen de búsqueda. Si bien es principalmente para campañas de PPC, también ayuda a los creadores de contenido a refinar sus temas en función de las consultas reales de los usuarios. La integración con Google Ads proporciona información directa sobre la frecuencia con la que se buscan términos específicos, lo que le brinda una ventaja en la creación de contenido que coincida con la intención del usuario.

3 MonkeyLearn

Ideal para el análisis de texto, MonkeyLearn proporciona extracción de palabras clave mediante potentes API de NLP . Destaca en la categorización de comentarios, reseñas o conversaciones en las redes sociales, lo que lo hace valioso para las marcas que se centran en el análisis de sentimientos y tendencias. El panel de control de MonkeyLearnincluye opciones para el procesamiento en tiempo real, lo que significa que puede configurarlo para analizar continuamente los datos entrantes, lo que es perfecto para equipos de marketing de ritmo rápido u operaciones de atención al cliente.

4 Bibliotecas de R y Python

Para los usuarios que se sienten cómodos con la programación, las bibliotecas como Tidytext (R) y spaCy (Python) permiten la extracción de palabras clave en profundidad y personalizables. Puede implementar TF-IDF, modelado de temas y análisis de sentimientos para proyectos altamente especializados o a gran escala.

Estas bibliotecas ofrecen la flexibilidad necesaria para ajustar los parámetros o integrarse con marcos de aprendizaje automático, lo que las hace ideales para científicos de datos o investigadores que requieren una canalización de análisis de texto totalmente personalizada.

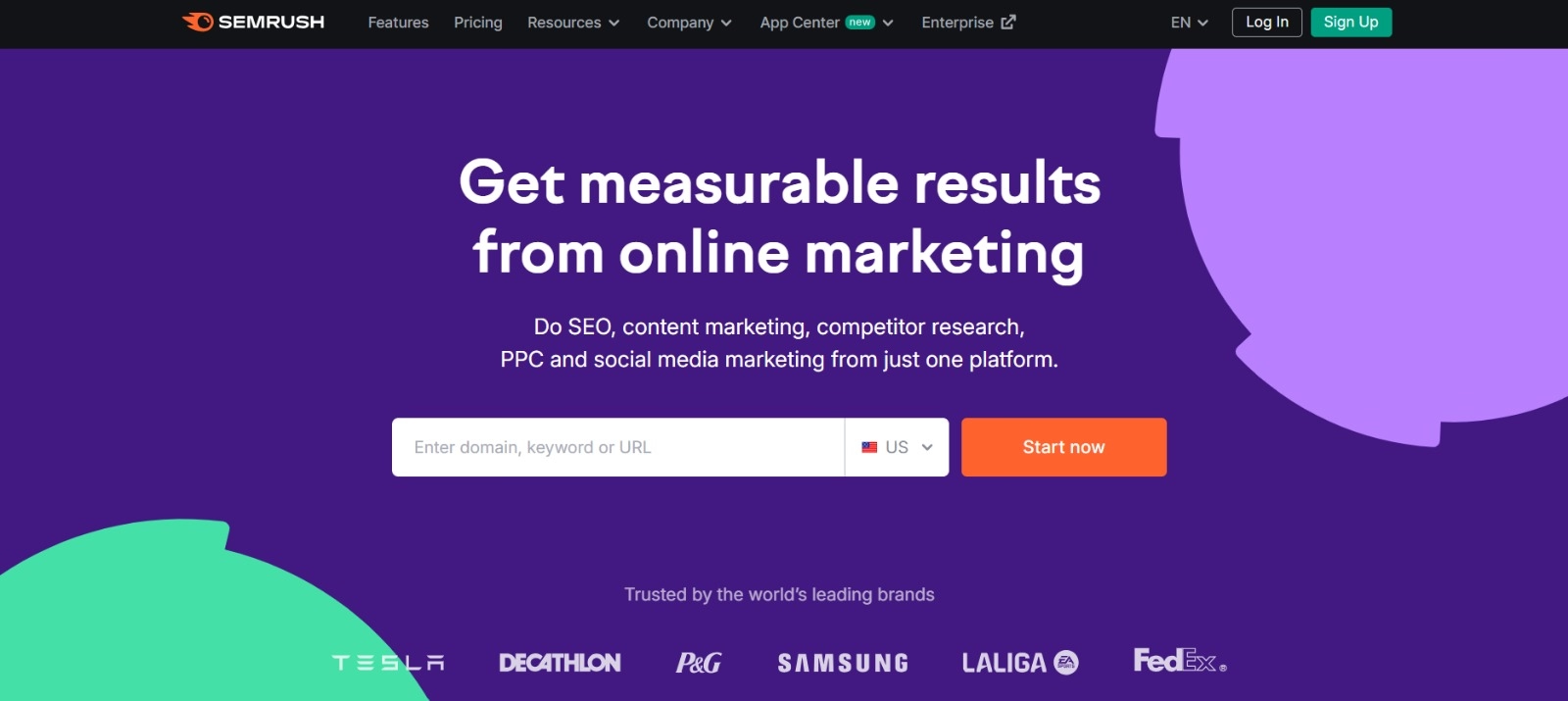

5 Semrush

Una opción popular entre los profesionales de SEO , Semrush combina la investigación de palabras clave con el análisis de la competencia. Su enfoque en el volumen de búsqueda, las puntuaciones de dificultad y las estrategias de la competencia ayuda a refinar los planes de contenido para obtener la máxima visibilidad.

Más allá de las sugerencias de palabras clave, Semrush proporciona información a nivel de dominio, como perfiles de backlinks y análisis de tráfico, lo que permite un enfoque holístico de las tácticas de marketing digital y de SEO .

Guía paso a paso para generar palabras clave con Eskritor

Cuando se trata de una extracción de palabras clave sencilla pero potente, Eskritor ofrece un excelente equilibrio entre la usabilidad y las funciones avanzadas de NLP . A continuación, te explicamos cómo sacar el máximo partido a su plataforma.

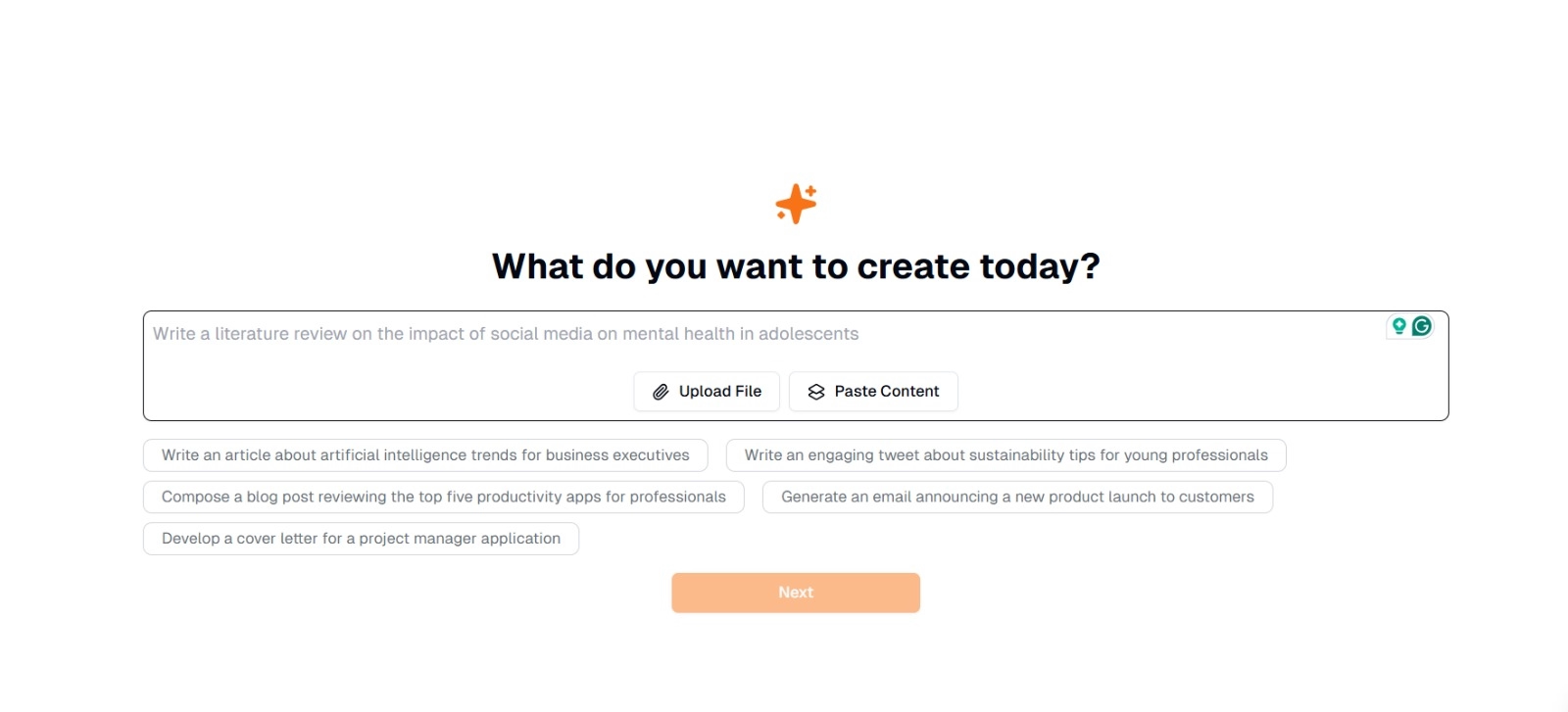

Paso 1: Ingresa o sube tu texto

En la interfaz principal de Eskritor, verás un mensaje que pregunta: "¿Qué quieres crear hoy?" Aquí, tienes dos opciones:

- Pegar contenido : Copie y pegue su texto directamente en el cuadro de texto dado.

- Cargar archivo : Elija un documento (por ejemplo, .docx, .pdf, .txt) que contenga el texto que desea analizar.

Consejo : También puede seleccionar una de las indicaciones sugeridas (por ejemplo, "Escribir un artículo sobre las tendencias de la inteligencia artificial...") si planea generar o reelaborar el texto antes de la extracción.

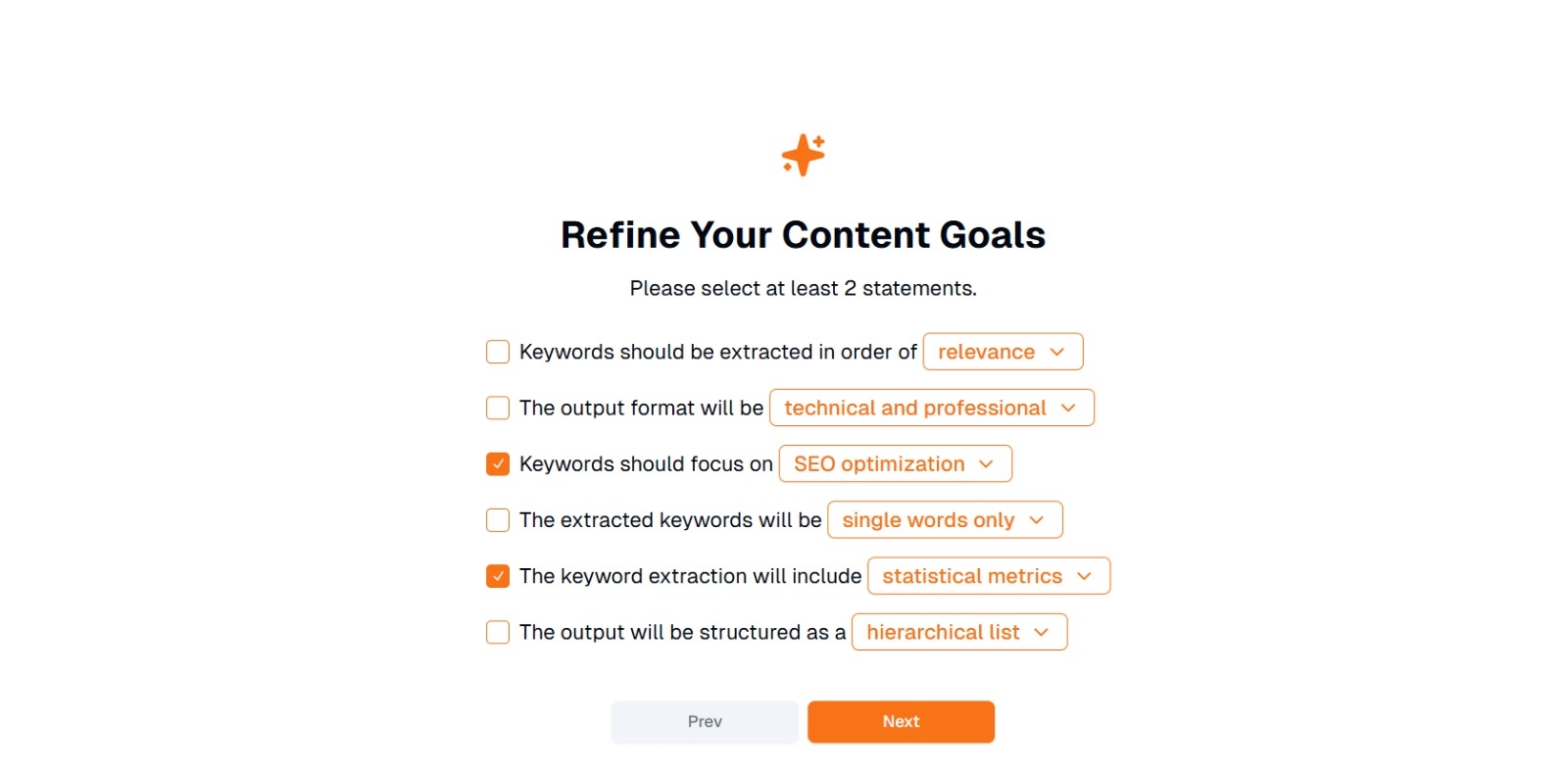

Paso 2: Refina tus objetivos de contenido

Se te pedirá "¿Qué quieres hacer con este contenido?" y se le pidió que seleccionara al menos 2 declaraciones. Además, puedes escribir lo que quieres hacer para chatear. Las opciones pueden incluir:

- Las palabras clave deben extraerse en orden de: (por ejemplo, relevancia , frecuencia , alfabético , etc.)

- El formato de salida será: (por ejemplo, técnico y profesional , casual y amigable )

- Las palabras clave deben centrarse en: (por ejemplo, optimización deSEO, investigación académica, ángulos de marketing)

- Las palabras clave extraídas serán: (por ejemplo, solo palabras individuales , frases de varias palabras )

- La extracción de palabras clave incluirá: (por ejemplo, métricas estadísticas , agrupación semántica )

- La salida se estructurará como: (por ejemplo, una lista jerárquica , viñetas simples )

Consejo: Seleccione las declaraciones que mejor se adapten a las necesidades de su proyecto. Por ejemplo, si está optimizando una publicación de blog para los motores de búsqueda, considere verificar la optimización deSEO , solo palabras individuales y extraídas en orden de relevancia .

Paso 3: Haz clic en "Siguiente" para generar palabras clave

Después de refinar sus objetivos y realizar las selecciones deseadas, haga clic en Siguiente (o en un botón similar) para comenzar la extracción de palabras clave. Eskritor AI procesará el texto, aplicando métodos NLP como el análisis de frecuencia de términos, TF-IDFy el análisis semántico (según corresponda) para identificar las palabras clave más relevantes.

Paso 4: Revisar las palabras clave extraídas

Eskritor presentará una lista (o jerarquía) de palabras clave en función de los criterios seleccionados. La pantalla puede incluir:

- Lista de palabras clave : Ordenadas por relevancia, frecuencia o en un formato jerárquico.

Consejo: Esté atento a las palabras clave que pueden necesitar fusión (por ejemplo, formas singulares frente a plurales) o eliminación (por ejemplo, términos demasiado genéricos).

Paso 5: Exportar o aplicar los resultados

Por último, exporta la lista de palabras clave o incorpórala directamente a tu flujo de trabajo:

- Opciones de exportación : Descargar en PDF, docx o HTML.

- Casos de uso : Integre en herramientas SEO , documentos de planificación de contenido, esquemas de investigación o paneles de marketing.

Consejos para una generación eficaz de palabras clave

Asegurarse de que la extracción de palabras clave sea precisa y esté alineada con sus objetivos requiere estrategia. Estas son algunas de las mejores prácticas a tener en cuenta.

1 Limpiar y preprocesar el texto

Elimine las palabras vacías, los caracteres especiales y los datos irrelevantes antes del análisis para evitar el desorden. Herramientas como NLTK (Python) o ciertos editores de texto pueden automatizar este paso de preprocesamiento.

2 Equilibra la frecuencia y la relevancia

Una palabra clave no se trata solo de cuántas veces aparece, sino también de la importancia contextual. Combine las métricas de frecuencia con el análisis semántico para lograr el equilibrio adecuado.

3 Usa una combinación de técnicas

Aproveche múltiples enfoques (TF-IDF, análisis semántico o reconocimiento de entidades con nombre) para capturar una gama más completa de palabras clave relevantes y minimizar los puntos ciegos.

4 Pruebe y perfeccione continuamente

Las tendencias de las palabras clave pueden cambiar con el tiempo, especialmente en industrias de rápido movimiento. Actualice periódicamente sus palabras clave en función de nuevos datos, métricas de rendimiento o necesidades cambiantes de la audiencia.

Conclusión: Simplifique la generación de palabras clave con AI

La generación de palabras clave efectivas es una parte fundamental de las estrategias de contenido modernas, los flujos de trabajo de investigación y las tareas de análisis de datos. AI y las herramientas impulsadas por NLPcomo Eskritor han simplificado más que nunca la extracción, el refinamiento y la exportación de palabras clave de alto valor en una fracción del tiempo que llevaría manualmente.

Al combinar múltiples técnicas (TF-IDF, análisis semántico, modelado de temas y más), obtiene una comprensión integral de lo que realmente importa en su texto. Esta información impulsa mejores resultados SEO , una investigación más enfocada y materiales de marketing atractivos. En resumen, la extracción de palabras clave basada en AIya no es opcional; Es una necesidad para los profesionales que valoran la eficiencia, la precisión y la toma de decisiones basada en datos.

location

location