Nykypäivän digitaalisessa ympäristössä kyky luoda avainsanoja tekstistä on välttämätöntä SEO, sisällöntuotannon ja akateemisen tutkimuksen kannalta. Sisältöäsi parhaiten edustavien termien ja lauseiden tunnistaminen voi parantaa hakukoneiden sijoituksia, virtaviivaistaa tutkimuspyrkimyksiä ja ohjata tehokkaita sisältöstrategioita. Nykyaikaiset edistysaskeleet luonnollisen kielen käsittelyssä avainsanojen poimimiseksi tekevät tästä prosessista yksinkertaisemman ja tarkemman kuin koskaan, ja Eskritor :n kaltaiset työkalut erottuvat erinomaisista esimerkeistä innovaatioista.

Tässä oppaassa tutkimme tekstianalyysin merkitystä avainsanojen luomisessa, perehdymme erilaisiin tekniikoihin, kuten avainsanojen termitiheysanalyysiin ja TF-IDF käyttämiseen avainsanojen poimimiseen, ja keskustelemme semanttisesta analyysistä avainsanojen luomiseksi kontekstissa. Korostamme myös parhaita työkaluja avainsanojen luomiseen tekstistä ja annamme vaiheittaisen opetusohjelman avainsanojen luomiseen.

Miksi luoda avainsanoja tekstistä?

Avainsanojen poiminta tukee erilaisia ammatillisia tehtäviä – verkkosivustojen sijoitusten parantamisesta tutkimusasiakirjojen luokitteluun. Alla on joitakin keskeisiä syitä, miksi tämä prosessi on elintärkeä nykyaikaisille sisältö- ja datastrategioille.

1 Optimoi sisältö SEO

Avainsanat muodostavat minkä tahansa tehokkaan hakukoneoptimointistrategian selkärangan. Tunnistamalla kohdeyleisösi käyttämät merkityksellisimmät termit voit optimoida blogikirjoitukset, aloitussivut ja muun verkkosisällön sijoittuaksesi korkeammalle hakutuloksissa. Tämä ei ainoastaan lisää liikennettä, vaan myös lisää käyttäjien sitoutumista sovittamalla sisältösi lukijan aikomukseen.

2 Paranna tutkimuksen tehokkuutta

Opiskelijoille, tutkijoille ja data-analyytikoille avainsanojen poiminta voi vähentää merkittävästi suurten asiakirjojen tai akateemisten papereiden seulomiseen kuluvaa aikaa. Korostamalla pääajatuksia ja terminologiaa voit nopeasti luokitella löydökset, paikantaa tärkeitä viitteitä ja jopa seurata trendejä useissa tutkimuksissa. Työkalut, kuten Google Scholar, auttavat edelleen löytämään aiheeseen liittyviä tutkimusaiheita ja artikkeleita.

3 Paranna sisältöstrategiaa

Kun ymmärrät, mitkä avainsanat resonoivat yleisösi kanssa – olivatpa ne sitten pitkähäntäisiä avainsanoja kapeille toimialoille tai laajoja termejä, joilla on suuri hakuvolyymi – voit suunnitella sisältökalenterisi tehokkaammin. Näin varmistetaan, että jokainen tuottamasi teos puhuu suoraan siitä, mitä lukijasi tai asiakkaasi etsivät, mikä viime kädessä lisää konversioita ja käyttäjätyytyväisyyttä.

4 Automatisoi manuaaliset prosessit

Takana ovat ajat, jolloin tiimien piti selata manuaalisesti sivuja ja sivuja tekstiä toistuvien teemojen ja lauseiden tunnistamiseksi. Nykyaikaiset avainsanojen poimintatyökalut säästävät aikaa ja vähentävät inhimillisiä virheitä automatisoimalla koko prosessin, jolloin voit keskittyä korkeamman tason tehtäviin, kuten strategiaan, analysointiin ja toteutukseen.

5 Nopeammat tulokset

Suurten tekstimäärien käsittely manuaalisesti on hankalaa. Eskritor kaltainen AIratkaisu voi analysoida satoja sivuja muutamassa minuutissa, jolloin voit iteroida nopeasti ja tehdä tietoon perustuvia päätöksiä nopeammin.

Yleisiä tekniikoita avainsanojen luomiseen tekstistä

Eri tekniikat vastaavat erilaisiin analyyttisiin tarpeisiin, halusitpa sitten yksinkertaisen taajuuslaskennan tai syvemmän semanttisen ymmärryksen. Tutkitaanpa yleisimmin käytettyjä menetelmiä ja sitä, miten ne auttavat poimimaan mielekkäitä avainsanoja.

1 Termitiheyden analyysi

Perustavanlaatuinen menetelmä, termitaajuus (TF), tunnistaa tekstin yleisimmin käytetyt sanat tai lauseet. Vaikka tämä lähestymistapa voi tuoda esiin ilmeisiä avainsanoja, se ei ota huomioon näiden termien ainutlaatuisuutta tai erityisyyttä useissa asiakirjoissa.

2 TF-IDF (termitaajuus – käänteinen asiakirjan taajuus)

TF-IDF tarkentaa termitiheyden perusanalyysiä ottamalla huomioon, kuinka tärkeä termi on asiakirjajoukossa. Sanat, jotka esiintyvät usein yhdessä asiakirjassa, mutta harvoin toisissa, saavat korkeammat pisteet, joten tämä tekniikka sopii erinomaisesti erikoistuneempien tai kontekstisidonnaisten avainsanojen paikantamiseen.

3 Semanttinen analyysi

Semanttinen analyysi tunnistaa asiayhteyteen liittyvät lauseet tarkastelemalla sanojen välisiä suhteita vain usein käytettyjen sanojen sijaan. Tämä on erityisen hyödyllistä, jos haluat tallentaa synonyymejä, aiheeseen liittyviä termejä tai temaattisesti linkitettyjä ideoita toistuvien sanojen sijaan, joilla ei välttämättä ole merkitystä.

4 NLP-pohjaiset lähestymistavat

Kehittyneet NLP tekniikat, kuten nimettyjen entiteettien tunnistus (NER) ja aihemallinnus, menevät pelkkää sanamäärää pidemmälle. NER tunnistaa ihmiset, paikat, organisaatiot ja muut erityiset kokonaisuudet, jotka voivat olla tärkeitä avainsanoja journalismissa tai liiketoiminta-analyysissä. Aihemallinnus paljastaa laajempia teemoja tekstissä, mikä helpottaa suurten tietomäärien luokittelua.

Parhaat työkalut avainsanojen luomiseen tekstistä

Avainsanojen poiminta voidaan tehdä käyttämällä erilaisia erikoistyökaluja ja -alustoja. Alla on katsaus joihinkin johtaviin vaihtoehtoihin, joista jokainen sopii erilaisiin käyttäjien vaatimuksiin – SEO optimoinnista kattavaan data-analyysiin.

1 Eskritor

Eskritor on edistynyt, AI-pohjainen kirjoitusalusta, joka on suunniteltu yksinkertaistamaan ja tehostamaan avainsanojen poimintaprosessia eri alojen käyttäjille – olitpa sitten optimoimassa SEOvarten, kehittämässä markkinointikampanjoita tai tekemässä akateemista tutkimusta. Valjastamalla tehokkaita luonnollisen kielen käsittelyalgoritmeja (NLP) Eskritor tunnistaa automaattisesti tekstisi tärkeät termit ja lauseet ja korostaa sekä taajuuspohjaisia avainsanoja että kontekstipohjaisia oivalluksia.

Tärkeimmät ominaisuudet

- AI-käyttöinen kirjoitustyökalu, joka on räätälöity SEO, markkinointiin ja akateemiseen käyttöön

- Yksinkertainen käyttöliittymä tekstin analysointiin ja toimivien avainsanojen luomiseen

Miksi se erottuu joukosta

- Nopeuttaa avainsana-analyysiä edistyneillä NLP algoritmeilla

- Tarjoaa mukautettavia vaihtoehtoja taajuussuodatukseen ja semanttiseen analyysiin

2 Google Keyword Planner

Digitaalisten markkinoijien peruspilari, Google Keyword Planner sovittaa ehdotetut avainsanat hakuvolyymitietoihin. Vaikka se on ensisijaisesti tarkoitettu PPC-kampanjoille, se auttaa myös sisällöntuottajia tarkentamaan aiheitaan todellisten käyttäjien kyselyiden perusteella. Integrointi Google Ads :n kanssa antaa suoran käsityksen siitä, kuinka usein tiettyjä termejä haetaan, mikä antaa sinulle etumatkaa käyttäjän aikomuksia vastaavan sisällön luomisessa.

3 MonkeyLearn

Ihanteellinen tekstianalyysiin, MonkeyLearn tarjoaa avainsanojen poiminnan tehokkaiden NLP -sovellusliittymien avulla. Se on erinomainen palautteen, arvostelujen tai sosiaalisen median keskustelun luokittelussa, mikä tekee siitä arvokkaan tunne- ja trendianalyysiin keskittyville brändeille. MonkeyLearn:n kojelauta sisältää vaihtoehtoja reaaliaikaiseen käsittelyyn, mikä tarkoittaa, että voit määrittää sen analysoimaan jatkuvasti saapuvia tietoja – täydellinen nopeatempoisille markkinointitiimeille tai asiakastukitoiminnoille.

4 R- ja Python -kirjastot

Ohjelmointiin perehtyneille käyttäjille kirjastot, kuten Tidytext (R) ja spaCy (Python), mahdollistavat syvällisen, muokattavan avainsanojen poimimisen. Voit toteuttaa TF-IDF, aihemallinnusta ja asenneanalyysiä pitkälle erikoistuneissa tai suurissa projekteissa.

Nämä kirjastot tarjoavat joustavuutta parametrien hienosäätöön tai integrointiin koneoppimiskehyksiin, mikä tekee niistä ihanteellisia datatieteilijöille tai tutkijoille, jotka tarvitsevat täysin räätälöidyn tekstianalyysiputken.

5 Semrush

Semrush on suosittu valinta SEO ammattilaisten keskuudessa, ja se yhdistää avainsanatutkimuksen kilpailuanalyysiin. Sen keskittyminen hakumäärään, vaikeuspisteisiin ja kilpailijoiden strategioihin auttaa tarkentamaan sisältösuunnitelmia maksimaalisen näkyvyyden saavuttamiseksi.

Avainsanaehdotusten lisäksi Semrush tarjoaa verkkotunnustason oivalluksia, kuten käänteisiä linkkiprofiileja ja liikenneanalytiikkaa, mikä mahdollistaa kokonaisvaltaisen lähestymistavan SEO ja digitaalisen markkinoinnin taktiikoihin.

Vaiheittainen opas avainsanojen luomiseen Eskritor

Mitä tulee yksinkertaiseen mutta tehokkaaseen avainsanojen poimimiseen, Eskritor tarjoaa erinomaisen tasapainon käytettävyyden ja edistyneiden NLP ominaisuuksien välillä. Näin saat kaiken irti sen alustasta.

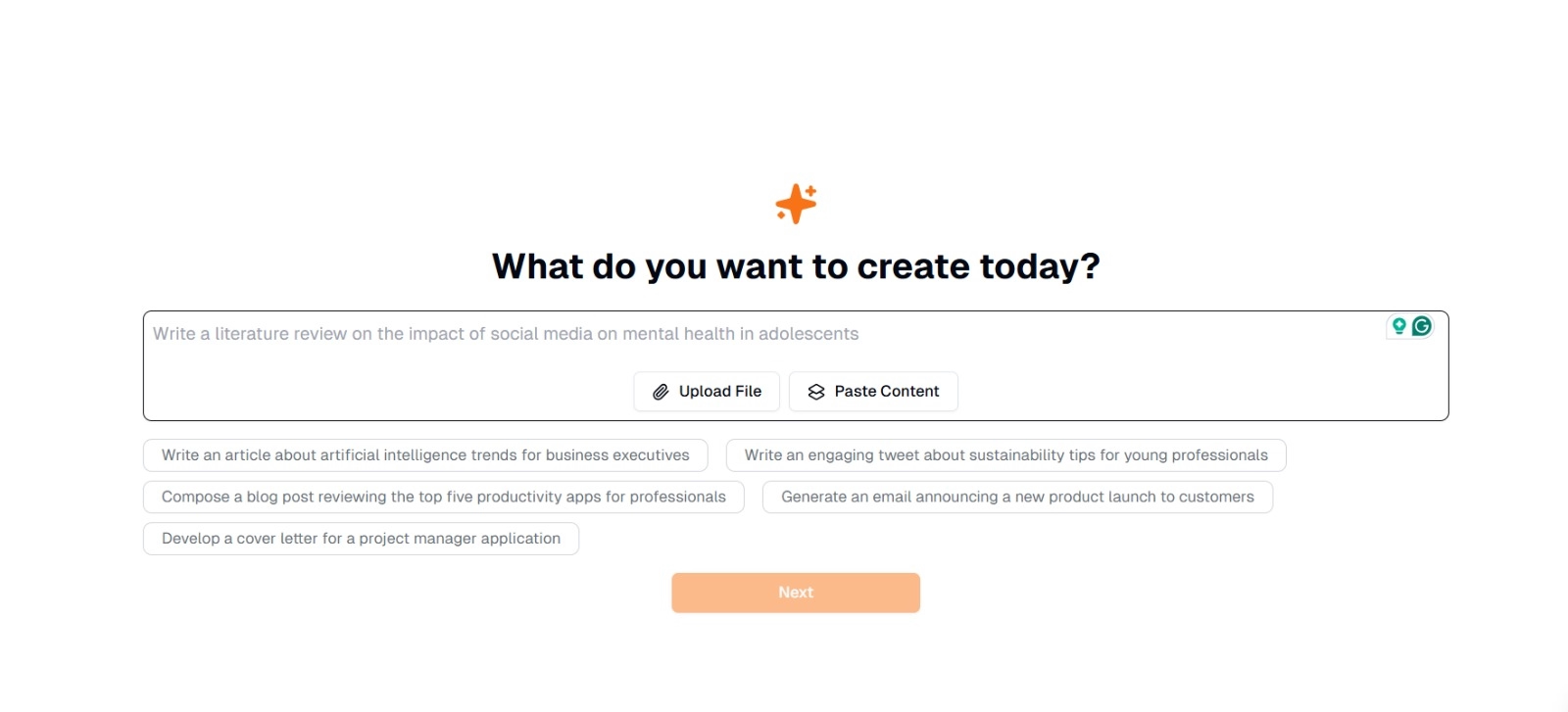

Vaihe 1: Kirjoita tai lataa teksti

Eskritorpääliittymässä näet kehotteen, jossa kysytään: "Mitä haluat luoda tänään?" Tässä sinulla on kaksi vaihtoehtoa:

- Liitä sisältö : Kopioi ja liitä tekstisi suoraan annettuun tekstiruutuun.

- Lataa tiedosto : Valitse asiakirja (esim. .docx, .pdf .txt), joka sisältää analysoitavan tekstin.

Vinkki : Voit myös valita ehdotetuista kehotteista (esim. "Kirjoita artikkeli tekoälytrendeistä..."), jos aiot luoda tai muokata tekstiä ennen poimimista.

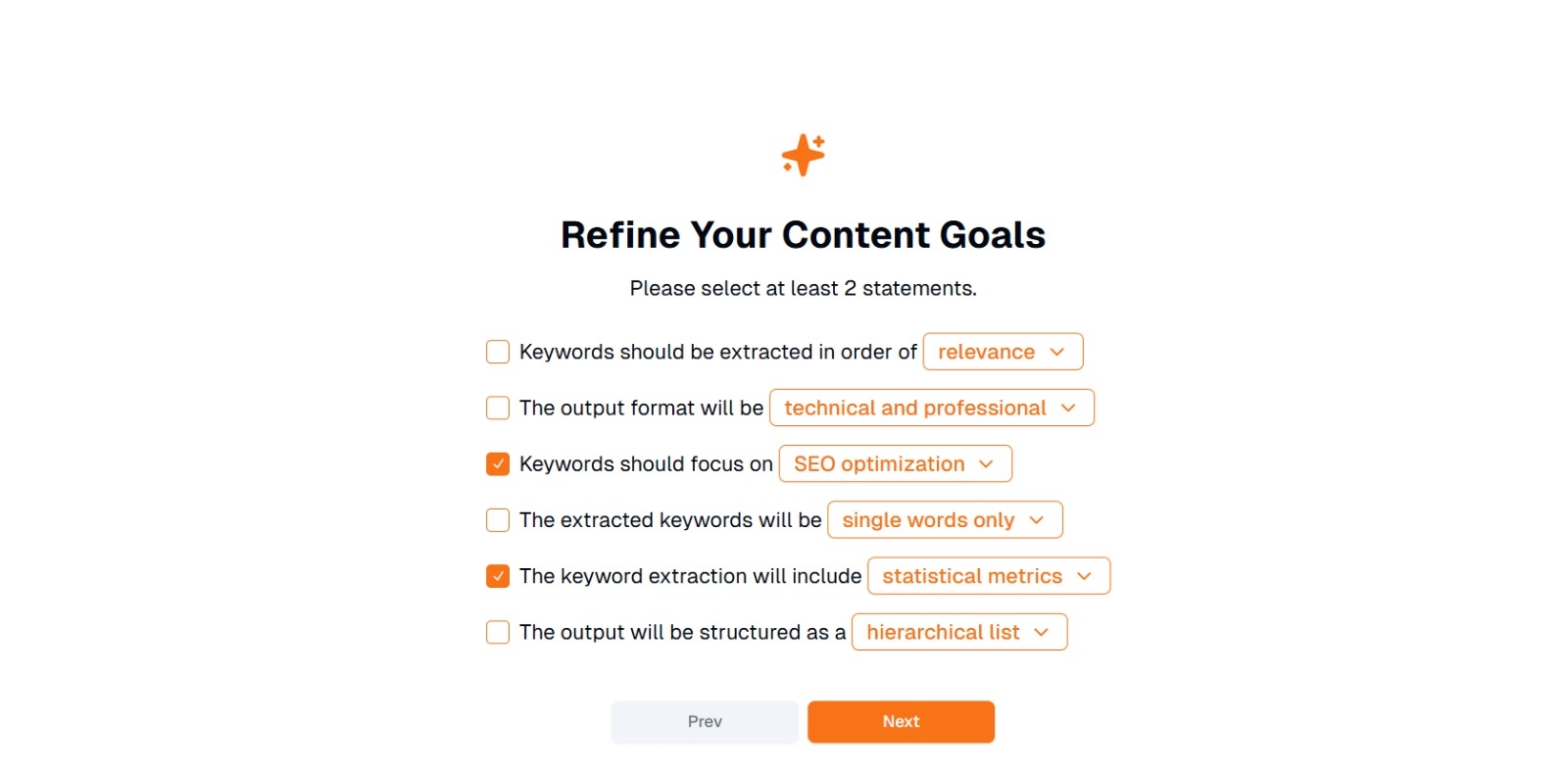

Vaihe 2: Tarkenna sisältötavoitteitasi

Saat kysymyksen " Mitä haluat tehdä tällä sisällöllä? " ja pyysi valitsemaan vähintään 2 lausuntoa . Voit myös kirjoittaa, mitä haluat tehdä keskustellaksesi Vaihtoehtoja voivat olla:

- Avainsanat tulee poimia järjestyksessä: (esim. relevanssi , esiintymistiheys , aakkosjärjestys jne.)

- Tulostusmuoto on: (esim. tekninen ja ammattimainen , rento ja ystävällinen )

- Avainsanojen tulisi keskittyä: (esim. SEO optimointi, akateeminen tutkimus, markkinoinnin näkökulmat)

- Poimitut avainsanat ovat: (esim. vain yksittäiset sanat , monisanaiset lauseet )

- Avainsanojen poiminta sisältää: (esim. tilastolliset mittarit , semanttinen ryhmittely )

- Tulos rakentuu seuraavasti: (esim. hierarkkinen luettelo , yksinkertaiset luettelomerkit )

Vinkki : Valitse lauseet, jotka vastaavat parhaiten projektisi tarpeita. Jos esimerkiksi optimoit blogikirjoituksen hakukoneita varten, harkitse SEO optimoinnin tarkistamista, vain yksittäisiä sanoja ja poimittu merkityksellisyysjärjestyksessä.

Vaihe 3: Napsauta "Seuraava" luodaksesi avainsanoja

Kun olet tarkentanut tavoitteesi ja tehnyt haluamasi valinnat, napsauta Seuraava (tai vastaava painike) aloittaaksesi avainsanan poimimisen. Eskritor AI käsittelee tekstin soveltamalla NLP menetelmiä, kuten termitiheysanalyysiä, TF-IDFja semanttista analyysiä (soveltuvin osin) tärkeimpien avainsanojen tunnistamiseksi.

Vaihe 4: Tarkista poimitut avainsanat

Eskritor esittää luettelon (tai hierarkian) avainsanoista valitsemiesi kriteerien perusteella. Näyttö voi sisältää:

- Avainsanaluettelo : Järjestetty merkityksellisyyden, tiheyden tai hierarkkisessa muodossa.

Vinkki : Varo avainsanoja, jotka saattavat vaatia yhdistämistä (esim. yksikkömuoto vs. monikkomuoto) tai poistamista (esim. liian yleiset termit).

Vaihe 5: Vie tai käytä tuloksia

Vie lopuksi avainsanaluettelo tai sisällytä se suoraan työnkulkuun:

- Vientivaihtoehdot : Lataa PDF, docx- tai HTML.

- Käyttötapaukset : Integroi SEO työkaluihin, sisällönsuunnitteluasiakirjoihin, tutkimussuunnitelmiin tai markkinoinnin kojetauluihin.

Vinkkejä tehokkaaseen avainsanojen luomiseen

Sen varmistaminen, että avainsanojen poiminta on sekä tarkkaa että tavoitteidesi mukaista, vaatii strategiaa. Tässä on joitain parhaita käytäntöjä, joita kannattaa harkita.

1 Puhdista ja esikäsittele teksti

Poista pysäytyssanat, erikoismerkit ja epäolennaiset tiedot ennen analysointia sotkun välttämiseksi. Työkalut, kuten NLTK (Python) tai tietyt tekstieditorit, voivat automatisoida tämän esikäsittelyvaiheen.

2 Tasapainon tiheys ja merkityksellisyys

Avainsanassa ei ole kyse vain siitä, kuinka monta kertaa se esiintyy, vaan myös asiayhteyteen liittyvästä tärkeydestä. Yhdistä taajuusmittarit semanttiseen analyysiin oikean tasapainon löytämiseksi.

3 Käytä erilaisia tekniikoita

Hyödynnä useita lähestymistapoja –TF-IDF, semanttista analyysiä tai nimettyjen entiteettien tunnistamista – tallentaaksesi laajemman valikoiman asiaankuuluvia avainsanoja ja minimoidaksesi sokeat pisteet.

4 Testaa ja tarkenna jatkuvasti

Avainsanatrendit voivat muuttua ajan myötä, erityisesti nopeasti muuttuvilla toimialoilla. Päivitä avainsanasi säännöllisesti uusien tietojen, tehokkuusmittareiden tai muuttuvien yleisötarpeiden perusteella.

Johtopäätös: Yksinkertaista avainsanojen luomista AI

Tehokkaiden avainsanojen luominen on keskeinen osa nykyaikaisia sisältöstrategioita, tutkimustyönkulkuja ja data-analyysitehtäviä. AI - ja NLP-pohjaiset työkalut, kuten Eskritor , ovat tehneet arvokkaiden avainsanojen poimimisesta, tarkentamisesta ja viemisestä helpompaa kuin koskaan murto-osassa siitä ajasta, joka kuluisi manuaalisesti.

Yhdistämällä useita tekniikoita –TF-IDF, semanttista analyysiä, aiheen mallintamista ja paljon muuta – saat kattavan käsityksen siitä, mikä tekstissäsi on todella tärkeää. Tämä oivallus ruokkii parempia SEO tuloksia, kohdennetumpaa tutkimusta ja kiinnostavaa markkinointimateriaalia. Lyhyesti sanottuna AI-pohjainen avainsanojen poiminta ei ole enää valinnaista; Se on välttämättömyys ammattilaisille, jotka arvostavat tehokkuutta, tarkkuutta ja tietoon perustuvaa päätöksentekoa.

Dubai, Arabiemiirikunnat

Dubai, Arabiemiirikunnat