В современном цифровом ландшафте способность генерировать ключевые слова из текста имеет важное значение для SEO, создания контента и академических исследований. Определение терминов и фраз, которые лучше всего представляют ваш контент, может улучшить рейтинг в поисковых системах, оптимизировать исследовательскую деятельность и направить эффективные контент-стратегии. Современные достижения в области обработки естественного языка для извлечения ключевых слов делают этот процесс более простым и точным, чем когда-либо, а такие инструменты, как Eskritor , выделяются как яркие примеры инноваций.

В этом руководстве мы рассмотрим важность анализа текста для генерации ключевых слов, углубимся в различные методы, включая анализ частотности терминов для ключевых слов и использование TF-IDF для извлечения ключевых слов, а также обсудим семантический анализ для создания ключевых слов в контексте. Мы также выделим лучшие инструменты для генерации ключевых слов из текста и предоставим пошаговое руководство по генерации ключевых слов.

Зачем генерировать ключевые слова из текста?

Извлечение ключевых слов лежит в основе различных профессиональных задач — от повышения рейтинга веб-сайта до категоризации исследовательских документов. Ниже приведены некоторые основные причины, по которым этот процесс жизненно важен для современных стратегий в области контента и данных.

1 Оптимизируйте контент для SEO

Ключевые слова составляют основу любой эффективной стратегии поисковой оптимизации . Определив наиболее релевантные термины, используемые вашей целевой аудиторией, вы можете оптимизировать посты в блогах, посадочные страницы и другой онлайн-контент, чтобы они занимали более высокие позиции в результатах поиска. Это не только увеличивает трафик, но и повышает вовлеченность пользователей, согласовывая ваш контент с намерениями читателя.

2 Повышение эффективности исследований

Для студентов, исследователей и аналитиков данных извлечение ключевых слов может значительно сократить время, затрачиваемое на просеивание больших документов или научных статей. Выделяя основные идеи и терминологию, вы можете быстро классифицировать результаты, находить важные ссылки и даже отслеживать тенденции в нескольких исследованиях. Подобные инструменты Google Scholar еще больше помогают в поиске связанных тем исследований и статей.

3 Улучшение контент-стратегии

Понимание того, какие ключевые слова находят отклик у вашей аудитории — будь то ключевые слова с длинным хвостом для нишевых отраслей или широкие термины с большим объемом поиска — поможет вам более эффективно планировать свой контент-календарь. Это гарантирует, что каждое произведение, которое вы создаете, напрямую связано с тем, что ищут ваши читатели или клиенты, что в конечном итоге повышает конверсию и удовлетворенность пользователей.

4 Автоматизируйте ручные процессы

Прошли те времена, когда командам приходилось вручную просматривать страницы и страницы текста, чтобы определить повторяющиеся темы и фразы. Современные инструменты извлечения ключевых слов экономят время и сокращают количество человеческих ошибок, автоматизируя весь процесс, позволяя вам сосредоточиться на задачах более высокого уровня, таких как стратегия, анализ и выполнение.

5 Более быстрые результаты

Ручная обработка больших объемов текста является трудоемкой задачей. Такое AI решение, как Eskritor , может анализировать сотни страниц за считанные минуты, что позволяет быстро выполнять итерации и быстрее принимать решения на основе данных.

Распространенные методы генерации ключевых слов из текста

Различные методы удовлетворяют различные аналитические потребности, независимо от того, хотите ли вы простого подсчета частот или более глубокого семантического понимания. Давайте рассмотрим наиболее широко используемые методы и то, как они помогают извлекать значимые ключевые слова.

1 Частотный анализ терминов

Основополагающий метод, частота терминов (TF), определяет наиболее часто используемые слова или фразы в тексте. Хотя этот подход может выявить очевидные ключевые слова, он не учитывает уникальность или специфичность этих терминов в нескольких документах.

2 TF-IDF (частота термина – обратная частота документа)

TF-IDF уточняет базовый анализ частотности терминов, учитывая важность термина в наборе документов. Слова, которые часто встречаются в одном документе, но редко встречаются в других, получают более высокую оценку, что делает этот метод отличным для выявления более специализированных или контекстно-зависимых ключевых слов.

3 Семантический анализ

Семантический анализ выявляет контекстуально релевантные фразы, изучая отношения между словами, а не только часто используемые. Это особенно полезно, если вы хотите зафиксировать синонимы, связанные термины или тематически связанные идеи, а не повторяющиеся слова, которые могут не иметь значения.

4 Подходы, основанные на NLP

Передовые методы NLP , такие как распознавание именованных сущностей (NER) и тематическое моделирование, выходят за рамки простого подсчета слов. NER идентифицирует людей, места, организации и другие конкретные объекты, которые могут быть ключевыми словами в журналистике или бизнес-анализе. Тематическое моделирование позволяет выявить более широкие темы в тексте, что упрощает категоризацию больших объемов данных.

Лучшие инструменты для генерации ключевых слов из текста

Извлечение ключевых слов может быть выполнено с помощью ряда специализированных инструментов и платформ. Ниже приведены некоторые основные варианты, каждый из которых подходит для различных требований пользователей — от оптимизации SEO до комплексного анализа данных.

1 Eskritor

Eskritor — это передовая, управляемая AIплатформа для написания текстов, предназначенная для упрощения и улучшения процесса извлечения ключевых слов для пользователей в различных областях, будь то оптимизация для SEO, разработка маркетинговых кампаний или проведение академических исследований. Используя мощные алгоритмы обработки естественного языка (NLP), Eskritor автоматически определяет ключевые термины и фразы в тексте, выделяя как ключевые слова на основе частоты, так и контекстно-ориентированные сведения.

Ключевые особенности

- AIинструмент для написания текстов, предназначенный для SEO, маркетинга и академического использования

- Простой интерфейс для анализа текста и генерации действенных ключевых слов

Чем он выделяется

- Ускоряет анализ ключевых слов с помощью передовых алгоритмов NLP

- Предлагает настраиваемые опции для частотной фильтрации и семантического анализа

2 Google Keyword Planner

Основной продукт для цифрового маркетинга, Google Keyword Planner согласовывает предлагаемые ключевые слова с данными о частоте поиска. Хотя он в первую очередь предназначен для PPC-кампаний, он также помогает создателям контента уточнять свои темы на основе реальных запросов пользователей. Интеграция с Google Ads дает прямое представление о том, как часто выполняется поиск по конкретным запросам, что дает вам преимущество в создании контента, соответствующего намерениям пользователя.

3 MonkeyLearn

Идеально подходит для анализа текста, MonkeyLearn обеспечивает извлечение ключевых слов с помощью мощных API NLP . Он отлично справляется с категоризацией отзывов, обзоров или болтовни в социальных сетях, что делает его ценным для брендов, сосредоточенных на анализе настроений и тенденций. Панель управления MonkeyLearnвключает в себя опции для обработки в режиме реального времени, что означает, что вы можете настроить ее для непрерывного анализа входящих данных, что идеально подходит для быстро меняющихся маркетинговых команд или операций поддержки клиентов.

4 Библиотеки R и Python

Для пользователей, которые хорошо разбираются в программировании, такие библиотеки, как Tidytext (R) и spaCy (Python) обеспечивают углубленное, настраиваемое извлечение ключевых слов. Вы можете реализовать TF-IDF, тематическое моделирование и анализ тональности для узкоспециализированных или крупномасштабных проектов.

Эти библиотеки обеспечивают гибкость для тонкой настройки параметров или интеграции с платформами машинного обучения, что делает их идеальными для специалистов по обработке и анализу данных или исследователей, которым требуется полностью настраиваемый конвейер анализа текста.

5 Semrush

Популярный выбор среди SEO профессионалов, Semrush сочетает в себе исследование ключевых слов с конкурентным анализом. Его акцент на частоте поиска, оценках сложности и стратегиях конкурентов помогает уточнить контент-планы для максимальной видимости.

Помимо предложений по ключевым словам, Semrush предоставляет информацию на уровне домена, такую как профили обратных ссылок и аналитика трафика, что позволяет использовать целостный подход к тактике SEO и цифрового маркетинга.

Пошаговое руководство по генерации ключевых слов с помощью Eskritor

Когда дело доходит до простого, но эффективного извлечения ключевых слов, Eskritor предлагает отличный баланс между удобством использования и расширенными функциями NLP . Вот как извлечь максимальную пользу из его платформы.

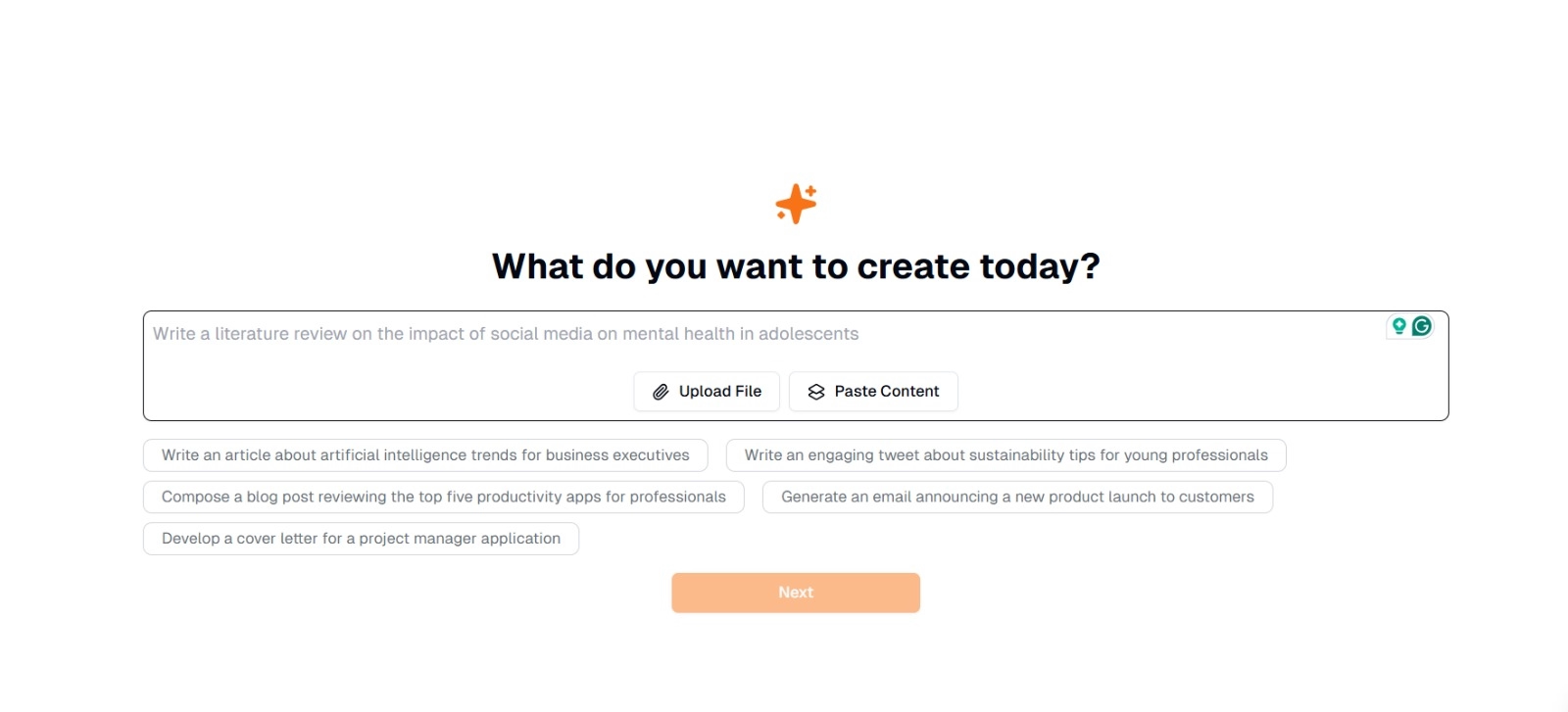

Шаг 1: Введите или загрузите свой текст

В главном интерфейсе Eskritorвы увидите подсказку с вопросом: «Что вы хотите создать сегодня?» Здесь у вас есть два варианта:

- Вставить содержимое : Скопируйте и вставьте свой текст непосредственно в указанное текстовое поле.

- Загрузить файл : Выберите документ (например, .docx, .pdf, .txt), который содержит текст, который вы хотите проанализировать.

Совет : Вы также можете выбрать один из предложенных запросов (например, «Напишите статью о тенденциях в области искусственного интеллекта...»), если планируете генерировать или перерабатывать текст перед извлечением.

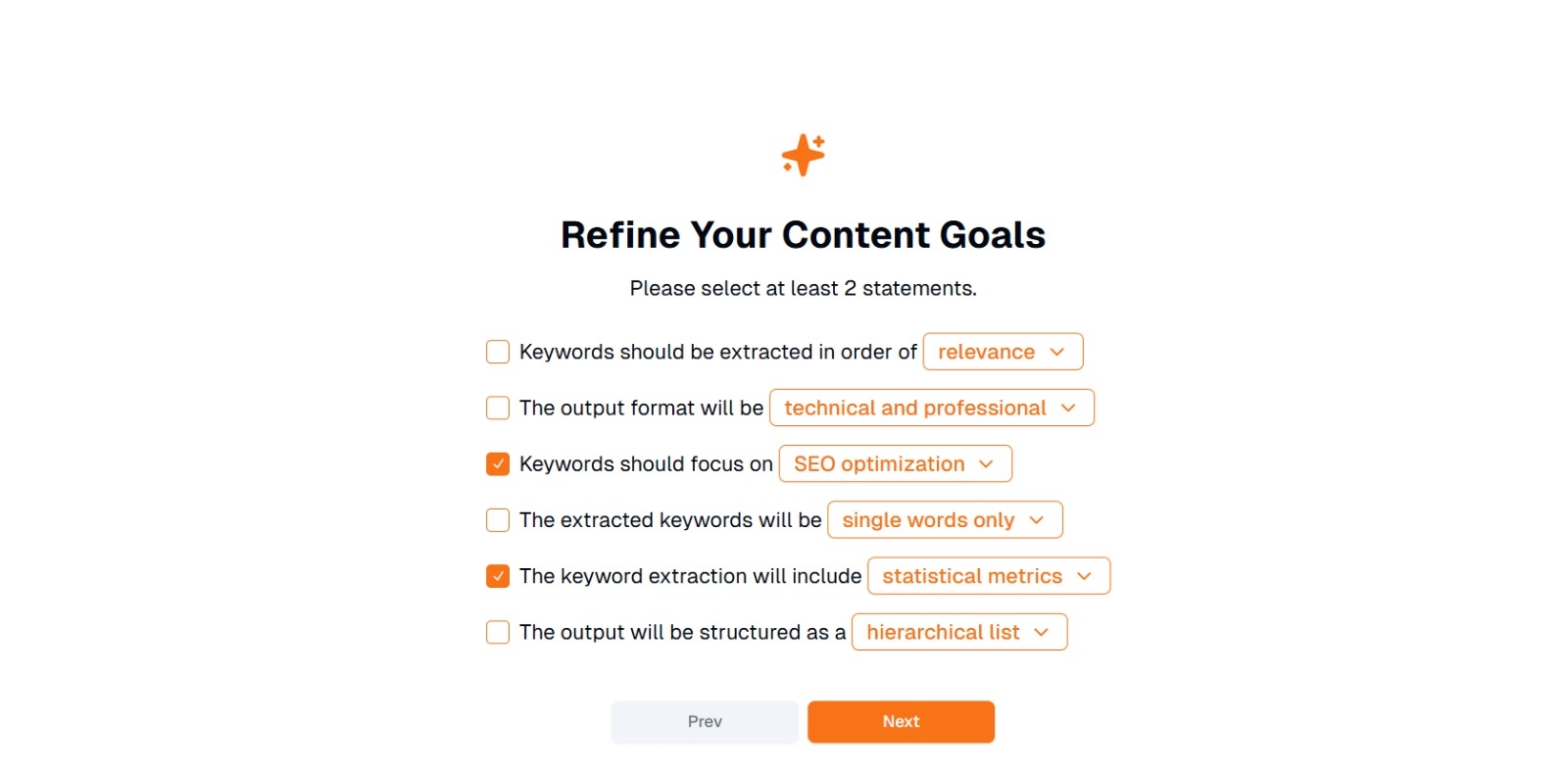

Шаг 2: Уточните цели по контенту

Вам будет предложено « Что вы хотите сделать с этим контентом? и попросили выбрать не менее 2 утверждений . Кроме того, вы можете написать, что хотите сделать в чате. Варианты могут включать:

- Ключевые слова должны быть выделены в следующем порядке: (например, релевантность , частотность , алфавит и т. д.)

- Формат вывода будет следующим: (например, технический и профессиональный , повседневный и дружелюбный )

- Ключевые слова должны быть сосредоточены на: (например, оптимизацияSEO, академические исследования, маркетинговые аспекты)

- Извлеченные ключевые слова будут следующими: (например, только отдельные слова , фразы из нескольких слов )

- Извлечение ключевых слов будет включать: (например, статистические метрики , семантическую группировку )

- Вывод будет структурирован следующим образом: (например, иерархический список , простые маркированные списки )

Совет : Выберите выписки, которые наилучшим образом соответствуют потребностям вашего проекта. Например, если вы оптимизируете сообщение в блоге для поисковых систем, рассмотрите возможность проверки SEO оптимизацию , только отдельные слова и извлеченные в порядке релевантности.

Шаг 3: Нажмите «Далее» для генерации ключевых слов

Уточнив свои цели и сделав желаемый выбор, нажмите «Далее» (или аналогичную кнопку), чтобы начать извлечение ключевых слов. AI Eskritorбудет обрабатывать текст, применяя NLP методы, такие как частотный анализ терминов, TF-IDFи семантический анализ (в зависимости от обстоятельств) для определения наиболее релевантных ключевых слов.

Шаг 4: Просмотрите извлеченные ключевые слова

Eskritor представит список (или иерархию) ключевых слов на основе выбранных вами критериев. Дисплей может включать:

- Список ключевых слов : Упорядочен по релевантности, частоте или в иерархическом формате.

Совет : Обратите внимание на ключевые слова, которые могут нуждаться в объединении (например, формы единственного и множественного числа) или удалении (например, слишком общие термины).

Шаг 5: Экспортируйте или примените результаты

Наконец, экспортируйте список ключевых слов или включите его непосредственно в свой рабочий процесс:

- Параметры экспорта : Скачать в PDF, docx или HTML.

- Примеры использования : интеграция с инструментами SEO , документами по планированию контента, планами исследований или маркетинговыми панелями.

Советы по эффективной генерации ключевых слов

Чтобы убедиться, что извлечение ключевых слов является точным и соответствует вашим целям, требуется стратегия. Вот несколько рекомендаций, которые следует учитывать.

1 Очистка и предварительная обработка текста

Удалите стоп-слова, специальные символы и нерелевантные данные перед анализом, чтобы избежать беспорядка. Такие инструменты, как NLTK (Python) или некоторые текстовые редакторы могут автоматизировать этот этап предварительной обработки.

2 Баланс частоты и актуальности

Ключевое слово — это не только количество появлений, но и контекстуальная важность. Объедините частотные метрики с семантическим анализом, чтобы найти правильный баланс.

3 Используйте сочетание техник

Используйте несколько подходов —TF-IDF, семантический анализ или распознавание именованных сущностей — для захвата более полного диапазона релевантных ключевых слов и минимизации слепых зон.

4 Непрерывное тестирование и совершенствование

Тенденции ключевых слов могут меняться со временем, особенно в быстро развивающихся отраслях. Регулярно обновляйте ключевые слова на основе новых данных, показателей эффективности или меняющихся потребностей аудитории.

Вывод: упростите генерацию ключевых слов с помощью AI

Генерация эффективных ключевых слов является ключевой частью современных контент-стратегий, исследовательских рабочих процессов и задач анализа данных. AI и NLPинструменты, такие как Eskritor , упростили извлечение, уточнение и экспорт ценных ключевых слов в разы быстрее, чем это потребовалось бы вручную.

Комбинируя несколько методов —TF-IDF, семантический анализ, тематическое моделирование и многое другое — вы получаете всестороннее понимание того, что действительно важно в вашем тексте. Это понимание способствует улучшению SEO результатов, более целенаправленным исследованиям и привлекательным маркетинговым материалам. Короче говоря, извлечение ключевых слов на основе AIбольше не является необязательным; Это необходимо для профессионалов, которые ценят эффективность, точность и принятие решений на основе данных.

Дубай, ОАЭ

Дубай, ОАЭ