I dagens digitala landskap är förmågan att generera nyckelord från text avgörande för SEO, innehållsskapande och akademisk forskning. Genom att identifiera de termer och fraser som bäst representerar ditt innehåll kan du förbättra sökmotorernas rankning, effektivisera forskningsarbetet och vägleda effektiva innehållsstrategier. Moderna framsteg inom naturlig språkbehandling för extraktion av nyckelord gör denna process enklare och mer exakt än någonsin, med verktyg som Eskritor som sticker ut som främsta exempel på innovation.

I den här guiden kommer vi att utforska vikten av textanalys för att generera nyckelord, fördjupa oss i olika tekniker – inklusive termfrekvensanalys för nyckelord och användning av TF-IDF för nyckelordsextraktion och diskutera semantisk analys för att generera nyckelord i sitt sammanhang. Vi kommer också att lyfta fram de bästa verktygen för att generera nyckelord från text och ge en steg-för-steg-handledning för generering av nyckelord.

Varför generera nyckelord från text?

Extraktion av nyckelord ligger till grund för en mängd olika professionella uppgifter – från att förbättra webbplatsrankningen till att kategorisera forskningsdokument. Nedan följer några viktiga skäl till varför denna process är avgörande för moderna innehålls- och datastrategier.

1 Optimera innehåll för SEO

Nyckelord utgör ryggraden i alla effektiva sökmotoroptimeringsstrategier . Genom att identifiera de mest relevanta termerna som används av din målgrupp kan du optimera blogginlägg, landningssidor och annat onlineinnehåll så att de rankas högre i sökresultaten. Detta ökar inte bara trafiken utan förbättrar också användarnas engagemang genom att anpassa ditt innehåll till läsarens avsikt.

2 Förbättra forskningens effektivitet

För studenter, forskare och dataanalytiker kan nyckelordsextraktion avsevärt minska den tid som går åt till att sålla igenom stora dokument eller akademiska uppsatser. Genom att lyfta fram de viktigaste idéerna och terminologin kan du snabbt kategorisera resultat, hitta viktiga referenser och till och med spåra trender i flera studier. Verktyg som Google Scholar ytterligare hjälpa till att upptäcka relaterade forskningsämnen och artiklar.

3 Förbättra innehållsstrategin

Att förstå vilka sökord som resonerar med din publik – oavsett om det är långa sökord för nischade branscher eller breda termer med höga sökvolymer – hjälper dig att planera din innehållskalender mer effektivt. Detta säkerställer att varje artikel du producerar talar direkt till vad dina läsare eller kunder söker efter, vilket i slutändan ökar konverteringarna och användarnöjdheten.

4 Automatisera manuella processer

Borta är de dagar då team var tvungna att manuellt skumma igenom sidor och sidor med text för att identifiera återkommande teman och fraser. Moderna verktyg för extraktion av nyckelord sparar tid och minskar mänskliga fel genom att automatisera hela processen, så att du kan fokusera på uppgifter på högre nivå som strategi, analys och genomförande.

5 Snabbare resultat

Att bearbeta stora mängder text manuellt är besvärligt. En AI lösning som Eskritor kan analysera hundratals sidor på bara några minuter, vilket gör att du kan iterera snabbt och fatta datadrivna beslut snabbare.

Vanliga tekniker för att generera nyckelord från text

Olika tekniker tillgodoser olika analytiska behov, oavsett om du vill ha en enkel frekvensräkning eller en djupare semantisk förståelse. Låt oss utforska de mest använda metoderna och hur de hjälper till att extrahera meningsfulla nyckelord.

1 Analys av termfrekvens

En grundläggande metod, Term Frequency (TF), identifierar de vanligaste orden eller fraserna i en text. Även om den här metoden kan visa uppenbara nyckelord, tar den inte hänsyn till unikheten eller specificiteten för dessa termer i flera dokument.

2 TF-IDF (Termfrekvens–Inverterad dokumentfrekvens)

TF-IDF förfinar grundläggande termfrekvensanalys genom att ta hänsyn till hur viktig en term är i en uppsättning dokument. Ord som förekommer ofta i ett dokument men sällan i andra får högre poäng, vilket gör den här tekniken utmärkt för att hitta mer specialiserade eller kontextspecifika nyckelord.

3 Semantisk analys

Semantisk analys identifierar kontextuellt relevanta fraser genom att undersöka relationerna mellan ord snarare än bara ofta använda. Detta är särskilt användbart om du vill fånga synonymer, relaterade termer eller tematiskt kopplade idéer i stället för repetitiva ord som kanske inte har betydelse.

4 NLP-baserade tillvägagångssätt

Avancerade NLP tekniker som Named Entity Recognition (NER) och ämnesmodellering går längre än enkla ordräkningar. NER identifierar personer, platser, organisationer och andra specifika enheter, som kan vara avgörande nyckelord inom journalistik eller affärsanalys. Ämnesmodellering visar bredare teman i en text, vilket gör det enklare att kategorisera stora mängder data.

Bästa verktygen för att generera nyckelord från text

Extraktion av nyckelord kan göras med hjälp av en rad specialiserade verktyg och plattformar. Nedan följer en titt på några ledande alternativ, var och en anpassad för olika användarkrav – från SEO optimering till omfattande dataanalys.

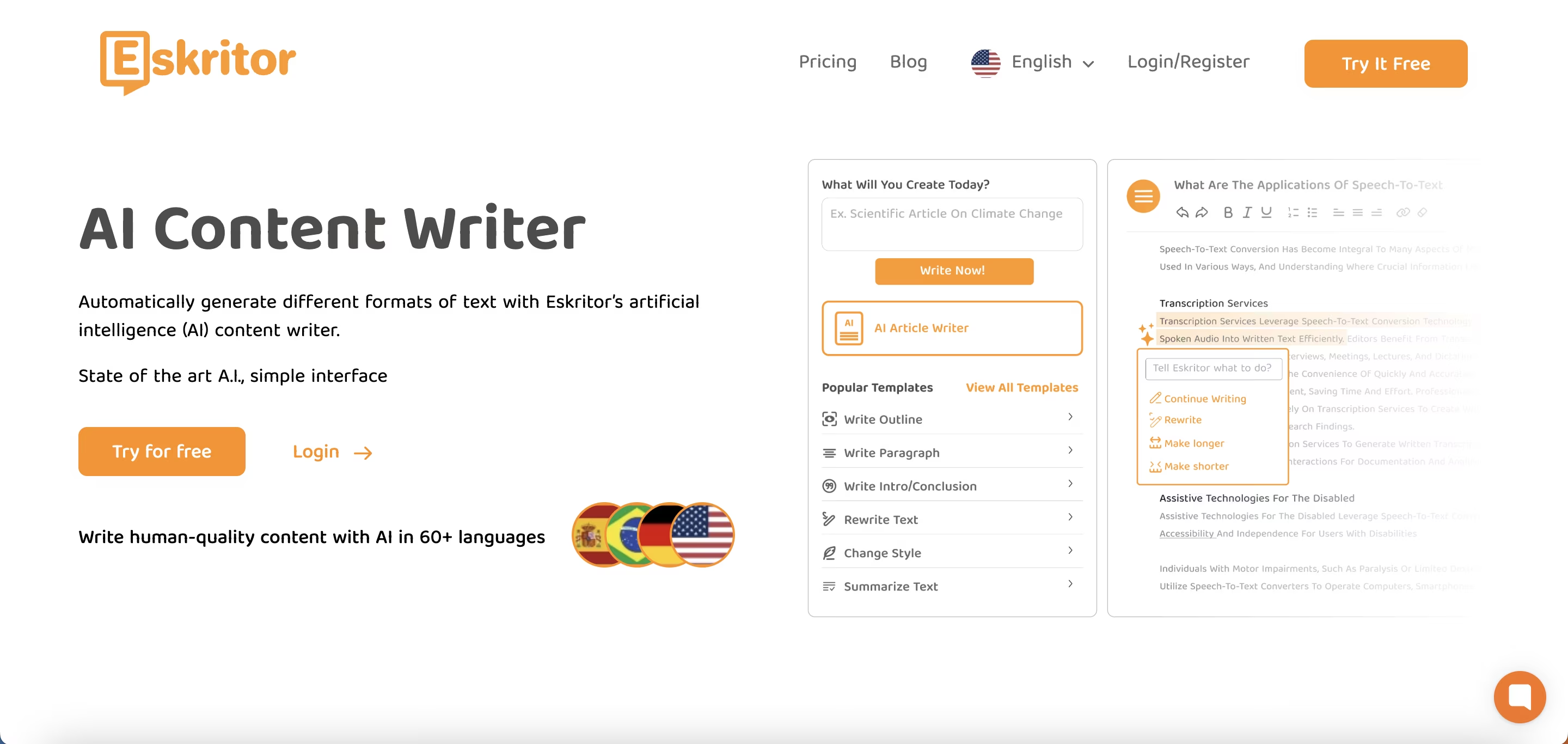

1 Eskritor

Eskritor är en avancerad, AI-driven skrivplattform som är utformad för att förenkla och förbättra processen för att extrahera nyckelord för användare inom olika områden – oavsett om du optimerar för SEO, utvecklar marknadsföringskampanjer eller bedriver akademisk forskning. Genom att utnyttja kraftfulla algoritmer för behandling av naturligt språk (NLP) identifierar Eskritor automatiskt viktiga termer och fraser i din text och lyfter fram både frekvensbaserade nyckelord och kontextdrivna insikter.

Viktiga funktioner

- AI-drivet skrivverktyg skräddarsytt för SEO, marknadsföring och akademiskt bruk

- Enkelt gränssnitt för att analysera text och generera användbara nyckelord

Varför den sticker ut

- Snabbar upp sökordsanalys med avancerade NLP algoritmer

- Erbjuder anpassningsbara alternativ för frekvensfiltrering och semantisk analys

2 Google Keyword Planner

Google Keyword Planner är en viktig fråga för digitala marknadsförare och anpassar föreslagna sökord till sökvolymdata. Även om det främst är för PPC-kampanjer, hjälper det också innehållsskapare att förfina sina ämnen baserat på riktiga användarfrågor. Integrationen med Google Ads ger direkta insikter om hur ofta specifika termer söks, vilket ger dig ett försprång när det gäller att skapa innehåll som matchar användarens avsikt.

3 MonkeyLearn

MonkeyLearn är idealisk för textanalys och tillhandahåller extrahering av nyckelord med hjälp av kraftfulla NLP API:er. Den utmärker sig när det gäller att kategorisera feedback, recensioner eller prat i sociala medier, vilket gör den värdefull för varumärken som fokuserar på sentiment- och trendanalys. MonkeyLearn:s instrumentpanel innehåller alternativ för realtidsbearbetning, vilket innebär att du kan ställa in den för att kontinuerligt analysera inkommande data – perfekt för snabba marknadsföringsteam eller kundsupportverksamhet.

4 R- och Python -biblioteken

För användare som är bekväma med programmering möjliggör bibliotek som Tidytext (R) och spaCy (Python) djupgående, anpassningsbar nyckelordsextraktion. Du kan implementera TF-IDF, ämnesmodellering och sentimentanalys för mycket specialiserade eller storskaliga projekt.

Dessa bibliotek erbjuder flexibiliteten att finjustera parametrar eller integrera med ramverk för maskininlärning, vilket gör dem idealiska för datavetare eller forskare som behöver en helt skräddarsydd textanalyspipeline.

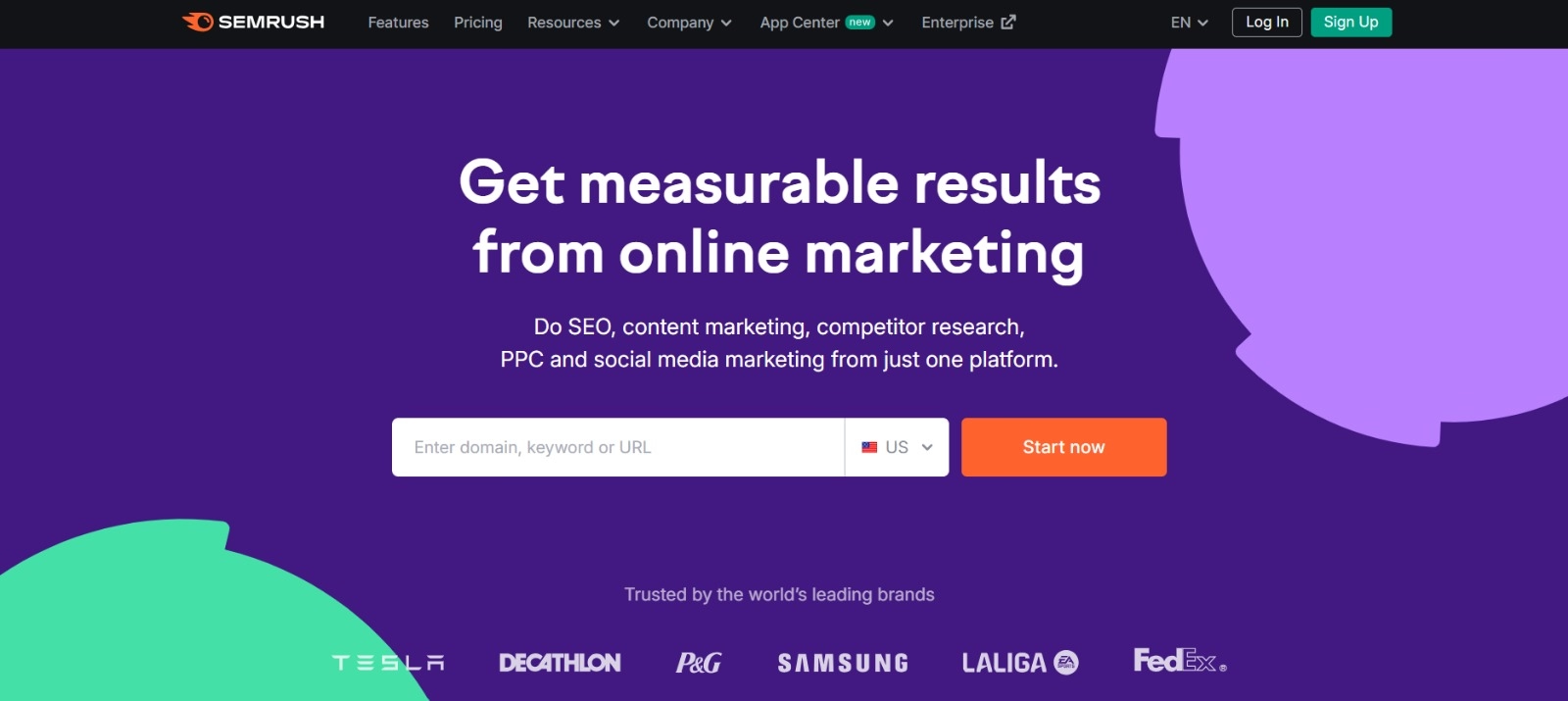

5 Semrush

Semrush är ett populärt val bland SEO proffs och kombinerar sökordsforskning med konkurrensanalys. Dess fokus på sökvolym, svårighetspoäng och konkurrentstrategier hjälper till att förfina innehållsplaner för maximal synlighet.

Utöver sökordsförslag ger Semrush insikter på domännivå, såsom bakåtlänksprofiler och trafikanalys, vilket möjliggör ett helhetsgrepp på SEO och digital marknadsföringstaktik.

Steg-för-steg-guide för att generera sökord med Eskritor

När det kommer till enkel men kraftfull extraktion av nyckelord erbjuder Eskritor en utmärkt balans mellan användbarhet och avancerade NLP funktioner. Så här får du ut det mesta av dess plattform.

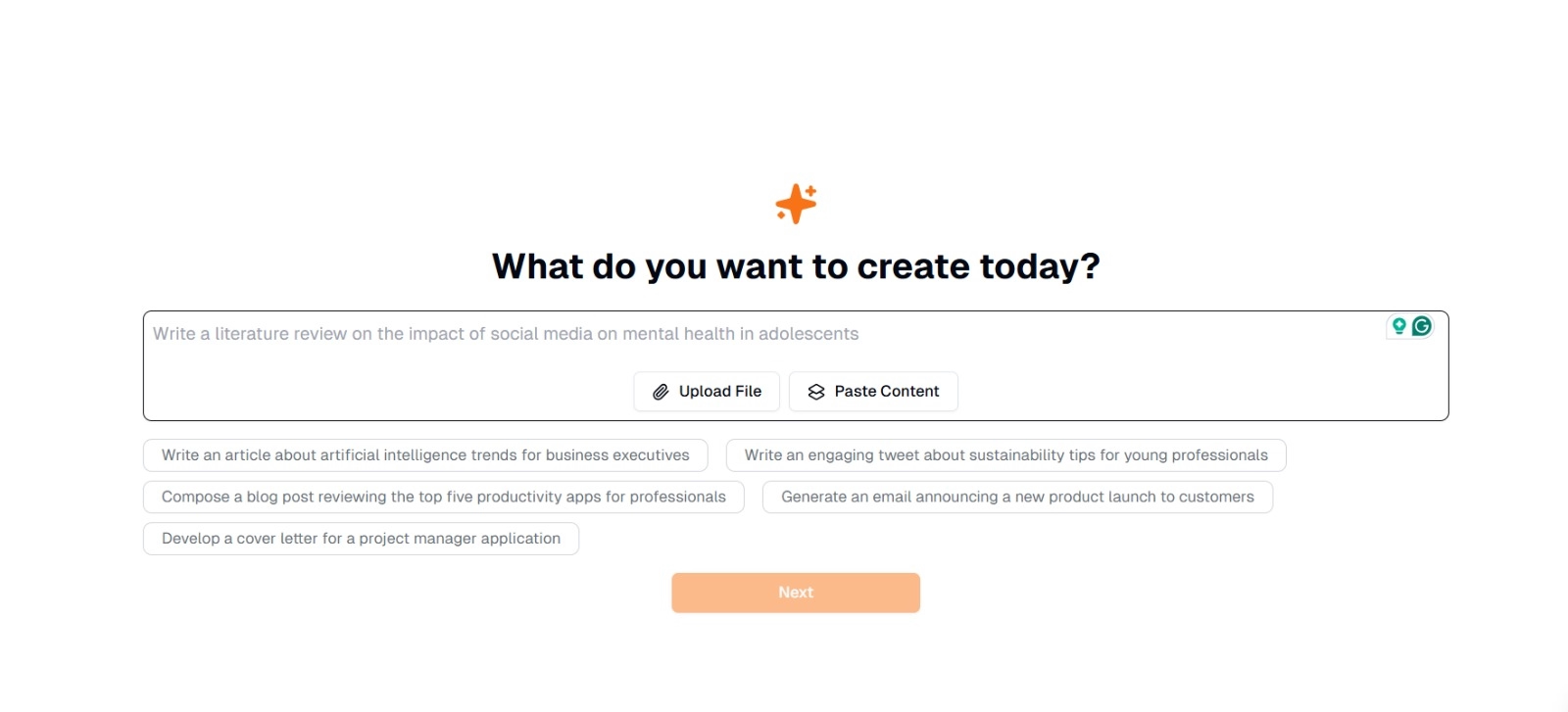

Steg 1: Skriv eller ladda upp din text

På Eskritors huvudgränssnitt kommer du att se en uppmaning som frågar: "Vad vill du skapa idag?" Här har du två alternativ:

- Klistra in innehåll : Kopiera och klistra in din text direkt i den angivna textrutan.

- Ladda upp fil : Välj ett dokument (t.ex. .docx, .pdf, .txt) som innehåller den text du vill analysera.

Tips : Du kan också välja bland föreslagna uppmaningar (t.ex. "Skriv en artikel om trender inom artificiell intelligens...") om du planerar att generera eller omarbeta text före extrahering.

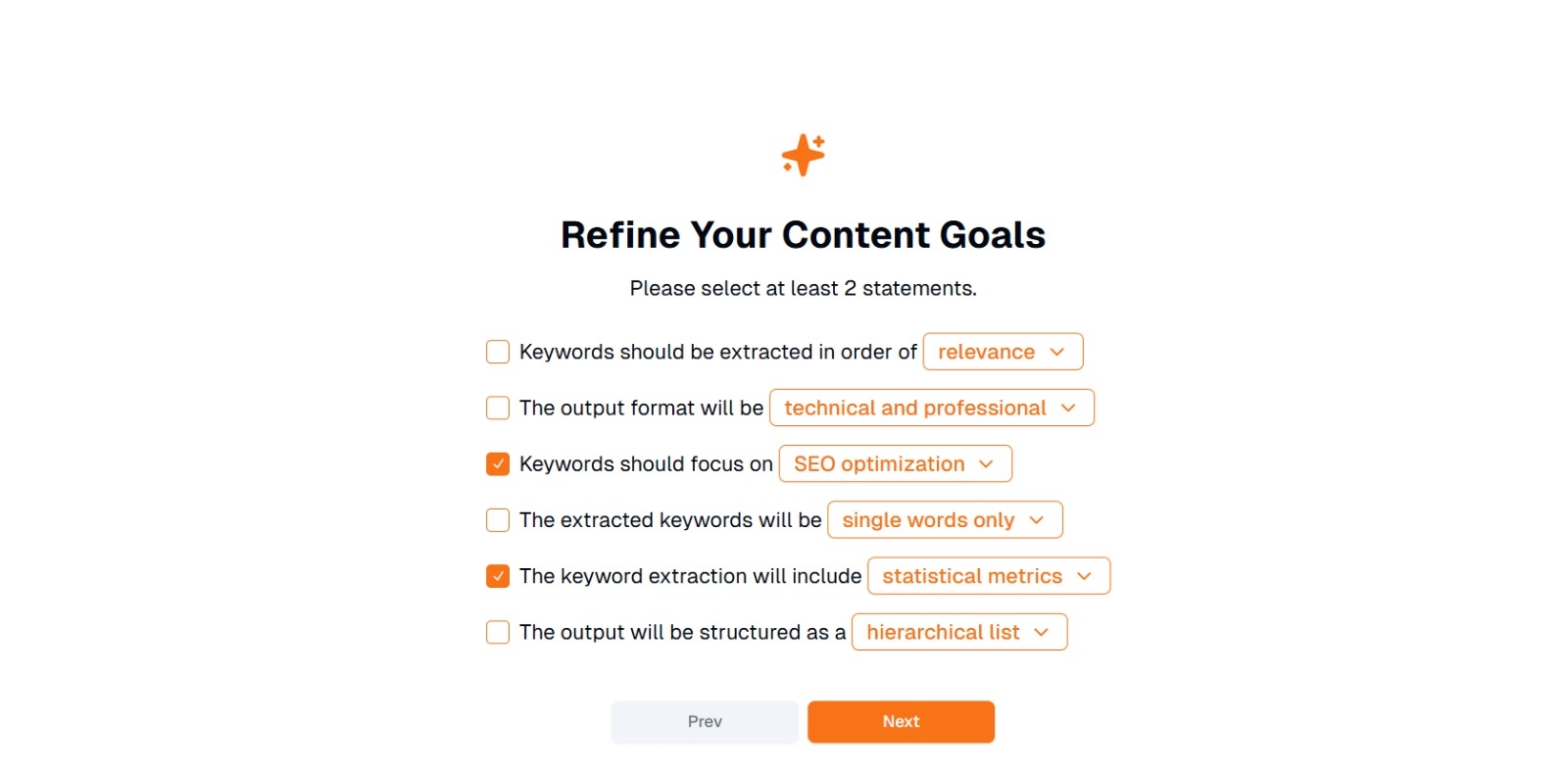

Steg 2: Förfina dina innehållsmål

Du kommer att bli tillfrågad med " Vad vill du göra med det här innehållet? " och ombads att välja minst 2 uttalanden . Du kan också skriva vad du vill göra för att chatta. Alternativen kan vara:

- Nyckelord ska extraheras i ordning efter: (t.ex. relevans , frekvens , alfabetisk , etc.)

- Utdataformatet kommer att vara: (t.ex. tekniskt och professionellt , avslappnat och vänligt )

- Nyckelord bör fokusera på: (t.ex. SEO optimering, akademisk forskning, marknadsföringsvinklar)

- De extraherade nyckelorden kommer att vara: (t.ex. endast enstaka ord , fraser med flera ord )

- Extraheringen av nyckelord kommer att innehålla: (t.ex. statistiska mätvärden , semantisk gruppering )

- Utdata kommer att struktureras som: (t.ex. en hierarkisk lista , enkla punkter )

Tips : Välj de uttalanden som bäst matchar ditt projekts behov. Om du till exempel optimerar ett blogginlägg för sökmotorer kan du överväga att kontrolleraSEO optimering , endast enstaka ord och extraherade i relevansordning .

Steg 3: Klicka på "Nästa" för att generera sökord

När du har förfinat dina mål och gjort önskade val klickar du på Nästa (eller en liknande knapp) för att påbörja extraheringen av nyckelord. Eskritors AI kommer att bearbeta texten och tillämpa NLP metoder som termfrekvensanalys, TF-IDFoch semantisk analys (beroende på vad som är tillämpligt) för att identifiera de mest relevanta nyckelorden.

Steg 4: Granska de extraherade nyckelorden

Eskritor kommer att presentera en lista (eller hierarki) med nyckelord baserat på de kriterier du har valt. Visningen kan innehålla:

- Nyckelordslista : Ordnad efter relevans, frekvens eller i ett hierarkiskt format.

Tips : Håll utkik efter nyckelord som kan behöva slås samman (t.ex. singular vs. plural former) eller tas bort (t.ex. alltför generiska termer).

Steg 5: Exportera eller tillämpa resultaten

Exportera slutligen nyckelordslistan eller införliva den direkt i ditt arbetsflöde:

- Exportalternativ : Ladda ner i PDF, docx eller HTML.

- Användningsfall : Integrera i SEO verktyg, innehållsplaneringsdokument, forskningsöversikter eller marknadsföringsinstrumentpaneler.

Tips för effektiv sökordsgenerering

Det krävs strategi för att se till att din utvinning av nyckelord är både korrekt och anpassad till dina mål. Här är några metodtips att tänka på.

1 Rensa och förbearbeta texten

Ta bort stoppord, specialtecken och irrelevanta data före analys för att undvika röran. Verktyg som NLTK (Python) eller vissa textredigerare kan automatisera detta förbearbetningssteg.

2 Balansera frekvens och relevans

Ett nyckelord handlar inte bara om hur många gånger det förekommer – det handlar också om kontextuell betydelse. Kombinera frekvensmått med semantisk analys för att hitta rätt balans.

3 Använd en blandning av tekniker

Utnyttja flera metoder –TF-IDF, semantisk analys eller igenkänning av namngivna enheter – för att fånga ett större utbud av relevanta nyckelord och minimera blinda fläckar.

4 Testa och förfina kontinuerligt

Nyckelordstrender kan förändras över tid, särskilt i snabbrörliga branscher. Uppdatera dina sökord regelbundet baserat på ny data, resultatstatistik eller nya målgruppsbehov.

Slutsats: Förenkla genereringen av nyckelord med AI

Att generera effektiva nyckelord är en central del av moderna innehållsstrategier, forskningsarbetsflöden och dataanalysuppgifter. AI och NLP-drivna verktyg som Eskritor har gjort det enklare än någonsin att extrahera, förfina och exportera värdefulla sökord på en bråkdel av den tid det skulle ta manuellt.

Genom att kombinera flera tekniker –TF-IDF, semantisk analys, ämnesmodellering med mera – får du en omfattande förståelse för vad som verkligen är viktigt i din text. Denna insikt ger bättre SEO resultat, mer fokuserad forskning och engagerande marknadsföringsmaterial. Kort sagt, AI-baserad nyckelordsextraktion är inte längre valfri; Det är en nödvändighet för proffs som värdesätter effektivitet, precision och datadrivet beslutsfattande.

Dubai, Förenade Arabemiraten

Dubai, Förenade Arabemiraten