W dzisiejszym krajobrazie cyfrowym możliwość generowania słów kluczowych z tekstu jest niezbędna do SEO, tworzenia treści i badań akademickich. Zidentyfikowanie terminów i fraz, które najlepiej reprezentują Twoje treści, może poprawić rankingi w wyszukiwarkach, usprawnić wysiłki badawcze i pokierować skutecznymi strategiami dotyczącymi treści. Nowoczesne postępy w przetwarzaniu języka naturalnego do ekstrakcji słów kluczowych sprawiają, że proces ten jest prostszy i dokładniejszy niż kiedykolwiek, a narzędzia takie jak Eskritor wyróżniają się jako najlepsze przykłady innowacji.

W tym przewodniku omówimy znaczenie analizy tekstu dla generowania słów kluczowych, zagłębimy się w różne techniki, w tym analizę częstotliwości wyrażeń dla słów kluczowych i używanie TF-IDF do wyodrębniania słów kluczowych, a także omówimy analizę semantyczną do generowania słów kluczowych w kontekście. Wyróżnimy również najlepsze narzędzia do generowania słów kluczowych z tekstu i przedstawimy samouczek krok po kroku dotyczący generowania słów kluczowych.

Po co generować słowa kluczowe z tekstu?

Wyodrębnianie słów kluczowych stanowi podstawę wielu zadań zawodowych — od poprawy rankingów witryn internetowych po kategoryzację dokumentów badawczych. Poniżej znajduje się kilka głównych powodów, dla których ten proces ma kluczowe znaczenie dla nowoczesnych strategii dotyczących treści i danych.

1 Zoptymalizuj zawartość pod kątem SEO

Słowa kluczowe stanowią podstawę każdej skutecznej strategii optymalizacji pod kątem wyszukiwarek . Identyfikując najtrafniejsze terminy używane przez grupę docelową, możesz zoptymalizować posty na blogu, strony docelowe i inne treści online, aby uzyskać wyższą pozycję w wynikach wyszukiwania. To nie tylko zwiększa ruch, ale także zwiększa zaangażowanie użytkowników, dostosowując treść do intencji czytelnika.

2 Zwiększ efektywność badań

W przypadku studentów, badaczy i analityków danych wyodrębnianie słów kluczowych może znacznie skrócić czas spędzony na przeglądaniu dużych dokumentów lub prac naukowych. Podkreślając główne idee i terminologię, możesz szybko kategoryzować wyniki, lokalizować ważne odniesienia, a nawet śledzić trendy w wielu badaniach. Narzędzia takie jak Google Scholar dodatkowo pomagają w odkrywaniu powiązanych tematów badawczych i artykułów.

3 Popraw strategię treści

Zrozumienie, które słowa kluczowe rezonują z odbiorcami – niezależnie od tego, czy są to słowa kluczowe z długiego ogona dla branż niszowych, czy ogólne terminy o dużej liczbie wyszukiwań – pomaga skuteczniej planować kalendarz treści. Dzięki temu każdy wyprodukowany przez Ciebie element przemawia bezpośrednio do tego, czego szukają Twoi czytelnicy lub klienci, co ostatecznie zwiększa konwersje i satysfakcję użytkowników.

4 Automatyzacja procesów ręcznych

Dawno minęły czasy, kiedy zespoły musiały ręcznie przeglądać strony i strony tekstu, aby zidentyfikować powtarzające się motywy i frazy. Nowoczesne narzędzia do ekstrakcji słów kluczowych oszczędzają czas i redukują błędy ludzkie, automatyzując cały proces, co pozwala skupić się na zadaniach wyższego poziomu, takich jak strategia, analiza i realizacja.

5 Szybsze wyniki

Ręczne przetwarzanie dużych ilości tekstu jest kłopotliwe. Rozwiązanie AI , takie jak Eskritor , może przeanalizować setki stron w ciągu zaledwie kilku minut, umożliwiając szybką iterację i szybsze podejmowanie decyzji opartych na danych.

Typowe techniki generowania słów kluczowych z tekstu

Różne techniki zaspokajają różne potrzeby analityczne, niezależnie od tego, czy zależy Ci na prostym zliczaniu częstotliwości, czy na głębszym zrozumieniu semantyki. Przyjrzyjmy się najczęściej używanym metodom i temu, jak pomagają one wyodrębnić znaczące słowa kluczowe.

1 Termiczna analiza częstości

Podstawowa metoda, Częstotliwość terminów (TF), identyfikuje najczęściej używane słowa lub frazy w tekście. Chociaż takie podejście może ujawnić oczywiste słowa kluczowe, nie uwzględnia unikatowości ani szczegółowości tych terminów w wielu dokumentach.

2 TF-IDF (częstotliwość terminów – odwrotna częstotliwość dokumentu)

TF-IDF uściśla podstawową analizę częstości występowania terminów, biorąc pod uwagę, jak ważny jest termin w zestawie dokumentów. Słowa, które często pojawiają się w jednym dokumencie, ale rzadko w innych, otrzymują wyższy wynik, dzięki czemu ta technika doskonale nadaje się do wskazywania bardziej specjalistycznych lub kontekstowych słów kluczowych.

3 Analiza semantyczna

Analiza semantyczna identyfikuje kontekstowo istotne frazy, badając relacje między słowami, a nie tylko często używanymi. Jest to szczególnie przydatne, jeśli chcesz uchwycić synonimy, powiązane terminy lub tematycznie powiązane pomysły, a nie powtarzające się słowa, które mogą nie mieć znaczenia.

4 Podejścia oparte na NLP

Zaawansowane techniki NLP , takie jak rozpoznawanie jednostek nazwanych (NER) i modelowanie tematów, wykraczają poza proste liczenie słów. NER identyfikuje osoby, miejsca, organizacje i inne konkretne podmioty, które mogą być kluczowymi słowami kluczowymi w dziennikarstwie lub analizie biznesowej. Modelowanie tematów ujawnia szersze tematy w tekście, co ułatwia kategoryzowanie dużych ilości danych.

Najlepsze narzędzia do generowania słów kluczowych z tekstu

Ekstrakcja słów kluczowych może odbywać się za pomocą szeregu specjalistycznych narzędzi i platform. Poniżej znajduje się kilka wiodących opcji, z których każda jest dostosowana do różnych wymagań użytkowników — od optymalizacji SEO po kompleksową analizę danych.

1 Eskritor

Eskritor to zaawansowana, oparta na AIplatforma do pisania, zaprojektowana w celu uproszczenia i ulepszenia procesu wyodrębniania słów kluczowych dla użytkowników z różnych dziedzin — niezależnie od tego, czy optymalizujesz pod kątem SEO, opracowujesz kampanie marketingowe, czy prowadzisz badania naukowe. Wykorzystując potężne algorytmy przetwarzania języka naturalnego (NLP Eskritor automatycznie identyfikuje kluczowe terminy i frazy w tekście, podkreślając zarówno słowa kluczowe oparte na częstotliwości, jak i spostrzeżenia oparte na kontekście.

Kluczowe cechy

- AInarzędzie do pisania dostosowane do zastosowań SEO, marketingowych i akademickich

- Prosty interfejs do analizy tekstu i generowania użytecznych słów kluczowych

Dlaczego się wyróżnia

- Przyspiesza analizę słów kluczowych dzięki zaawansowanym algorytmom NLP

- Oferuje konfigurowalne opcje filtrowania częstotliwości i analizy semantycznej

2 Google Keyword Planner

Podstawa dla marketerów cyfrowych, Google Keyword Planner dopasowuje sugerowane słowa kluczowe do danych o liczbie wyszukiwań. Chociaż jest przeznaczony głównie do kampanii PPC, pomaga również twórcom treści doprecyzować ich tematy w oparciu o rzeczywiste zapytania użytkowników. Integracja z Google Ads zapewnia bezpośredni wgląd w to, jak często wyszukiwane są określone hasła, co daje przewagę w tworzeniu treści dopasowanych do intencji użytkownika.

3 MonkeyLearn

Idealny do analizy tekstu, MonkeyLearn zapewnia ekstrakcję słów kluczowych przy użyciu zaawansowanych interfejsów API NLP . Doskonale nadaje się do kategoryzowania opinii, recenzji lub rozmów w mediach społecznościowych, dzięki czemu jest cenny dla marek koncentrujących się na analizie sentymentu i trendów. Pulpit nawigacyjny MonkeyLearnzawiera opcje przetwarzania w czasie rzeczywistym, co oznacza, że można go skonfigurować tak, aby stale analizował przychodzące dane — idealne rozwiązanie dla szybko rozwijających się zespołów marketingowych lub operacji obsługi klienta.

4 Biblioteki języka R i Python

Dla użytkowników zaznajomionych z programowaniem biblioteki takie jak Tidytext (R) i spaCy (Python) umożliwiają dogłębną, konfigurowalną ekstrakcję słów kluczowych. Możesz zaimplementować TF-IDF, modelowanie tematów i analizę tonacji dla wysoce wyspecjalizowanych lub dużych projektów.

Biblioteki te oferują elastyczność w zakresie dostosowywania parametrów lub integracji z platformami uczenia maszynowego, dzięki czemu są idealne dla analityków danych lub badaczy wymagających w pełni dostosowanego potoku analizy tekstu.

5 Semrush

Popularny wybór wśród SEO profesjonalistów, Semrush łączy badanie słów kluczowych z analizą konkurencji. Skupienie się na liczbie wyszukiwań, wynikach trudności i strategiach konkurencji pomaga udoskonalić plany treści w celu uzyskania maksymalnej widoczności.

Oprócz sugestii słów kluczowych, Semrush zapewnia wgląd na poziomie domeny, taki jak profile linków zwrotnych i analiza ruchu, umożliwiając holistyczne podejście do SEO i taktyk marketingu cyfrowego.

Przewodnik krok po kroku dotyczący generowania słów kluczowych za pomocą Eskritor

Jeśli chodzi o proste, ale potężne wyodrębnianie słów kluczowych, oferuje Eskritor doskonałą równowagę między użytecznością a zaawansowanymi funkcjami NLP . Oto jak w pełni wykorzystać jego platformę.

Krok 1: Wprowadź lub prześlij swój tekst

W głównym interfejsie Eskritorzobaczysz monit z pytaniem: "Co chcesz dzisiaj stworzyć?" Tutaj masz dwie opcje:

- Wklej treść : Skopiuj i wklej tekst bezpośrednio do danego pola tekstowego.

- Prześlij plik : Wybierz dokument (np. .docx, .pdf .txt), który zawiera tekst, który chcesz przeanalizować.

Wskazówka : Możesz również wybrać jeden z sugerowanych podpowiedzi (np. "Napisz artykuł o trendach sztucznej inteligencji..."), jeśli planujesz wygenerować lub przerobić tekst przed wyodrębnieniem.

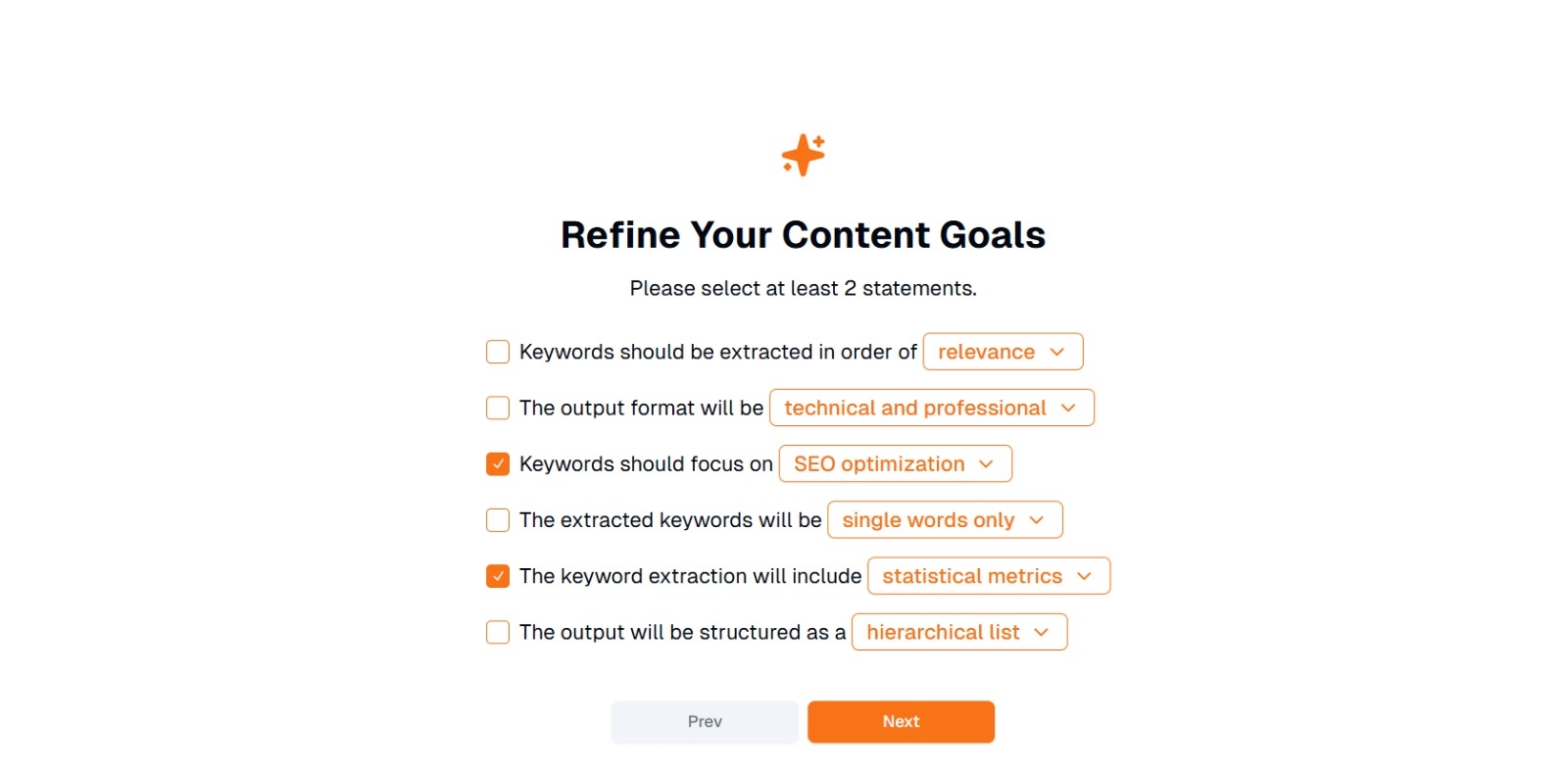

Krok 2: Doprecyzuj swoje cele dotyczące treści

Zostanie wyświetlony monit " Co chcesz zrobić z tą zawartością? " i poproszono o wybranie co najmniej 2 stwierdzeń . Możesz także napisać, co chcesz zrobić, aby porozmawiać. Dostępne opcje mogą obejmować:

- Słowa kluczowe powinny być wyodrębniane w kolejności: (np. trafność , częstotliwość , alfabetycznie itp.)

- Format wyjściowy będzie następujący: (np. techniczny i profesjonalny , swobodny i przyjazny )

- Słowa kluczowe powinny koncentrować się na: (np. optymalizacjiSEO, badaniach naukowych, kątach marketingowych )

- Wyodrębnione słowa kluczowe to: (np. tylko pojedyncze słowa , frazy wielowyrazowe )

- Ekstrakcja słów kluczowych będzie obejmować: (np. metryki statystyczne , grupowanie semantyczne )

- Dane wyjściowe będą ustrukturyzowane w następujący sposób: (np. hierarchiczna lista , proste wypunktowania )

Wskazówka : Wybierz stwierdzenia, które najlepiej pasują do potrzeb Twojego projektu. Na przykład, jeśli optymalizujesz wpis na blogu pod kątem wyszukiwarek, rozważ sprawdzenie optymalizacjiSEO , tylko pojedyncze słowa i wyodrębnione w kolejności trafności .

Krok 3: Kliknij "Dalej", aby wygenerować słowa kluczowe

Po doprecyzowaniu celów i dokonaniu żądanych wyborów kliknij przycisk Dalej (lub podobny przycisk), aby rozpocząć wyodrębnianie słów kluczowych. Eskritor AI przetworzy tekst, stosując metody NLP , takie jak analiza częstotliwości terminów, TF-IDFi analiza semantyczna (w stosownych przypadkach), aby zidentyfikować najbardziej odpowiednie słowa kluczowe.

Krok 4: Przejrzyj wyodrębnione słowa kluczowe

Eskritor przedstawi listę (lub hierarchię) słów kluczowych na podstawie wybranych kryteriów. Na wyświetlaczu mogą znajdować się:

- Lista słów kluczowych : uporządkowana według trafności, częstotliwości lub w formacie hierarchicznym.

Wskazówka : Zwróć uwagę na słowa kluczowe, które mogą wymagać scalenia (np. formy liczby pojedynczej lub mnogiej) lub usunięcia (np. zbyt ogólne terminy).

Krok 5: Eksportuj lub zastosuj wyniki

Na koniec wyeksportuj listę słów kluczowych lub włącz ją bezpośrednio do swojego przepływu pracy:

- Opcje eksportu : Pobierz w formacie PDF, docx lub HTML.

- Przypadki użycia : Zintegruj z narzędziami SEO , dokumentami planowania treści, konspektami badań lub pulpitami marketingowymi.

Wskazówki dotyczące skutecznego generowania słów kluczowych

Upewnienie się, że wyodrębnianie słów kluczowych jest zarówno dokładne, jak i zgodne z Twoimi celami, wymaga strategii. Oto kilka sprawdzonych metod, które warto wziąć pod uwagę.

1 Wyczyść i wstępnie przetwórz tekst

Usuń słowa zatrzymujące, znaki specjalne i nieistotne dane przed analizą, aby uniknąć bałaganu. Narzędzia takie jak NLTK (Python) lub niektóre edytory tekstu mogą zautomatyzować ten etap wstępnego przetwarzania.

2 Równowaga między częstotliwością a trafnością

Słowo kluczowe to nie tylko to, ile razy się pojawi, ale także znaczenie kontekstowe. Połącz wskaźniki częstotliwości z analizą semantyczną, aby osiągnąć właściwą równowagę.

3 Stosuj różne techniki

Wykorzystaj wiele podejść —TF-IDF, analizę semantyczną lub rozpoznawanie nazw jednostek — aby uchwycić pełniejszy zakres odpowiednich słów kluczowych i zminimalizować martwe punkty.

4 Ciągłe testowanie i udoskonalanie

Trendy słów kluczowych mogą się zmieniać w czasie, zwłaszcza w szybko rozwijających się branżach. Regularnie aktualizuj słowa kluczowe na podstawie nowych danych, wskaźników skuteczności lub zmieniających się potrzeb odbiorców.

Wniosek: uprość generowanie słów kluczowych za pomocą AI

Generowanie skutecznych słów kluczowych jest kluczową częścią nowoczesnych strategii treści, przepływów pracy badawczej i zadań związanych z analizą danych. Narzędzia oparte na AI i NLP, takie jak Eskritor, sprawiły, że wyodrębnianie, udoskonalanie i eksportowanie słów kluczowych o wysokiej wartości jest prostsze niż kiedykolwiek, w ułamku czasu, który zajęłoby ręczne wyszukiwanie.

Łącząc wiele technik —TF-IDF, analizę semantyczną, modelowanie tematyczne i wiele innych — zyskujesz kompleksowe zrozumienie tego, co naprawdę liczy się w Twoim tekście. Ten wgląd napędza lepsze wyniki SEO , bardziej ukierunkowane badania i angażujące materiały marketingowe. Krótko mówiąc, ekstrakcja słów kluczowych na podstawie AInie jest już opcjonalna; To konieczność dla profesjonalistów, którzy cenią sobie efektywność, precyzję i podejmowanie decyzji w oparciu o dane.

Dubaj, Zjednoczone Emiraty Arabskie

Dubaj, Zjednoczone Emiraty Arabskie