V dnešním digitálním prostředí je schopnost generovat klíčová slova z textu zásadní pro SEO, tvorbu obsahu a akademický výzkum. Identifikace výrazů a frází, které nejlépe reprezentují váš obsah, může zlepšit hodnocení ve vyhledávačích, zefektivnit výzkumné úsilí a vést efektivní obsahové strategie. Díky moderním pokrokům ve zpracování přirozeného jazyka pro extrakci klíčových slov je tento proces jednodušší a přesnější než kdy dříve, přičemž nástroje jako Eskritor vynikají jako ukázkové příklady inovací.

V této příručce se budeme zabývat významem analýzy textu pro generování klíčových slov, ponoříme se do různých technik – včetně analýzy četnosti termínů pro klíčová slova a použití TF-IDF pro extrakci klíčových slov a probereme sémantickou analýzu pro generování klíčových slov v kontextu. Zdůrazníme také nejlepší nástroje pro generování klíčových slov z textu a poskytneme podrobný návod na generování klíčových slov.

Proč generovat klíčová slova z textu?

Extrakce klíčových slov je základem řady profesionálních úkolů – od zlepšování hodnocení webových stránek až po kategorizaci výzkumných dokumentů. Níže uvádíme některé hlavní důvody, proč je tento proces životně důležitý pro moderní strategie obsahu a dat.

1 Optimalizace obsahu pro SEO

Klíčová slova tvoří páteř každé efektivní strategie optimalizace pro vyhledávače . Identifikací nejrelevantnějších výrazů používaných vaší cílovou skupinou můžete optimalizovat příspěvky na blogu, vstupní stránky a další online obsah tak, aby se ve výsledcích vyhledávání umístily na vyšších pozicích. To nejen zvyšuje návštěvnost, ale také zvyšuje zapojení uživatelů tím, že sladí váš obsah se záměrem čtenáře.

2 Zvýšení efektivity výzkumu

Pro studenty, výzkumné pracovníky a datové analytiky může extrakce klíčových slov výrazně zkrátit čas strávený procházením rozsáhlých dokumentů nebo akademických prací. Zvýrazněním hlavních myšlenek a terminologie můžete rychle kategorizovat zjištění, najít důležité odkazy a dokonce sledovat trendy ve více studiích. Nástroje jako Google Scholar dále pomáhají při objevování souvisejících výzkumných témat a článků.

3 Zlepšení obsahové strategie

Pochopení toho, která klíčová slova rezonují s vaším publikem – ať už se jedná o dlouhá klíčová slova pro specializovaná odvětví nebo široké výrazy s vysokým objemem vyhledávání – vám pomůže efektivněji plánovat kalendář obsahu. Tím je zajištěno, že každý váš článek přímo odpovídá tomu, co vaši čtenáři nebo zákazníci hledají, což v konečném důsledku zvyšuje konverze a spokojenost uživatelů.

4 Automatizujte manuální procesy

Pryč jsou doby, kdy týmy musely ručně procházet stránky a stránky textu, aby identifikovaly opakující se témata a fráze. Moderní nástroje pro extrakci klíčových slov šetří čas a snižují lidské chyby tím, že automatizují celý proces, což vám umožní soustředit se na úkoly na vyšší úrovni, jako je strategie, analýza a provedení.

5 Rychlejší výsledky

Ruční zpracování velkých objemů textu je těžkopádné. Řešení AI , jako je Eskritor , dokáže analyzovat stovky stránek během několika minut, což vám umožní rychle iterovat a rychleji přijímat rozhodnutí na základě dat.

Běžné techniky pro generování klíčových slov z textu

Různé techniky vyhovují různým analytickým potřebám, ať už chcete jednoduchý počet frekvencí nebo hlubší sémantické porozumění. Pojďme se podívat na nejpoužívanější metody a na to, jak pomáhají extrahovat smysluplná klíčová slova.

1 Term Frequency Analysis

Základní metoda, Term Frequency (TF), identifikuje nejčastěji používaná slova nebo fráze v textu. I když tento přístup může zobrazit zřejmá klíčová slova, nezohledňuje jedinečnost nebo specifičnost těchto výrazů ve více dokumentech.

2 TF-IDF (frekvence termínu – inverzní frekvence dokumentu)

TF-IDF zpřesňuje základní analýzu frekvence termínů tím, že zohledňuje, jak důležitý je termín v sadě dokumentů. Slova, která se často vyskytují v jednom dokumentu, ale zřídka v jiných, získávají vyšší skóre, takže tato technika je vynikající pro určení specializovanějších nebo kontextově specifických klíčových slov.

3 Sémantická analýza

Sémantická analýza identifikuje kontextově relevantní fráze zkoumáním vztahů mezi slovy, nikoli pouze mezi často používanými slovy. To je užitečné zejména v případě, že chcete zachytit synonyma, související termíny nebo tematicky propojené myšlenky spíše než opakující se slova, která nemusí mít význam.

4 Přístupy založené na NLP

Pokročilé techniky NLP , jako je rozpoznávání pojmenovaných entit (NER) a modelování témat, jdou nad rámec jednoduchého počtu slov. NER identifikuje lidi, místa, organizace a další specifické entity, které mohou být klíčovými klíčovými slovy v žurnalistice nebo obchodní analýze. Modelování témat odhaluje širší témata v textu, což usnadňuje kategorizaci velkých objemů dat.

Nejlepší nástroje pro generování klíčových slov z textu

Extrakci klíčových slov lze provést pomocí řady specializovaných nástrojů a platforem. Níže je uveden pohled na některé hlavní možnosti, z nichž každá je vhodná pro různé požadavky uživatelů – od optimalizace SEO až po komplexní analýzu dat.

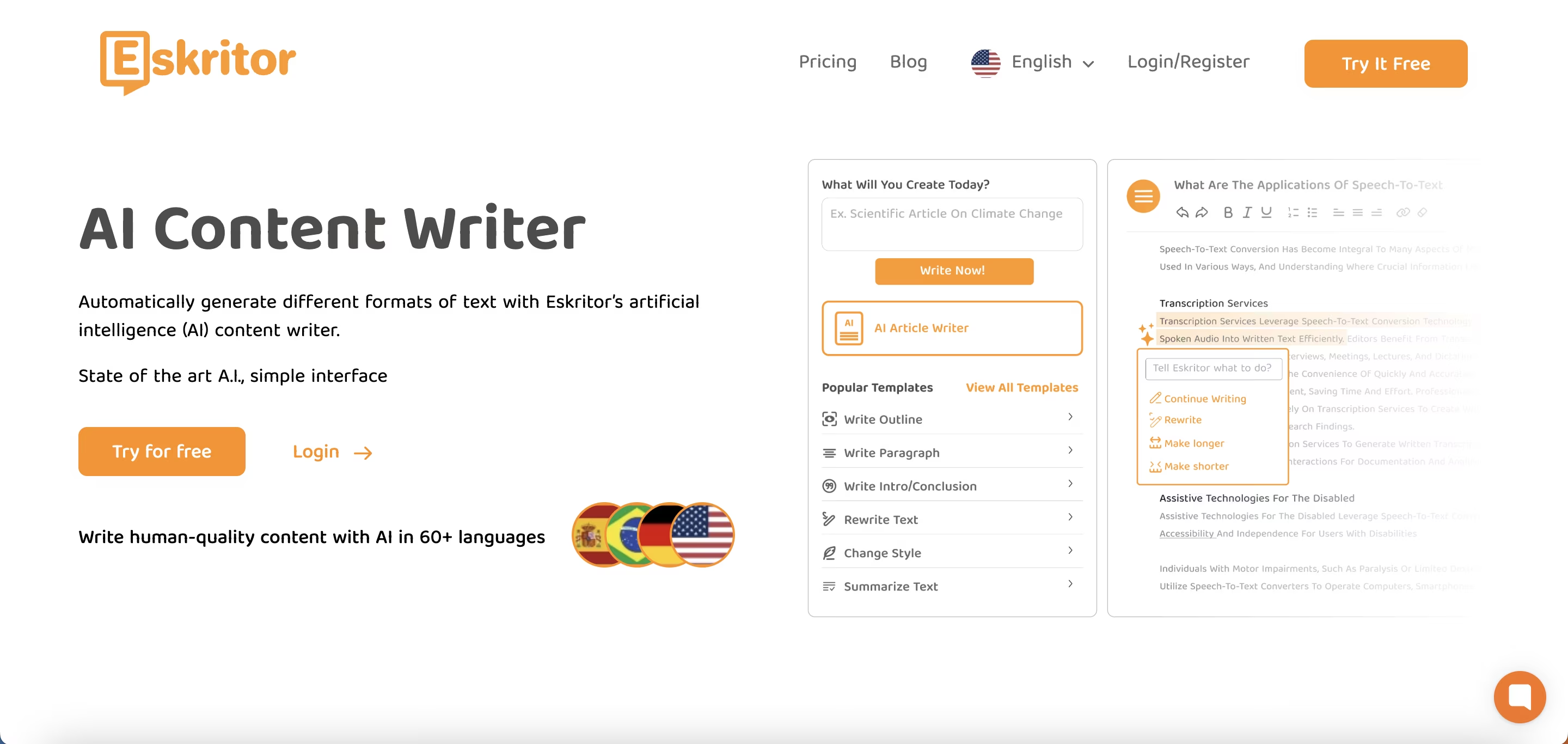

1 Eskritor

Eskritor je pokročilá platforma pro psaní založená na AInavržená tak, aby zjednodušila a vylepšila proces extrakce klíčových slov pro uživatele v různých oblastech – ať už optimalizujete pro SEO, vyvíjíte marketingové kampaně nebo provádíte akademický výzkum. Díky využití výkonných algoritmů zpracování přirozeného jazyka (NLP) Eskritor automaticky identifikuje klíčové termíny a fráze ve vašem textu, přičemž zvýrazní jak klíčová slova založená na frekvenci, tak kontextové poznatky.

Klíčové vlastnosti

- AIpsací nástroj přizpůsobený pro SEO, marketing a akademické použití

- Jednoduché rozhraní pro analýzu textu a generování klíčových slov

V čem vyniká

- Urychluje analýzu klíčových slov pomocí pokročilých algoritmů NLP

- Nabízí přizpůsobitelné možnosti frekvenčního filtrování a sémantické analýzy

2 Google Keyword Planner

Základem pro digitální marketéry je Google Keyword Planner sladí navrhovaná klíčová slova s údaji o objemu vyhledávání. I když je primárně určen pro PPC kampaně, pomáhá také tvůrcům obsahu upřesnit jejich témata na základě skutečných uživatelských dotazů. Integrace s Google Ads poskytuje přímý přehled o tom, jak často jsou konkrétní výrazy vyhledávány, což vám dává náskok při vytváření obsahu, který odpovídá záměrům uživatele.

3 MonkeyLearn

Ideální pro analýzu textu, MonkeyLearn poskytuje extrakci klíčových slov pomocí výkonných rozhraní API NLP . Vyniká v kategorizaci zpětné vazby, recenzí nebo chatování na sociálních sítích, takže je cenný pro značky zaměřené na analýzu sentimentu a trendů. Řídicí panel MonkeyLearnobsahuje možnosti pro zpracování v reálném čase, což znamená, že jej můžete nastavit tak, aby nepřetržitě analyzoval příchozí data – ideální pro rychlé marketingové týmy nebo operace zákaznické podpory.

4 Knihovny R a Python

Pro uživatele, kteří jsou spokojeni s programováním, knihovny jako Tidytext (R) a spaCy (Python) umožňují hloubkovou a přizpůsobitelnou extrakci klíčových slov. Můžete implementovat TF-IDF, modelování témat a analýzu mínění pro vysoce specializované nebo rozsáhlé projekty.

Tyto knihovny nabízejí flexibilitu pro jemné doladění parametrů nebo integraci s rámci strojového učení, takže jsou ideální pro datové vědce nebo výzkumníky, kteří vyžadují plně přizpůsobený proces analýzy textu.

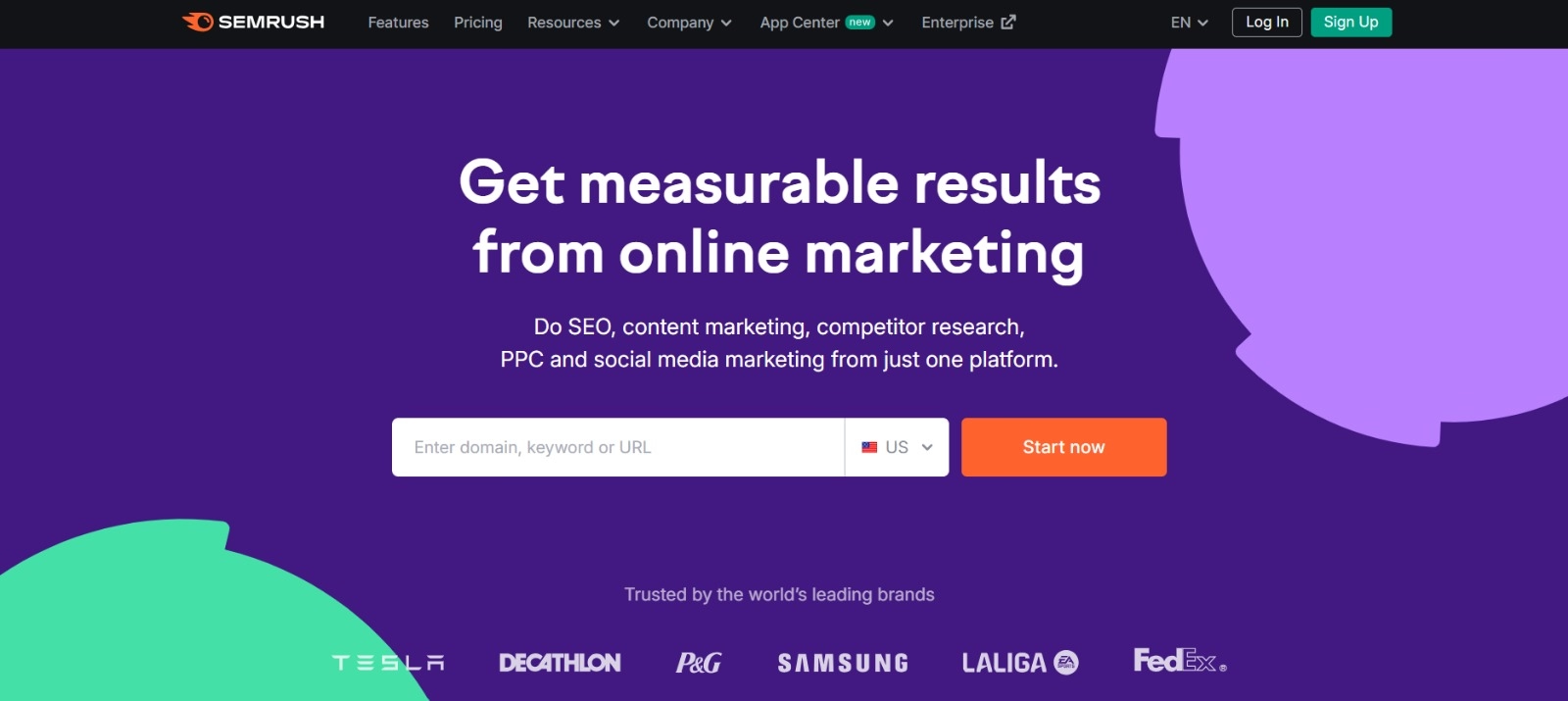

5 Semrush

Semrush je oblíbenou volbou mezi SEO profesionály a kombinuje výzkum klíčových slov s analýzou konkurence. Jeho zaměření na objem vyhledávání, skóre obtížnosti a strategie konkurence pomáhá zdokonalit plány obsahu pro maximální viditelnost.

Kromě návrhů klíčových slov poskytuje Semrush přehledy na úrovni domény, jako jsou profily zpětných odkazů a analýza návštěvnosti, což umožňuje holistický přístup k SEO a taktikám digitálního marketingu.

Podrobný průvodce generováním klíčových slov pomocí Eskritor

Pokud jde o přímočarou, ale výkonnou extrakci klíčových slov, nabízí Eskritor vynikající rovnováhu mezi použitelností a pokročilými funkcemi NLP . Zde je návod, jak co nejlépe využít jeho platformu.

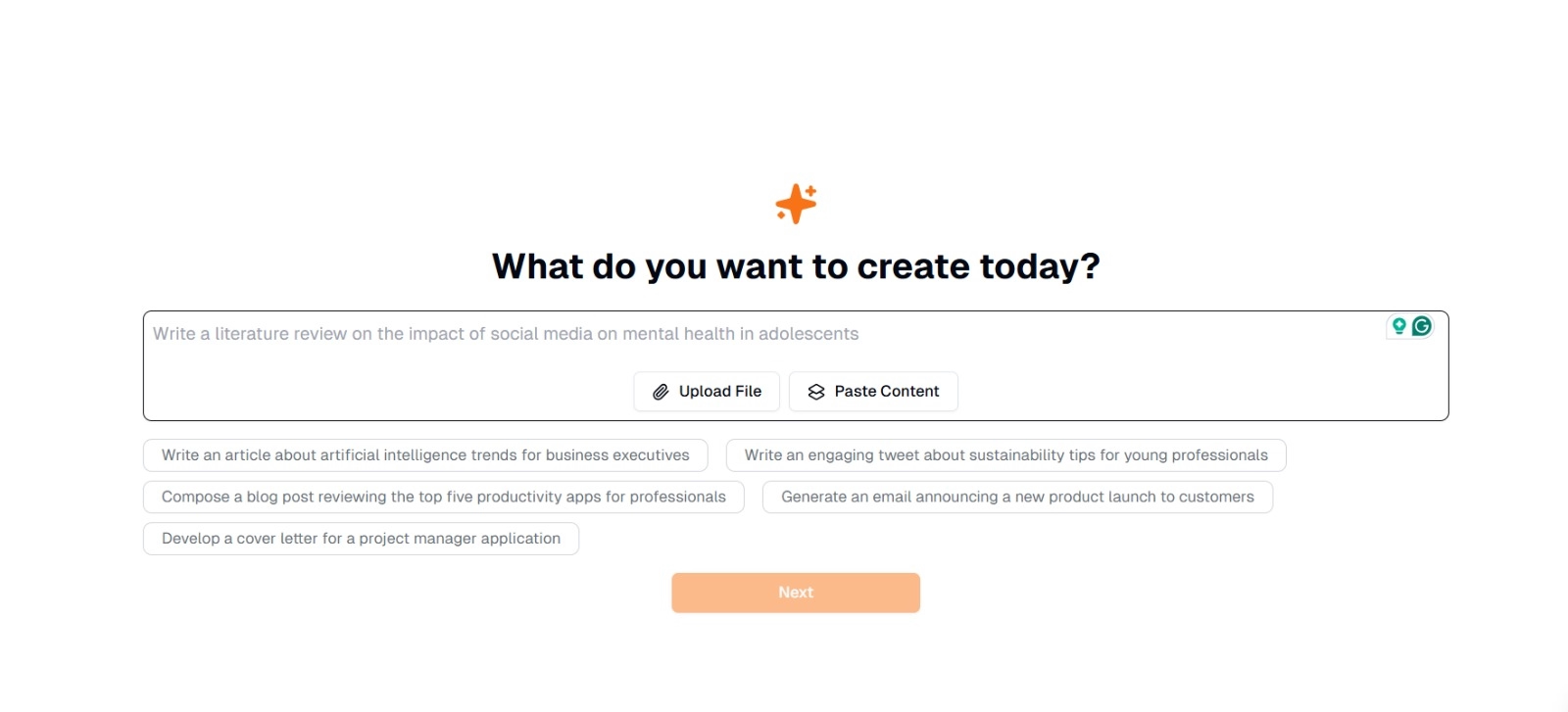

Krok 1: Zadejte nebo nahrajte svůj text

V hlavním rozhraní Eskritorse zobrazí výzva s dotazem: "Co chcete dnes vytvořit?" Zde máte dvě možnosti:

- Vložit obsah : Zkopírujte a vložte text přímo do daného textového pole.

- Nahrát soubor : Vyberte dokument (např. .docx, .pdf, .txt), který obsahuje text, který chcete analyzovat.

Tip : Můžete si také vybrat z navrhovaných výzev (např. "Napište článek o trendech umělé inteligence..."), pokud plánujete vygenerovat nebo přepracovat text před extrakcí.

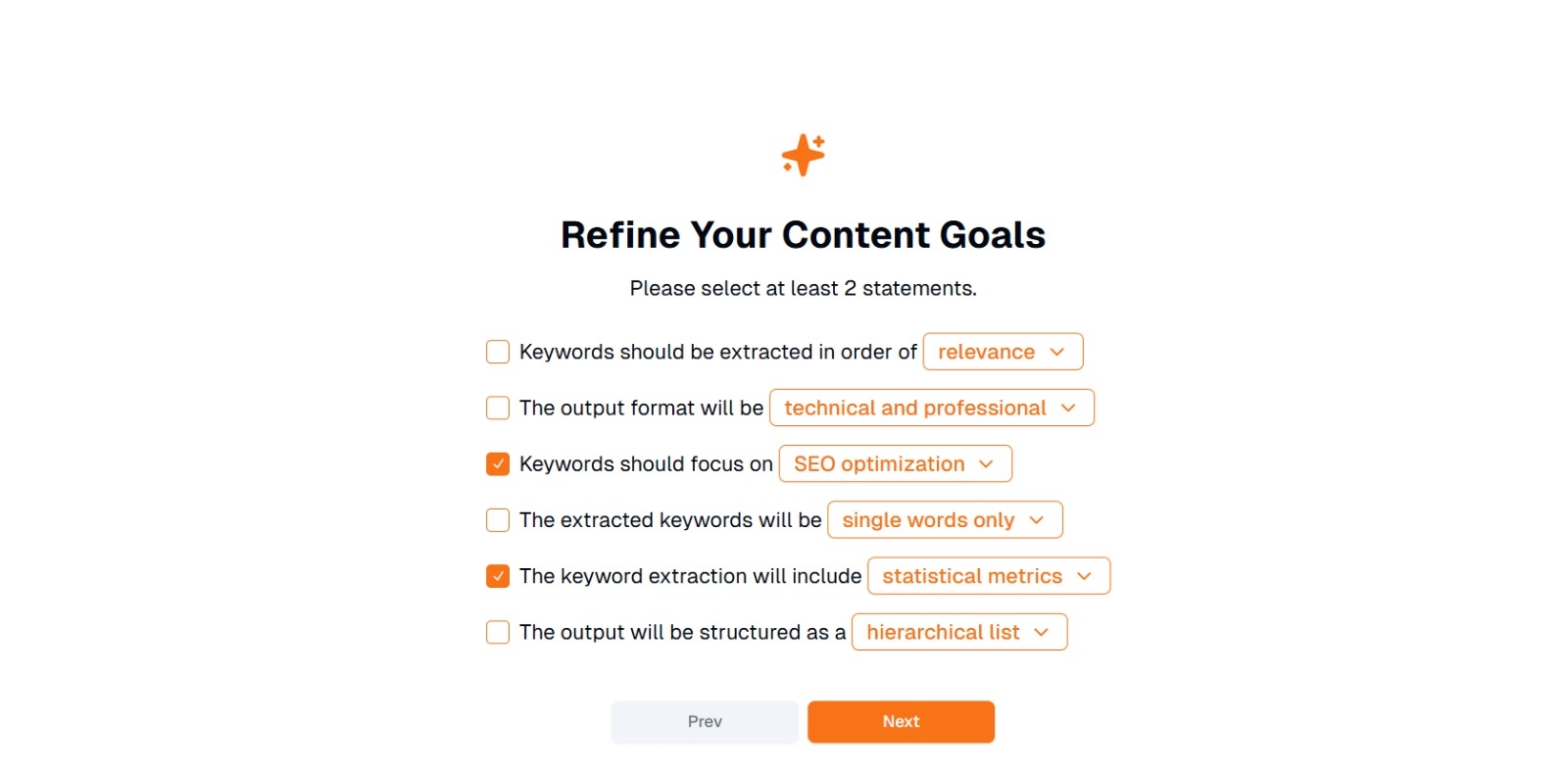

Krok 2: Upřesněte své obsahové cíle

Zobrazí se dotaz " Co chcete s tímto obsahem dělat? " a požádal o výběr alespoň 2 příkazů . Také můžete napsat, co chcete do chatu dělat. Možnosti mohou zahrnovat:

- Klíčová slova by měla být extrahována v pořadí: (např. relevance , frekvence , abeceda atd.)

- Výstupní formát bude: (např. technický a profesionální , neformální a přátelský )

- Klíčová slova by se měla zaměřit na: (např. optimalizaceSEO, akademický výzkum, marketingové úhly pohledu)

- Extrahovaná klíčová slova budou: (např. pouze jednotlivá slova , víceslovné fráze )

- Extrakce klíčových slov bude zahrnovat: (např. statistické metriky , sémantické seskupování )

- Výstup bude strukturován jako: (např. hierarchický seznam , jednoduché odrážky )

Tip : Vyberte příkazy, které nejlépe odpovídají potřebám vašeho projektu. Pokud například optimalizujete příspěvek na blogu pro vyhledávače, zvažte zaškrtnutí SEO optimalizace , pouze jednotlivá slova a extrahované v pořadí podle relevance .

Krok 3: Kliknutím na "Další" vygenerujete klíčová slova

Po upřesnění cílů a provedení požadovaných výběrů spusťte extrakci klíčových slov kliknutím na tlačítko Další (nebo podobné tlačítko). AI Eskritorzpracuje text a použije NLP metody, jako je analýza četnosti termínů, TF-IDFa sémantická analýza (podle potřeby), aby identifikoval nejrelevantnější klíčová slova.

Krok 4: Zkontrolujte extrahovaná klíčová slova

Eskritor zobrazí seznam (nebo hierarchii) klíčových slov na základě vybraných kritérií. Displej může obsahovat:

- Seznam klíčových slov : Uspořádáno podle relevance, frekvence nebo v hierarchickém formátu.

Tip : Hledejte klíčová slova, která mohou vyžadovat sloučení (např. tvary jednotného nebo množného čísla) nebo odstranění (např. příliš obecné výrazy).

Krok 5: Exportujte nebo použijte výsledky

Nakonec seznam klíčových slov exportujte nebo jej zahrňte přímo do pracovního postupu:

- Možnosti exportu : Stáhnout v PDF, docx nebo HTML.

- Případy použití : Integrujte do SEO nástrojů, dokumentů pro plánování obsahu, osnov výzkumu nebo marketingových řídicích panelů.

Tipy pro efektivní generování klíčových slov

Zajistit, aby extrakce klíčových slov byla přesná a v souladu s vašimi cíli, vyžaduje strategii. Zde je několik osvědčených postupů, které je třeba zvážit.

1 Vyčištění a předběžné zpracování textu

Odstraňte stopslova, speciální znaky a irelevantní data před analýzou, abyste se vyhnuli nepořádku. Nástroje jako NLTK (Python) nebo některé textové editory mohou tento krok předběžného zpracování automatizovat.

2 Vyvážení, frekvence a relevance

Klíčové slovo není jen o tom, kolikrát se objeví, ale také o kontextové důležitosti. Kombinujte metriky frekvence se sémantickou analýzou, abyste dosáhli správné rovnováhy.

3 Použijte kombinaci technik

Využijte více přístupů –TF-IDF, sémantickou analýzu nebo rozpoznávání pojmenovaných entit – k zachycení plnějšího rozsahu relevantních klíčových slov a minimalizaci slepých míst.

4 Průběžně testujte a vylepšujte

Trendy klíčových slov se mohou v průběhu času měnit, zejména v rychle se rozvíjejících odvětvích. Klíčová slova pravidelně aktualizujte na základě nových dat, metrik výkonu nebo vyvíjejících se potřeb publika.

Závěr: Zjednodušte generování klíčových slov pomocí AI

Generování účinných klíčových slov je klíčovou součástí moderních obsahových strategií, výzkumných pracovních postupů a úloh analýzy dat. AI a NLPnástroje, jako je Eskritor , zjednodušily extrahování, upřesnění a export klíčových slov s vysokou hodnotou za zlomek času, který by zabralo ručně.

Kombinací několika technik –TF-IDF, sémantické analýzy, modelování témat a dalších – získáte komplexní pochopení toho, co je ve vašem textu skutečně důležité. Tento přehled podporuje lepší výsledky SEO , cílenější výzkum a poutavé marketingové materiály. Stručně řečeno, extrakce klíčových slov na základě AIjiž není volitelná; Je to nutnost pro profesionály, kteří oceňují efektivitu, přesnost a rozhodování založené na datech.

Dubaj, Spojené arabské emiráty

Dubaj, Spojené arabské emiráty