在当今的数字环境中,从文本生成关键字的能力对于 SEO、内容创建和学术研究至关重要。 确定最能代表您的内容的术语和短语可以提高搜索引擎排名、简化研究工作并指导有效的内容策略。 用于关键字提取的自然语言处理的现代进步使这个过程比以往任何时候都更简单、更准确,像 Eskritor 这样的工具是创新的主要例子。

在本指南中,我们将探讨文本分析对关键词生成的重要性,深入研究各种技术——包括关键词的词频分析和使用 TF-IDF 进行关键词提取,并讨论在上下文中生成关键词的语义分析。 我们还将重点介绍从文本生成关键词的最佳工具,并提供关键词生成的分步教程。

为什么要从文本生成关键字?

关键字提取支持各种专业任务——从提高网站排名到对研究文档进行分类。 以下是此过程对现代内容和数据策略至关重要的一些核心原因。

1 优化 SEO 内容

关键字构成了任何有效的 搜索引擎优化 策略的支柱。 通过确定目标受众使用的最相关的术语,您可以优化博客文章、登录页面和其他在线内容,以在搜索结果中排名更高。 这不仅可以增加流量,还可以通过使您的内容与读者意图保持一致来提高用户参与度。

2 提高研究效率

对于学生、研究人员和数据分析师来说,关键字提取可以显著减少筛选大型文档或学术论文所花费的时间。 通过突出显示主要思想和术语,您可以快速对结果进行分类,找到重要的参考文献,甚至跟踪多项研究的趋势。 Google Scholar 等工具进一步帮助发现相关的研究主题和文章。

3 改进内容策略

了解哪些关键词能引起你的受众共鸣——无论是利基行业的长尾关键词还是搜索量高的宽泛词——都有助于你更有效地规划你的内容日历。 这可确保您制作的每一篇文章都直接与您的读者或客户正在搜索的内容相关,最终提高转化率和用户满意度。

4 自动化手动流程

团队必须手动浏览一页又一页的文本来识别重复出现的主题和短语的日子已经一去不复返了。 现代关键字提取工具通过自动化整个过程来节省时间并减少人为错误,让您专注于更高级别的任务,如策略、分析和执行。

5 更快的结果

手动处理大量文本很麻烦。 像 Eskritor 这样的 AI 解决方案可以在短短几分钟内分析数百个页面,使您能够快速迭代并更快地做出数据驱动的决策。

从文本生成关键字的常用技术

不同的技术可以满足各种分析需求,无论您是想要简单的频率计数还是更深入的语义理解。 让我们探索使用最广泛的方法以及它们如何帮助提取有意义的关键词。

1 术语频率分析

术语频率 (TF) 是一种基本方法,用于标识文本中最常用的单词或短语。 虽然这种方法可以显示明显的关键词,但它没有考虑这些词在多个文档中的唯一性或特异性。

2 TF-IDF (词频 – 逆向文档频率)

TF-IDF 通过考虑术语在一组文档中的重要性来优化基本术语频率分析。 在一个文档中经常出现但很少出现在其他文档中的单词会获得更高的分数,这使得这种技术非常适合用于精确定位更专业或特定于上下文的关键字。

3 语义分析

语义分析通过检查单词之间的关系来识别上下文相关的短语,而不仅仅是经常使用的短语。 如果要捕获同义词、相关术语或主题关联的概念,而不是可能没有意义的重复单词,这将特别有用。

4 基于 NLP的方法

命名实体识别 (NER) 和主题建模等高级 NLP 技术超越了简单的字数统计。 NER 识别人员、地点、组织和其他特定实体,这些实体可能是新闻或商业分析中的关键关键字。 主题建模揭示了文本中更广泛的主题,从而更容易对大量数据进行分类。

从文本生成关键字的最佳工具

可以使用一系列专用工具和平台完成关键字提取。 以下是一些领先的选项,每个选项都适合不同的用户需求 - 从 SEO 优化到全面的数据分析。

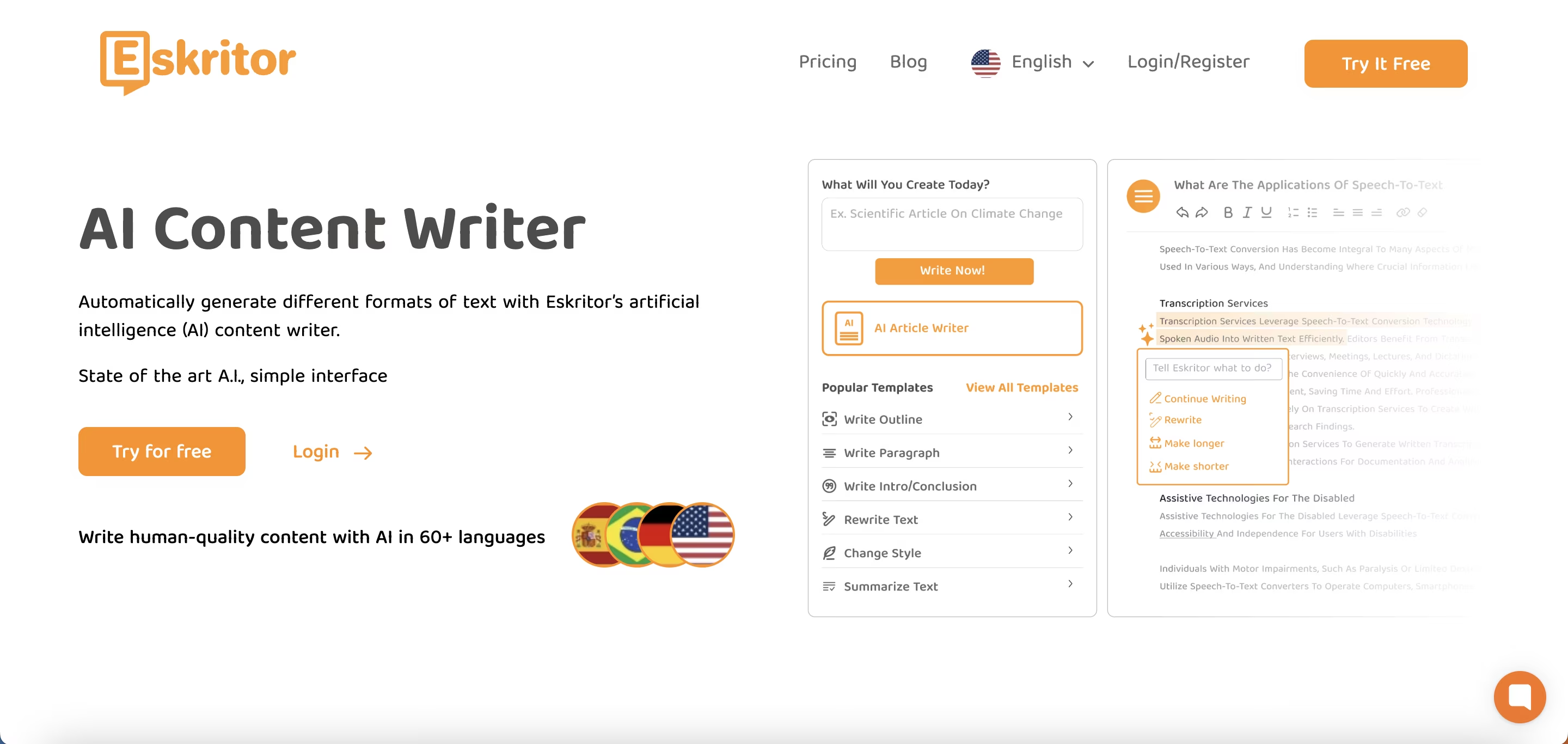

1 Eskritor

Eskritor 是一个先进的、 AI驱动的写作平台,旨在为各个领域的用户简化和增强关键字提取过程——无论您是针对 SEO进行优化、开展营销活动还是进行学术研究。 通过利用强大的自然语言处理 (NLP) 算法, Eskritor 自动识别文本中的关键术语和短语,突出显示基于频率的关键字和上下文驱动的见解。

主要特点

- AI为 SEO、营销和学术用途量身定制的写作工具

- 用于分析文本和生成可作关键字的简单界面

为什么它脱颖而出

- 使用高级 NLP 算法加快关键词分析

- 为频率过滤和语义分析提供可定制的选项

2 Google Keyword Planner

Google Keyword Planner 是数字营销人员的主打产品,可将建议的关键词与搜索量数据保持一致。 虽然它主要用于 PPC 活动,但它也可以帮助内容创建者根据真实用户的查询来优化他们的主题。 与 Google Ads 的集成提供了对特定词语搜索频率的直接洞察,让您在制作符合用户意图的内容方面抢占先机。

3 MonkeyLearn

MonkeyLearn 是使用强大的 NLP API 提供关键字提取,是文本分析的理想选择。 它擅长对反馈、评论或社交媒体聊天进行分类,对于专注于情绪和趋势分析的品牌来说很有价值。 MonkeyLearn的仪表板包括实时处理选项,这意味着您可以将其设置为持续分析传入数据,非常适合快节奏的营销团队或客户支持运营。

4 R 和 Python 库

对于熟悉编程的用户,Tidytext (R) 和 spaCy (Python) 等库支持深入、可自定义的关键字提取。 您可以为高度专业化或大型项目实施 TF-IDF、 主题建模 和 情绪分析。

这些库提供了微调参数或与机器学习框架集成的灵活性,使其成为需要完全定制文本分析管道的数据科学家或研究人员的理想选择。

5 Semrush

Semrush 是SEO专业人士的热门选择,它将关键词研究与竞争分析相结合。 它对搜索量、难度分数和竞争对手策略的关注有助于改进内容计划以获得最大的知名度。

除了关键词建议之外, Semrush 还提供域级洞察,例如外链配置文件和流量分析,从而为 SEO 和数字营销策略提供整体方法。

使用 Eskritor 生成关键字的分步指南

当涉及到简单而强大的关键字提取时, Eskritor 在可用性和高级 NLP 功能之间提供了极好的平衡。 以下是如何充分利用其平台。

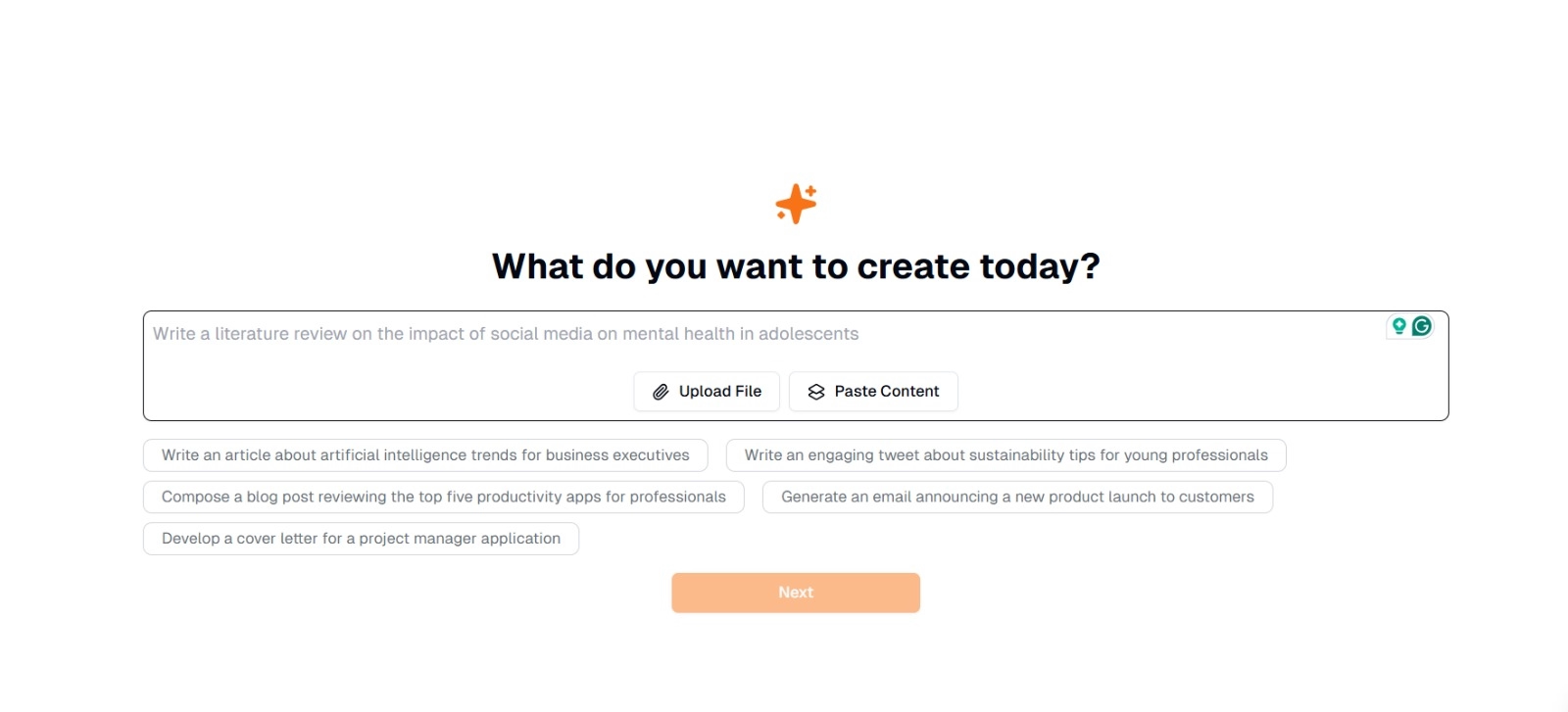

第 1 步:输入或上传您的文本

在 Eskritor的主界面上,您会看到一个提示, 询问“您今天想创建什么? 在这里,您有两个选项:

- 粘贴内容 :将文本直接复制并粘贴到给定的文本框中。

- 上传文件 :选择包含要分析的文本的文档(例如,.docx、.pdf .txt)。

提示 :如果您计划在提取之前生成或返工文本,您还可以从建议的提示中进行选择(例如,“Write an article about artificial intelligence trends...”)。

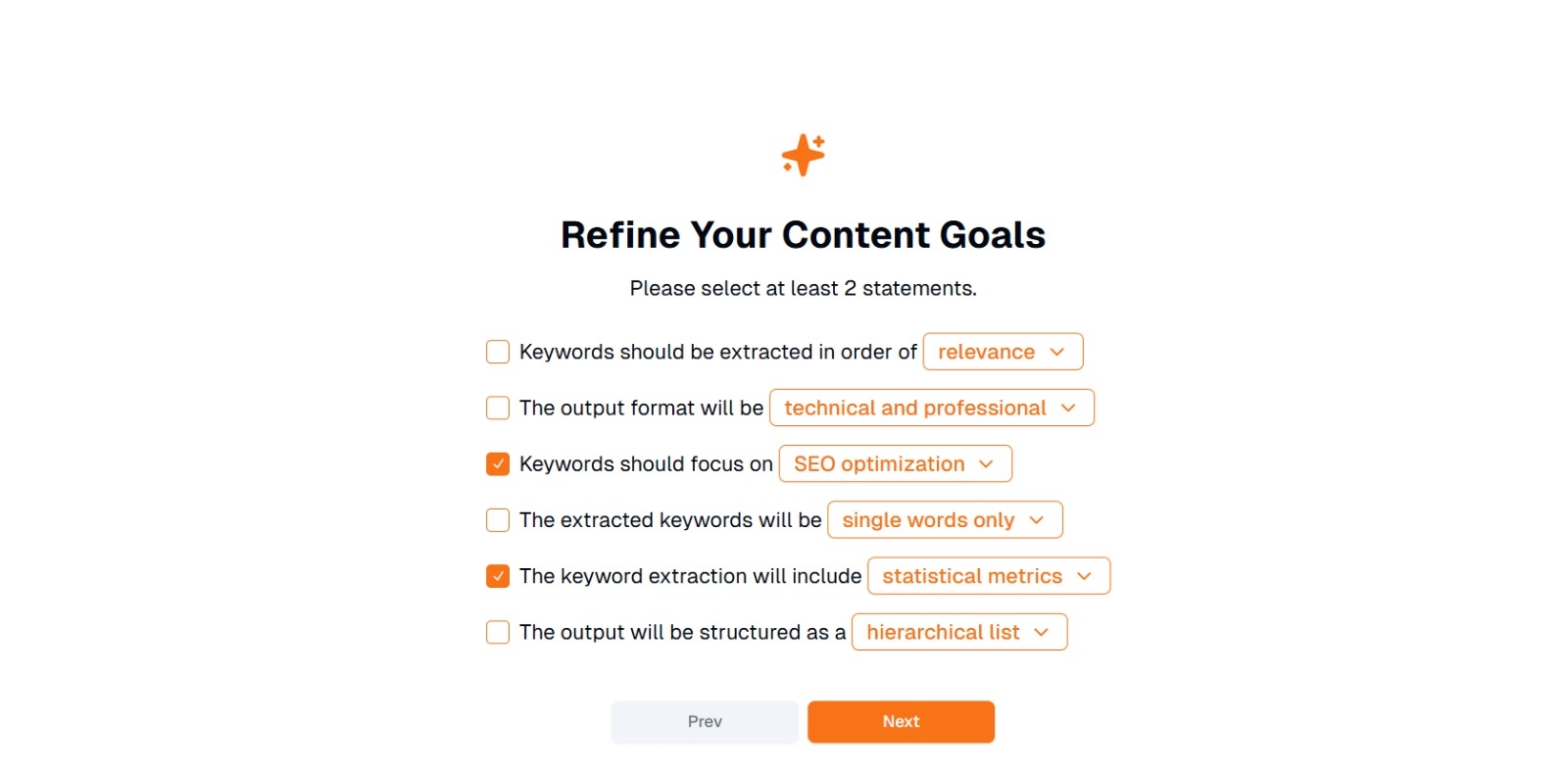

第 2 步:优化您的内容目标

系统将提示 你“ 你想用这些内容做什么? “ ,并要求 选择至少 2 个语句 。 此外,您可以写下您想聊天的内容。 选项可能包括:

- 关键字应按以下顺序提取: (例如, relevance 、 frequency 、 alphabetical 等)

- 输出格式为: (例如, technical and professional,casual and friendly )

- 关键词应关注: (例如, SEO优化 、 学术研究 、 营销角度 )

- 提取的关键字将是: (例如, 仅单个单词 、 多单词短语 )

- 关键字提取将包括: (例如, 统计指标 、 语义分组 )

- 输出的结构为: (例如, 分层列表 、 简单要点 )

提示 :选择最符合您项目需求的语句。 例如,如果您正在为搜索引擎优化博客文章,请考虑检查 SEO optimization , single words only 和 extract in order of relevance 。

第 3 步:点击“下一步”生成关键字

优化目标并做出所需选择后,单击 下一步 (或类似按钮) 开始关键字提取。 Eskritor的 AI 将处理文本,应用 NLP 方法(如术语频率分析、 TF-IDF和语义分析(如果适用))来识别最相关的关键字。

第 4 步:查看提取的关键字

Eskritor 将根据您选择的条件显示关键字列表(或层次结构)。 显示屏可能包括:

- 关键字列表 :按相关性、频率或分层格式排列。

提示 : 注意可能需要合并(例如,单数与复数形式)或删除(例如,过于笼统的术语)的关键字。

第 5 步:导出或应用结果

最后,导出关键字列表或将其直接合并到您的工作流程中:

- 导出选项 :以 PDF、 docx 或 HTML格式下载 。

- 用例 :集成到 SEO 工具、内容规划文档、研究大纲或营销仪表板中。

有效生成关键词的技巧

确保您的关键字提取既准确又与您的目标保持一致需要策略。 以下是一些需要考虑的最佳实践。

1 清理和预处理文本

在分析之前删除停用词、特殊字符和不相关的数据,以避免混乱。 NLTK (Python) 等工具或某些文本编辑器可以自动执行此预处理步骤。

2 平衡频率和相关性

关键词不仅与它出现的次数有关,还与上下文重要性有关。 将频率指标与语义分析相结合,以取得适当的平衡。

3 混合使用技术

利用多种方法(TF-IDF、语义分析或命名实体识别)来捕获更全面的相关关键字并最大限度地减少盲点。

4 持续测试和改进

关键词趋势会随着时间的推移而变化,尤其是在快速发展的行业中。 根据新数据、效果指标或不断变化的受众需求定期更新您的关键词。

结论:使用 AI 简化关键字生成

生成有效的关键词是现代内容策略、研究工作流程和数据分析任务的关键部分。 AI 和 NLP驱动的工具(如 Eskritor )使提取、优化和导出高价值关键词变得比以往任何时候都更简单,而所需时间仅为手动关键词的一小部分。

通过结合多种技术(TF-IDF、语义分析、主题建模等),您可以全面了解文本中真正重要的内容。 这种洞察力有助于获得更好的 SEO 结果、更有针对性的研究和引人入胜的营销材料。 简而言之,基于 AI的关键字提取不再是可选的;对于重视效率、精度和数据驱动决策的专业人士来说,这是必不可少的。

迪拜, 阿联酋

迪拜, 阿联酋