ในภูมิทัศน์ดิจิทัลในปัจจุบันความสามารถในการสร้างคําหลักจากข้อความเป็นสิ่งจําเป็นสําหรับการ SEOการสร้างเนื้อหาและการวิจัยทางวิชาการ การระบุคําศัพท์และวลีที่แสดงถึงเนื้อหาของคุณได้ดีที่สุดสามารถปรับปรุงการจัดอันดับของเครื่องมือค้นหา ปรับปรุงความพยายามในการวิจัย และเป็นแนวทางในกลยุทธ์เนื้อหาที่มีประสิทธิภาพ ความก้าวหน้าสมัยใหม่ในการประมวลผลภาษาธรรมชาติสําหรับการแยกคําหลักทําให้กระบวนการนี้ง่ายขึ้นและแม่นยํากว่าที่เคย ด้วยเครื่องมืออย่าง Eskritor ที่โดดเด่นในฐานะตัวอย่างที่สําคัญของนวัตกรรม

ในคู่มือนี้ เราจะสํารวจความสําคัญของการวิเคราะห์ข้อความสําหรับการสร้างคําหลัก เจาะลึกเทคนิคต่างๆ รวมถึงการวิเคราะห์ความถี่ของคําสําหรับคําหลักและการใช้ TF-IDF สําหรับการแยกคําหลัก และหารือเกี่ยวกับการวิเคราะห์ความหมายสําหรับการสร้างคําหลักในบริบท นอกจากนี้เรายังจะเน้นเครื่องมือที่ดีที่สุดสําหรับการสร้างคําหลักจากข้อความและให้บทช่วยสอนทีละขั้นตอนสําหรับการสร้างคําหลัก

เหตุใดจึงต้องสร้างคําหลักจากข้อความ

การแยกคําหลักเป็นรากฐานของงานระดับมืออาชีพที่หลากหลาย ตั้งแต่การปรับปรุงการจัดอันดับเว็บไซต์ไปจนถึงการจัดหมวดหมู่เอกสารการวิจัย ด้านล่างนี้คือเหตุผลหลักบางประการว่าทําไมกระบวนการนี้จึงมีความสําคัญต่อเนื้อหาและกลยุทธ์ข้อมูลที่ทันสมัย

1 เพิ่มประสิทธิภาพเนื้อหาสําหรับ SEO

คําหลักเป็นกระดูกสันหลังของกลยุทธ์ การเพิ่มประสิทธิภาพกลไกค้นหา ที่มีประสิทธิภาพ ด้วยการระบุคําศัพท์ที่เกี่ยวข้องมากที่สุดที่กลุ่มเป้าหมายของคุณใช้ คุณสามารถเพิ่มประสิทธิภาพโพสต์บล็อก หน้า Landing Page และเนื้อหาออนไลน์อื่นๆ เพื่อให้อยู่ในอันดับที่สูงขึ้นในผลการค้นหา สิ่งนี้ไม่เพียงแต่เพิ่มการเข้าชม แต่ยังเพิ่มการมีส่วนร่วมของผู้ใช้โดยการปรับเนื้อหาของคุณให้สอดคล้องกับความตั้งใจของผู้อ่าน

2 เพิ่มประสิทธิภาพการวิจัย

สําหรับนักเรียน นักวิจัย และนักวิเคราะห์ข้อมูล การดึงคําหลักสามารถลดเวลาที่ใช้ในการกลั่นกรองเอกสารขนาดใหญ่หรือเอกสารทางวิชาการได้อย่างมาก ด้วยการเน้นแนวคิดหลักและคําศัพท์คุณสามารถจัดหมวดหมู่สิ่งที่ค้นพบค้นหาข้อมูลอ้างอิงที่สําคัญและแม้กระทั่งติดตามแนวโน้มในการศึกษาหลายชิ้นได้อย่างรวดเร็ว เครื่องมือเช่น Google Scholar ช่วยเพิ่มเติมในการค้นหาหัวข้อการวิจัยและบทความที่เกี่ยวข้อง

3 ปรับปรุงกลยุทธ์เนื้อหา

การทําความเข้าใจว่าคําหลักใดที่โดนใจผู้ชมของคุณ ไม่ว่าจะเป็นคําหลักหางยาวสําหรับอุตสาหกรรมเฉพาะกลุ่มหรือคํากว้างๆ ที่มีปริมาณการค้นหาสูง จะช่วยให้คุณวางแผนปฏิทินเนื้อหาได้อย่างมีประสิทธิภาพมากขึ้น สิ่งนี้ทําให้มั่นใจได้ว่าแต่ละชิ้นที่คุณผลิตจะพูดโดยตรงกับสิ่งที่ผู้อ่านหรือลูกค้าของคุณกําลังค้นหา ซึ่งจะช่วยเพิ่ม Conversion และความพึงพอใจของผู้ใช้ในที่สุด

4 ทําให้กระบวนการด้วยตนเองเป็นแบบอัตโนมัติ

หมดยุคที่ทีมต้องอ่านผ่านหน้าและหน้าข้อความด้วยตนเองเพื่อระบุธีมและวลีที่เกิดซ้ํา เครื่องมือแยกคําหลักที่ทันสมัยช่วยประหยัดเวลาและลดข้อผิดพลาดของมนุษย์โดยทําให้กระบวนการทั้งหมดเป็นไปโดยอัตโนมัติ ช่วยให้คุณมุ่งเน้นไปที่งานระดับสูง เช่น กลยุทธ์ การวิเคราะห์ และการดําเนินการ

5 ผลลัพธ์ที่เร็วขึ้น

การประมวลผลข้อความจํานวนมากด้วยตนเองนั้นยุ่งยาก โซลูชัน AI อย่าง Eskritor สามารถวิเคราะห์หน้าหลายร้อยหน้าได้ในเวลาเพียงไม่กี่นาที

เทคนิคทั่วไปในการสร้างคําหลักจากข้อความ

เทคนิคต่างๆ ตอบสนองความต้องการในการวิเคราะห์ที่หลากหลาย ไม่ว่าคุณจะต้องการการนับความถี่อย่างง่ายหรือความเข้าใจเชิงความหมายที่ลึกซึ้งยิ่งขึ้น มาสํารวจวิธีการที่ใช้กันอย่างแพร่หลายมากที่สุดและวิธีที่ช่วยดึงคําหลักที่มีความหมาย

1 การวิเคราะห์ความถี่ของคําศัพท์

วิธีการพื้นฐาน Term Frequency (TF) ระบุคําหรือวลีที่ใช้บ่อยที่สุดภายในข้อความ แม้ว่าวิธีนี้จะแสดงคําหลักที่ชัดเจน แต่ก็ไม่ได้คํานึงถึงความเป็นเอกลักษณ์หรือความจําเพาะของคําเหล่านั้นในเอกสารหลายฉบับ

2 TF-IDF (ความถี่ของคําศัพท์ – ความถี่ของเอกสารผกผัน)

TF-IDF ปรับแต่งการวิเคราะห์ความถี่ของคําศัพท์พื้นฐานโดยคํานึงถึงความสําคัญของคําศัพท์ในชุดเอกสาร คําที่ปรากฏบ่อยในเอกสารหนึ่ง แต่ไม่ค่อยมีในเอกสารอื่น ๆ จะได้รับคะแนนสูงกว่า ทําให้เทคนิคนี้ยอดเยี่ยมสําหรับการระบุคําหลักที่เฉพาะเจาะจงหรือเฉพาะบริบท

3 การวิเคราะห์ความหมาย

การวิเคราะห์ความหมายระบุวลีที่เกี่ยวข้องตามบริบทโดยการตรวจสอบความสัมพันธ์ระหว่างคํามากกว่าแค่คําที่ใช้บ่อย สิ่งนี้มีประโยชน์อย่างยิ่งหากคุณต้องการจับคําพ้องความหมาย คําศัพท์ที่เกี่ยวข้อง หรือแนวคิดที่เชื่อมโยงตามธีม แทนที่จะเป็นคําซ้ําๆ ที่อาจไม่มีความสําคัญ

4 แนวทางที่ใช้ NLP

เทคนิคการ NLP ขั้นสูง เช่น การรู้จําเอนทิตีที่มีชื่อ (NER) และการสร้างแบบจําลองหัวข้อเป็นมากกว่าการนับคําง่ายๆ NER ระบุบุคคล สถานที่ องค์กร และหน่วยงานเฉพาะอื่นๆ ซึ่งอาจเป็นคําสําคัญในวารสารศาสตร์หรือการวิเคราะห์ธุรกิจ การสร้างแบบจําลองหัวข้อเผยให้เห็นธีมที่กว้างขึ้นภายในข้อความ ทําให้ง่ายต่อการจัดหมวดหมู่ข้อมูลจํานวนมาก

เครื่องมือที่ดีที่สุดสําหรับการสร้างคําหลักจากข้อความ

การแยกคําหลักสามารถทําได้โดยใช้เครื่องมือและแพลตฟอร์มพิเศษที่หลากหลาย ด้านล่างนี้คือตัวเลือกชั้นนํา ซึ่งแต่ละตัวเลือกเหมาะกับความต้องการของผู้ใช้ที่แตกต่างกัน ตั้งแต่การเพิ่มประสิทธิภาพ SEO ไปจนถึงการวิเคราะห์ข้อมูลที่ครอบคลุม

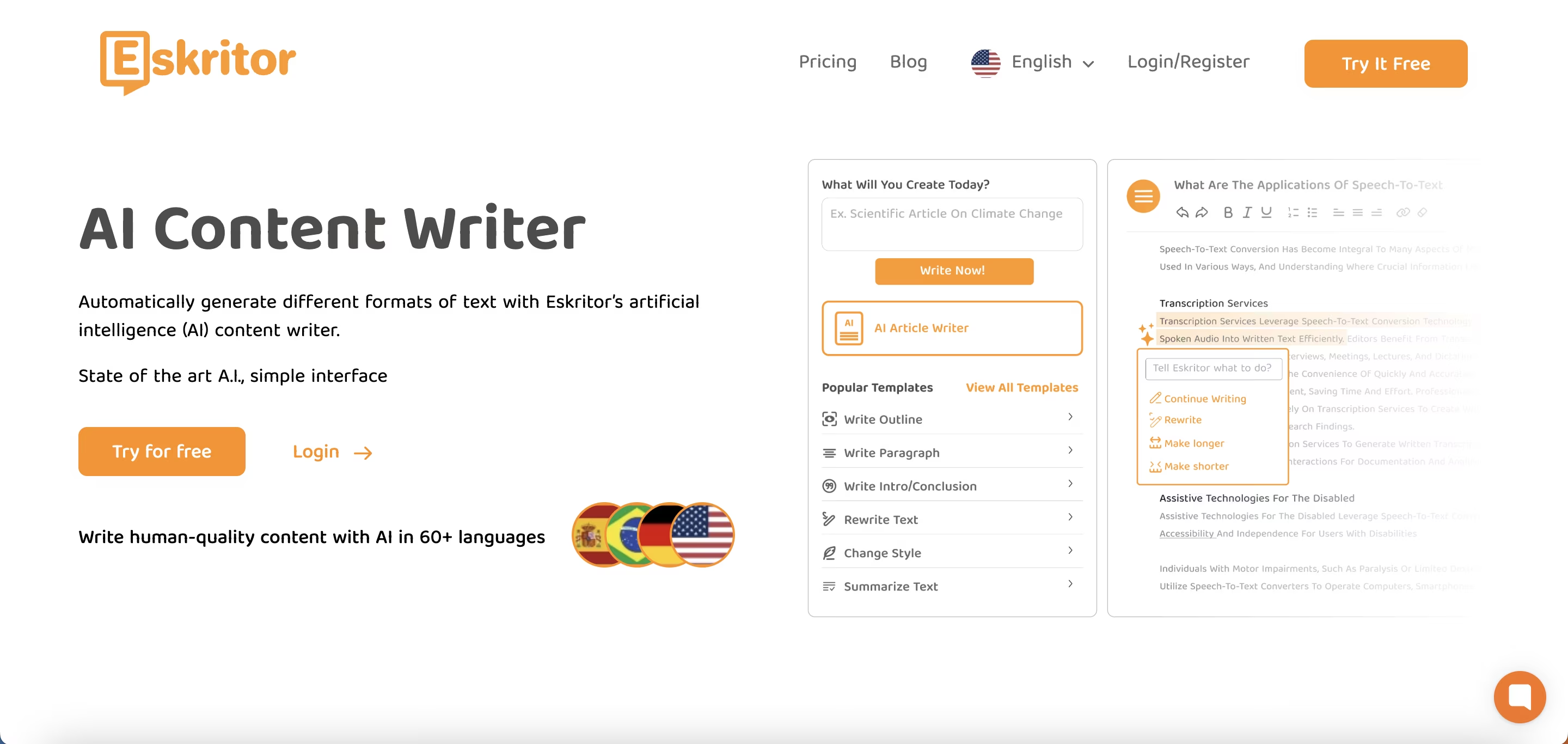

1 Eskritor

Eskritor เป็นแพลตฟอร์มการเขียนขั้นสูงที่ขับเคลื่อนด้วย AIซึ่งออกแบบมาเพื่อลดความซับซ้อนและปรับปรุงกระบวนการแยกคําหลักสําหรับผู้ใช้ในสาขาต่างๆ ไม่ว่าคุณจะเพิ่มประสิทธิภาพสําหรับ SEOพัฒนาแคมเปญการตลาด หรือทําการวิจัยทางวิชาการ ด้วยการควบคุมอัลกอริธึมการประมวลผลภาษาธรรมชาติ (NLP) ที่ทรงพลัง Eskritor จะระบุคําศัพท์และวลีสําคัญในข้อความของคุณโดยอัตโนมัติ โดยเน้นทั้งคําหลักตามความถี่และข้อมูลเชิงลึกที่ขับเคลื่อนด้วยบริบท

ฟีเจอร์หลัก

- เครื่องมือเขียนที่ขับเคลื่อนด้วยAIที่ปรับให้เหมาะกับการใช้งานด้านSEOการตลาดและวิชาการ

- อินเทอร์เฟซที่เรียบง่ายสําหรับการวิเคราะห์ข้อความและสร้างคําหลักที่นําไปใช้ได้จริง

ทําไมมันถึงโดดเด่น

- เพิ่มความเร็วในการวิเคราะห์คําหลักด้วยอัลกอริธึม NLP ขั้นสูง

- เสนอตัวเลือกที่ปรับแต่งได้สําหรับการกรองความถี่และการวิเคราะห์ความหมาย

2 Google Keyword Planner

วัตถุดิบหลักสําหรับนักการตลาดดิจิทัล Google Keyword Planner จัดคําหลักที่แนะนําให้สอดคล้องกับข้อมูลปริมาณการค้นหา แม้ว่าจะมีไว้สําหรับแคมเปญ PPC เป็นหลัก แต่ก็ช่วยให้ผู้สร้างเนื้อหาปรับแต่งหัวข้อของตนตามคําถามของผู้ใช้จริง การผสานรวมกับ Google Ads ให้ข้อมูลเชิงลึกโดยตรงเกี่ยวกับความถี่ในการค้นหาคําศัพท์เฉพาะ ช่วยให้คุณเริ่มต้นสร้างเนื้อหาที่ตรงกับความตั้งใจของผู้ใช้

3 MonkeyLearn

เหมาะอย่างยิ่งสําหรับการวิเคราะห์ข้อความ MonkeyLearn ให้การแยกคําหลักโดยใช้ NLP API ที่มีประสิทธิภาพ มีความเชี่ยวชาญในการจัดหมวดหมู่ข้อเสนอแนะ บทวิจารณ์ หรือการพูดคุยบนโซเชียลมีเดีย ทําให้มีค่าสําหรับแบรนด์ที่เน้นการวิเคราะห์ความรู้สึกและแนวโน้ม แดชบอร์ดของ MonkeyLearnมีตัวเลือกสําหรับการประมวลผลแบบเรียลไทม์ ซึ่งหมายความว่าคุณสามารถตั้งค่าให้วิเคราะห์ข้อมูลที่เข้ามาได้อย่างต่อเนื่อง ซึ่งเหมาะสําหรับทีมการตลาดที่รวดเร็วหรือการดําเนินการสนับสนุนลูกค้า

4 ไลบรารี R และ Python

สําหรับผู้ใช้ที่คุ้นเคยกับการเขียนโปรแกรมไลบรารีเช่น Tidytext (R) และ spaCy (Python) ช่วยให้สามารถแยกคําหลักในเชิงลึกที่ปรับแต่งได้ คุณสามารถใช้ TF-IDFการสร้างแบบจําลองหัวข้อ และการวิเคราะห์ความคิดเห็นสําหรับโครงการที่มีความเชี่ยวชาญสูงหรือขนาดใหญ่

ไลบรารีเหล่านี้มีความยืดหยุ่นในการปรับแต่งพารามิเตอร์อย่างละเอียดหรือผสานรวมกับเฟรมเวิร์กการเรียนรู้ของเครื่อง ทําให้เหมาะสําหรับนักวิทยาศาสตร์ข้อมูลหรือนักวิจัยที่ต้องการไปป์ไลน์การวิเคราะห์ข้อความที่ปรับแต่งอย่างเต็มที่

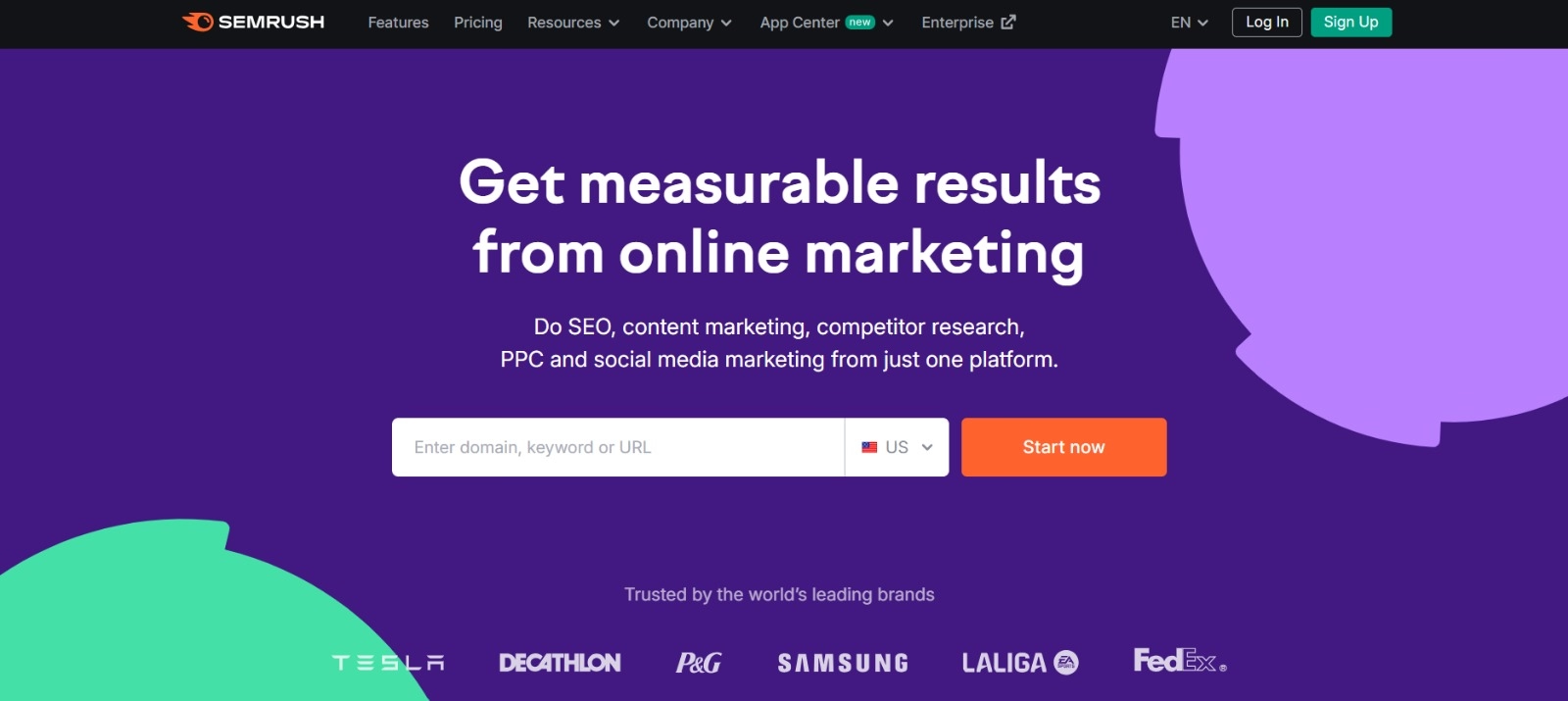

5 Semrush

ตัวเลือกยอดนิยมในหมู่มืออาชีพ SEO Semrush ผสมผสานการวิจัยคําหลักเข้ากับการวิเคราะห์การแข่งขัน การมุ่งเน้นไปที่ปริมาณการค้นหา คะแนนความยาก และกลยุทธ์ของคู่แข่งช่วยปรับแต่งแผนเนื้อหาเพื่อการมองเห็นสูงสุด

นอกเหนือจากคําแนะนําคําหลักแล้ว Semrush ยังให้ข้อมูลเชิงลึกระดับโดเมน เช่น โปรไฟล์ลิงก์ย้อนกลับและการวิเคราะห์การเข้าชม ซึ่งช่วยให้มีแนวทางแบบองค์รวมในการ SEO และกลยุทธ์การตลาดดิจิทัล

คําแนะนําทีละขั้นตอนในการสร้างคําหลักด้วย Eskritor

เมื่อพูดถึงการแยกคําหลักที่ตรงไปตรงมาแต่ทรงพลัง Eskritor นําเสนอความสมดุลที่ยอดเยี่ยมระหว่างการใช้งานและคุณสมบัติ NLP ขั้นสูง นี่คือวิธีใช้ประโยชน์สูงสุดจากแพลตฟอร์ม

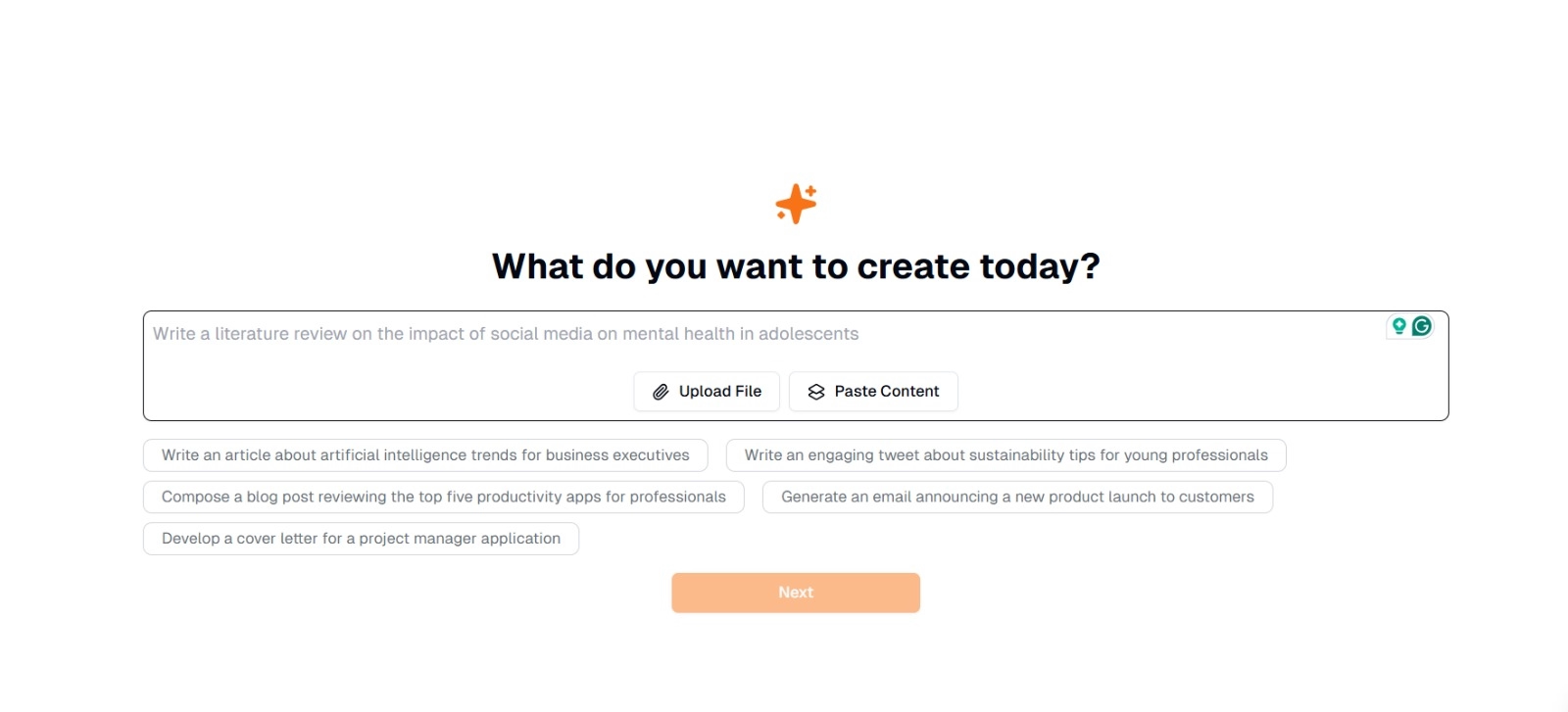

ขั้นตอนที่ 1: ป้อนหรืออัปโหลดข้อความของคุณ

บนอินเทอร์เฟซหลักของ Eskritorคุณจะเห็นข้อความแจ้งที่ถามว่า "วันนี้คุณต้องการสร้างอะไร" ที่นี่ คุณมีสองตัวเลือก:

- วางเนื้อหา : คัดลอกและวางข้อความของคุณลงในกล่องข้อความที่กําหนดโดยตรง

- อัปโหลดไฟล์ : เลือกเอกสาร (เช่น .docx, .pdf, .txt) ที่มีข้อความที่คุณต้องการวิเคราะห์

เคล็ดลับ : คุณยังสามารถเลือกจากข้อความแจ้งที่แนะนํา (เช่น "เขียนบทความเกี่ยวกับแนวโน้มปัญญาประดิษฐ์...) หากคุณวางแผนที่จะสร้างหรือทําข้อความใหม่ก่อนการแยก

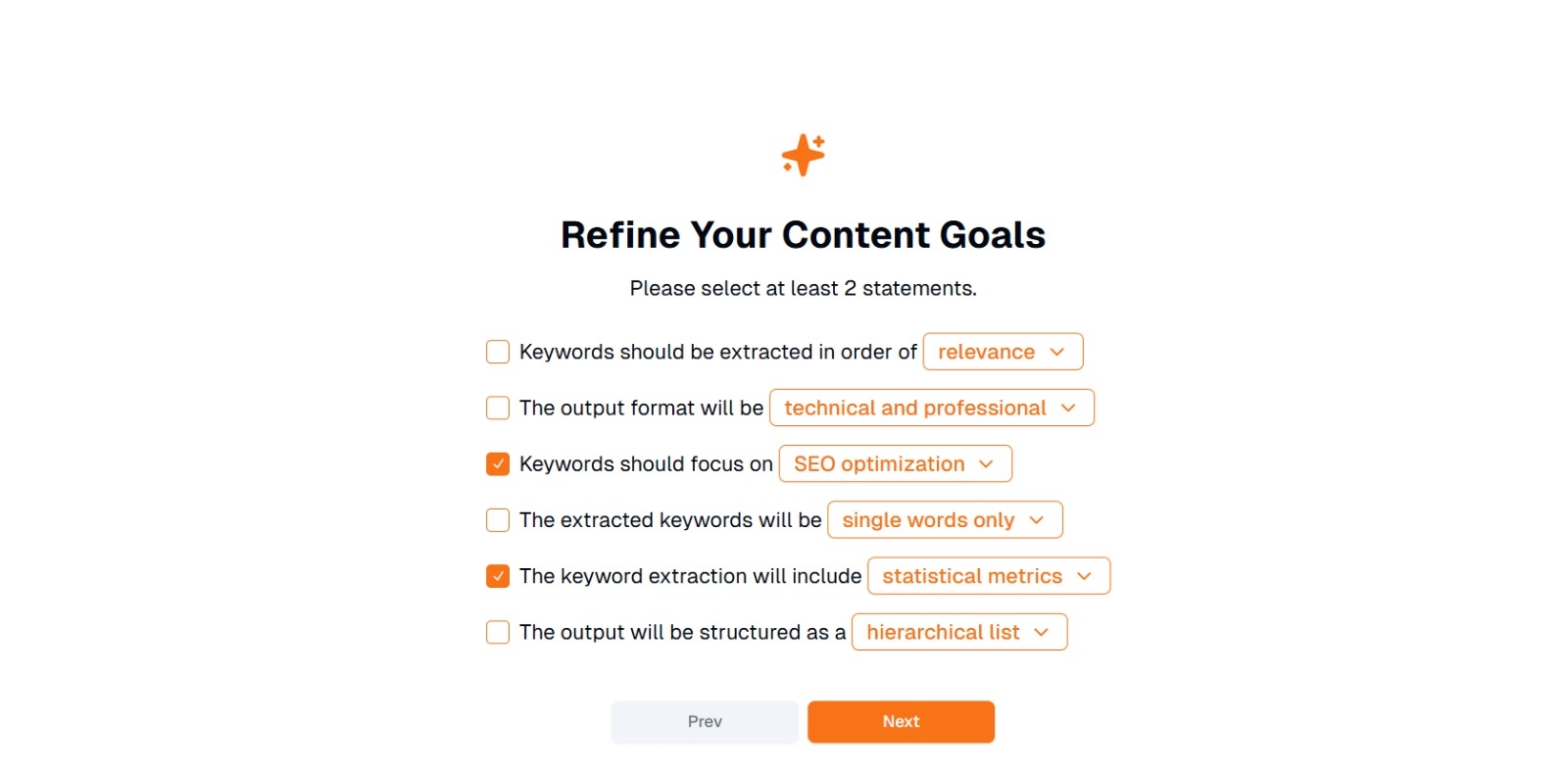

ขั้นตอนที่ 2: ปรับแต่งเป้าหมายเนื้อหาของคุณ

คุณจะได้รับแจ้งว่า "คุณต้องการทําอะไรกับเนื้อหานี้" และขอให้เลือกอย่างน้อย 2 ข้อความ นอกจากนี้คุณยังสามารถเขียนสิ่งที่คุณต้องการทําเพื่อแชท ตัวเลือกอาจรวมถึง:

- ควรแยกคําหลักตามลําดับ: (เช่น ความเกี่ยวข้อง ความถี่ ตามตัวอักษร ฯลฯ)

- รูปแบบผลลัพธ์จะเป็น: (เช่น เทคนิคและมืออาชีพ ไม่ เป็นทางการและเป็นมิตร )

- คําหลักควรมุ่งเน้นไปที่: (เช่น การ เพิ่มประสิทธิภาพSEO การวิจัยทางวิชาการ มุมมองทางการตลาด )

- คําหลักที่แยกออกมาจะเป็น: (เช่น คํา เดียวเท่านั้น , วลีหลายคํา )

- การแยกคําหลักจะรวมถึง: (เช่น เมตริกทางสถิติ การจัด กลุ่มความหมาย )

- ผลลัพธ์จะมีโครงสร้างเป็น: (เช่น รายการลําดับชั้น , สัญลักษณ์แสดงหัวข้อย่อยอย่างง่าย )

เคล็ดลับ : เลือกข้อความที่ตรงกับความต้องการของโครงการของคุณมากที่สุด ตัวอย่างเช่น หากคุณกําลังเพิ่มประสิทธิภาพบล็อกโพสต์สําหรับเครื่องมือค้นหา ให้พิจารณาตรวจสอบ การเพิ่มประสิทธิภาพSEO คําเดียวเท่านั้น และแยกออกมาตามลําดับความเกี่ยวข้อง

ขั้นตอนที่ 3: คลิก "ถัดไป" เพื่อสร้างคําหลัก

หลังจากปรับแต่งเป้าหมายและทําการเลือกที่ต้องการแล้ว ให้คลิกถัดไป (หรือปุ่มที่คล้ายกัน) เพื่อเริ่มการแยกคีย์เวิร์ด AIของ Eskritorจะประมวลผลข้อความ โดยใช้วิธีการNLP เช่น การวิเคราะห์ความถี่ของคําศัพท์ TF-IDFและการวิเคราะห์ความหมาย (ตามความเหมาะสม) เพื่อระบุคําหลักที่เกี่ยวข้องมากที่สุด

ขั้นตอนที่ 4: ตรวจสอบคําหลักที่แยกออกมา

Eskritor จะแสดงรายการ (หรือลําดับชั้น) ของคําหลักตามเกณฑ์ที่คุณเลือก จอแสดงผลอาจรวมถึง:

- รายการคําหลัก : จัดเรียงตามความเกี่ยวข้อง ความถี่ หรือในรูปแบบลําดับชั้น

เคล็ดลับ : มองหาคําหลักที่อาจต้องรวม (เช่น รูปแบบเอกพจน์เทียบกับพหูพจน์) หรือลบออก (เช่น คําทั่วไปเกินไป)

ขั้นตอนที่ 5: ส่งออกหรือใช้ผลลัพธ์

ส่งออกรายการคําหลักหรือรวมเข้ากับเวิร์กโฟลว์ของคุณโดยตรง:

- ตัวเลือกการส่งออก : ดาวน์โหลดใน PDF, docx หรือ HTML

- กรณีการใช้งาน : รวมเข้ากับเครื่องมือ SEO เอกสารการวางแผนเนื้อหา โครงร่างการวิจัย หรือแดชบอร์ดการตลาด

เคล็ดลับในการสร้างคีย์เวิร์ดอย่างมีประสิทธิภาพ

การทําให้แน่ใจว่าการแยกคําหลักของคุณถูกต้องและสอดคล้องกับเป้าหมายของคุณต้องใช้กลยุทธ์ ต่อไปนี้เป็นแนวทางปฏิบัติที่ดีที่สุดที่ควรพิจารณา

1 ทําความสะอาดและประมวลผลข้อความล่วงหน้า

ลบคําหยุด อักขระพิเศษ และข้อมูลที่ไม่เกี่ยวข้องก่อนการวิเคราะห์เพื่อหลีกเลี่ยงความยุ่งเหยิง เครื่องมืออย่าง NLTK (Python) หรือโปรแกรมแก้ไขข้อความบางตัวสามารถทําให้ขั้นตอนการประมวลผลล่วงหน้านี้เป็นไปโดยอัตโนมัติ

2 ความถี่และความเกี่ยวข้องของสมดุล

คําหลักไม่ได้เกี่ยวกับจํานวนครั้งที่ปรากฏ แต่ยังเกี่ยวกับความสําคัญตามบริบทด้วย รวมเมตริกความถี่เข้ากับการวิเคราะห์ความหมายเพื่อสร้างสมดุลที่เหมาะสม

3 ใช้เทคนิคผสมผสาน

ใช้ประโยชน์จากหลายวิธี เช่นTF-IDFการวิเคราะห์ความหมาย หรือการจดจําเอนทิตีที่มีชื่อ เพื่อรวบรวมคําหลักที่เกี่ยวข้องได้ครบถ้วนยิ่งขึ้นและลดจุดบอดให้เหลือน้อยที่สุด

4 ทดสอบและปรับแต่งอย่างต่อเนื่อง

เทรนด์คําหลักสามารถเปลี่ยนแปลงได้เมื่อเวลาผ่านไป โดยเฉพาะอย่างยิ่งในอุตสาหกรรมที่เคลื่อนไหวอย่างรวดเร็ว อัปเดตคีย์เวิร์ดของคุณเป็นประจําโดยอิงจากข้อมูลใหม่ เมตริกประสิทธิภาพ หรือความต้องการของผู้ชมที่เปลี่ยนแปลงไป

สรุป: ลดความซับซ้อนของการสร้างคําหลักด้วย AI

การสร้างคําหลักที่มีประสิทธิภาพเป็นส่วนสําคัญของกลยุทธ์เนื้อหาที่ทันสมัยเวิร์กโฟลว์การวิจัยและงานวิเคราะห์ข้อมูล เครื่องมือที่ขับเคลื่อนด้วยAIและNLPเช่น Eskritor ทําให้การแยก ปรับแต่ง และส่งออกคําหลักที่มีมูลค่าสูงง่ายขึ้นกว่าที่เคยในเวลาเพียงเศษเสี้ยวของเวลาที่ต้องใช้เวลาด้วยตนเอง

ด้วยการผสมผสานเทคนิคหลายอย่าง เช่นTF-IDFการวิเคราะห์ความหมาย การสร้างแบบจําลองหัวข้อ และอื่นๆ คุณจะได้รับความเข้าใจอย่างครอบคลุมเกี่ยวกับสิ่งที่สําคัญอย่างแท้จริงในข้อความของคุณ ข้อมูลเชิงลึกนี้กระตุ้นผลลัพธ์ SEO ที่ดีขึ้นการวิจัยที่มุ่งเน้นมากขึ้นและสื่อการตลาดที่น่าสนใจ กล่าวโดยย่อ การแยกคําหลักตาม AIไม่ใช่ทางเลือกอีกต่อไป เป็นสิ่งจําเป็นสําหรับมืออาชีพที่ให้ความสําคัญกับประสิทธิภาพ ความแม่นยํา และการตัดสินใจที่ขับเคลื่อนด้วยข้อมูล

ดูไบ สหรัฐอาหรับเอมิเรตส์

ดูไบ สหรัฐอาหรับเอมิเรตส์