V dnešnom digitálnom prostredí je schopnosť generovať kľúčové slová z textu nevyhnutná pre SEO, tvorbu obsahu a akademický výskum. Identifikácia výrazov a fráz, ktoré najlepšie reprezentujú váš obsah, môže zlepšiť pozície vo vyhľadávačoch, zefektívniť výskumné úsilie a usmerniť efektívne stratégie obsahu. Moderné pokroky v spracovaní prirodzeného jazyka na extrakciu kľúčových slov robia tento proces jednoduchším a presnejším ako kedykoľvek predtým, pričom nástroje ako Eskritor vynikajú ako ukážkové príklady inovácií.

V tejto príručke preskúmame dôležitosť analýzy textu pri generovaní kľúčových slov, ponoríme sa do rôznych techník vrátane analýzy frekvencie výrazov pre kľúčové slová a používania TF-IDF na extrakciu kľúčových slov a rozoberieme sémantickú analýzu na generovanie kľúčových slov v kontexte. Zdôrazníme tiež najlepšie nástroje na generovanie kľúčových slov z textu a poskytneme podrobný návod na generovanie kľúčových slov.

Prečo generovať kľúčové slová z textu?

Extrakcia kľúčových slov je základom rôznych profesionálnych úloh – od zlepšovania pozícií webových stránok až po kategorizáciu výskumných dokumentov. Nižšie sú uvedené niektoré hlavné dôvody, prečo je tento proces životne dôležitý pre moderný obsah a dátové stratégie.

1 Optimalizácia obsahu pre SEO

Kľúčové slová tvoria chrbticu každej efektívnej stratégie optimalizácie pre vyhľadávače. Identifikáciou najrelevantnejších výrazov, ktoré používa vaša cieľová skupina, môžete optimalizovať príspevky na blogu, vstupné stránky a iný online obsah tak, aby sa vo výsledkoch vyhľadávania umiestnili vyššie. To nielen zvyšuje návštevnosť, ale tiež zvyšuje zapojenie používateľov zosúladením obsahu so zámerom čitateľa.

2 Zvýšte efektivitu výskumu

Pre študentov, výskumníkov a dátových analytikov môže extrakcia kľúčových slov výrazne skrátiť čas strávený preosievaním veľkých dokumentov alebo akademických prác. Zvýraznením hlavných myšlienok a terminológie môžete rýchlo kategorizovať zistenia, nájsť dôležité referencie a dokonca sledovať trendy vo viacerých štúdiách. Nástroje ako Google Scholar ďalej pomáhajú pri objavovaní súvisiacich výskumných tém a článkov.

3 Zlepšenie stratégie obsahu

Pochopenie kľúčových slov, ktoré rezonujú s vaším publikom – či už ide o dlhé kľúčové slová pre špecializované odvetvia alebo široké výrazy s vysokým objemom vyhľadávania – vám pomôže efektívnejšie plánovať kalendár obsahu. To zaisťuje, že každý kúsok, ktorý vytvoríte, hovorí priamo o tom, čo vaši čitatelia alebo zákazníci hľadajú, čo v konečnom dôsledku zvyšuje konverzie a spokojnosť používateľov.

4 Automatizácia manuálnych procesov

Preč sú časy, keď tímy museli manuálne prechádzať stránkami a stránkami textu, aby identifikovali opakujúce sa témy a frázy. Moderné nástroje na extrakciu kľúčových slov šetria čas a znižujú ľudské chyby automatizáciou celého procesu, čo vám umožní sústrediť sa na úlohy vyššej úrovne, ako je stratégia, analýza a realizácia.

5 Rýchlejšie výsledky

Manuálne spracovanie veľkých objemov textu je ťažkopádne. AI riešenie, ako je Eskritor, dokáže analyzovať stovky stránok v priebehu niekoľkých minút, čo vám umožní rýchlo iterovať a rýchlejšie prijímať rozhodnutia založené na údajoch.

Bežné techniky generovania kľúčových slov z textu

Rôzne techniky uspokojujú rôzne analytické potreby, či už chcete jednoduchý počet frekvencií alebo hlbšie sémantické pochopenie. Pozrime sa na najpoužívanejšie metódy a na to, ako pomáhajú extrahovať zmysluplné kľúčové slová.

1 Termálna frekvenčná analýza

Základná metóda, Term Frequency (TF), identifikuje najčastejšie používané slová alebo frázy v texte. Aj keď tento prístup môže odhaliť zjavné kľúčové slová, nezohľadňuje jedinečnosť alebo špecifickosť týchto výrazov vo viacerých dokumentoch.

2 TF-IDF (frekvencia termínov – inverzná frekvencia dokumentu)

TF-IDF spresňuje základnú analýzu frekvencie termínov zohľadnením dôležitosti termínu v množine dokumentov. Slová, ktoré sa často objavujú v jednom dokumente, ale zriedkavo v iných, získavajú vyššie skóre, vďaka čomu je táto technika vynikajúca na určenie špecializovanejších alebo kontextovo špecifických kľúčových slov.

3 Sémantická analýza

Sémantická analýza identifikuje kontextovo relevantné frázy skúmaním vzťahov medzi slovami, a nie len často používanými slovami. Je to užitočné najmä vtedy, ak chcete zachytiť synonymá, súvisiace výrazy alebo tematicky prepojené myšlienky, a nie opakujúce sa slová, ktoré nemusia mať význam.

4 Prístupy založené na NLP

Pokročilé NLP techniky, ako je rozpoznávanie pomenovaných entít (NER) a modelovanie tém, presahujú rámec jednoduchého počtu slov. NER identifikuje ľudí, miesta, organizácie a ďalšie špecifické subjekty, ktoré môžu byť kľúčovými kľúčovými slovami v žurnalistike alebo obchodnej analýze. Modelovanie tém odhaľuje širšie témy v texte, čo uľahčuje kategorizáciu veľkých objemov údajov.

Najlepšie nástroje na generovanie kľúčových slov z textu

Extrakciu kľúčových slov je možné vykonať pomocou rôznych špecializovaných nástrojov a platforiem. Nižšie je uvedený pohľad na niektoré hlavné možnosti, z ktorých každá je vhodná pre rôzne požiadavky používateľov – od optimalizácie SEO až po komplexnú analýzu údajov.

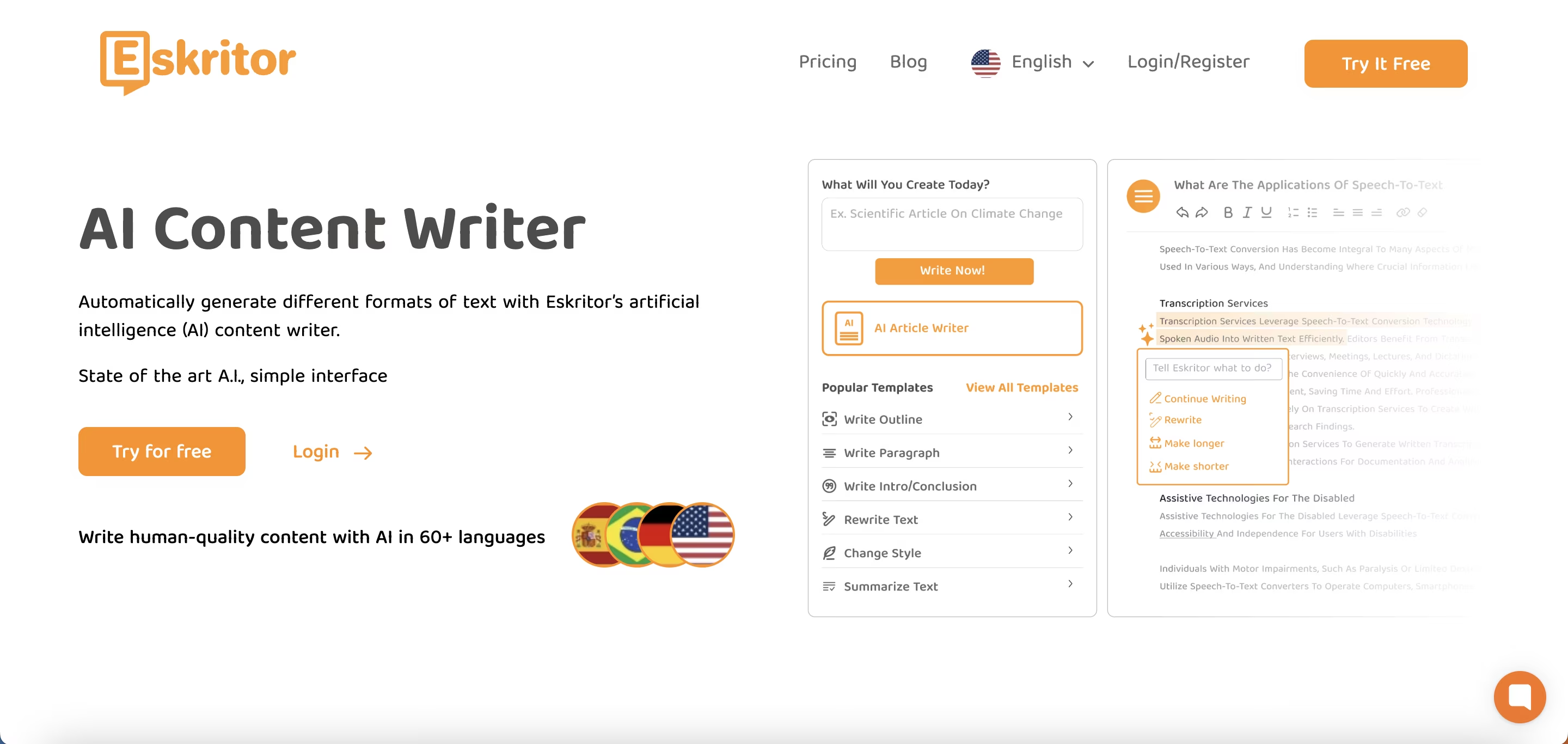

1 Eskritor

Eskritor je pokročilá platforma na písanie založená na AInavrhnutá tak, aby zjednodušila a zlepšila proces extrakcie kľúčových slov pre používateľov v rôznych oblastiach – či už optimalizujete pre SEO, vyvíjate marketingové kampane alebo vykonávate akademický výskum. Využitím výkonných algoritmov spracovania prirodzeného jazyka (NLP) Eskritor automaticky identifikuje kľúčové výrazy a frázy vo vašom texte, pričom zvýrazňuje kľúčové slová založené na frekvencii a kontextové poznatky.

Kľúčové vlastnosti

- AInástroj na písanie prispôsobený pre SEO, marketing a akademické použitie

- Jednoduché rozhranie na analýzu textu a generovanie použiteľných kľúčových slov

Prečo vyniká

- Urýchľuje analýzu kľúčových slov pomocou pokročilých algoritmov NLP

- Ponúka prispôsobiteľné možnosti frekvenčného filtrovania a sémantickej analýzy

2 Google Keyword Planner

Základ digitálnych marketérov Google Keyword Planner zosúlaďuje navrhované kľúčové slová s údajmi o objeme vyhľadávania. Aj keď je to primárne pre PPC kampane, pomáha tiež tvorcom obsahu spresniť ich témy na základe skutočných dopytov používateľov. Integrácia so spoločnosťou Google Ads poskytuje priamy prehľad o tom, ako často sa vyhľadávajú konkrétne výrazy, čo vám dáva náskok pri vytváraní obsahu, ktorý zodpovedá zámerom používateľa.

3 MonkeyLearn

Ideálne na analýzu textu MonkeyLearn poskytuje extrakciu kľúčových slov pomocou výkonných rozhraní API NLP . Vyniká kategorizáciou spätnej väzby, recenzií alebo rozhovorov na sociálnych sieťach, vďaka čomu je cenný pre značky zamerané na analýzu sentimentu a trendov. Informačný panel MonkeyLearnobsahuje možnosti spracovania v reálnom čase, čo znamená, že ho môžete nastaviť tak, aby nepretržite analyzoval prichádzajúce údaje – ideálne pre rýchle marketingové tímy alebo operácie zákazníckej podpory.

4 Knižnice R a Python

Pre používateľov, ktorí sú spokojní s programovaním, knižnice ako Tidytext (R) a spaCy (Python) umožňujú hĺbkovú a prispôsobiteľnú extrakciu kľúčových slov. Môžete implementovať TF-IDF, modelovanie tém a analýzu sentimentu pre vysoko špecializované alebo rozsiahle projekty.

Tieto knižnice ponúkajú flexibilitu pri doladení parametrov alebo integrácii s rámcami strojového učenia, vďaka čomu sú ideálne pre dátových vedcov alebo výskumníkov, ktorí vyžadujú plne prispôsobený kanál analýzy textu.

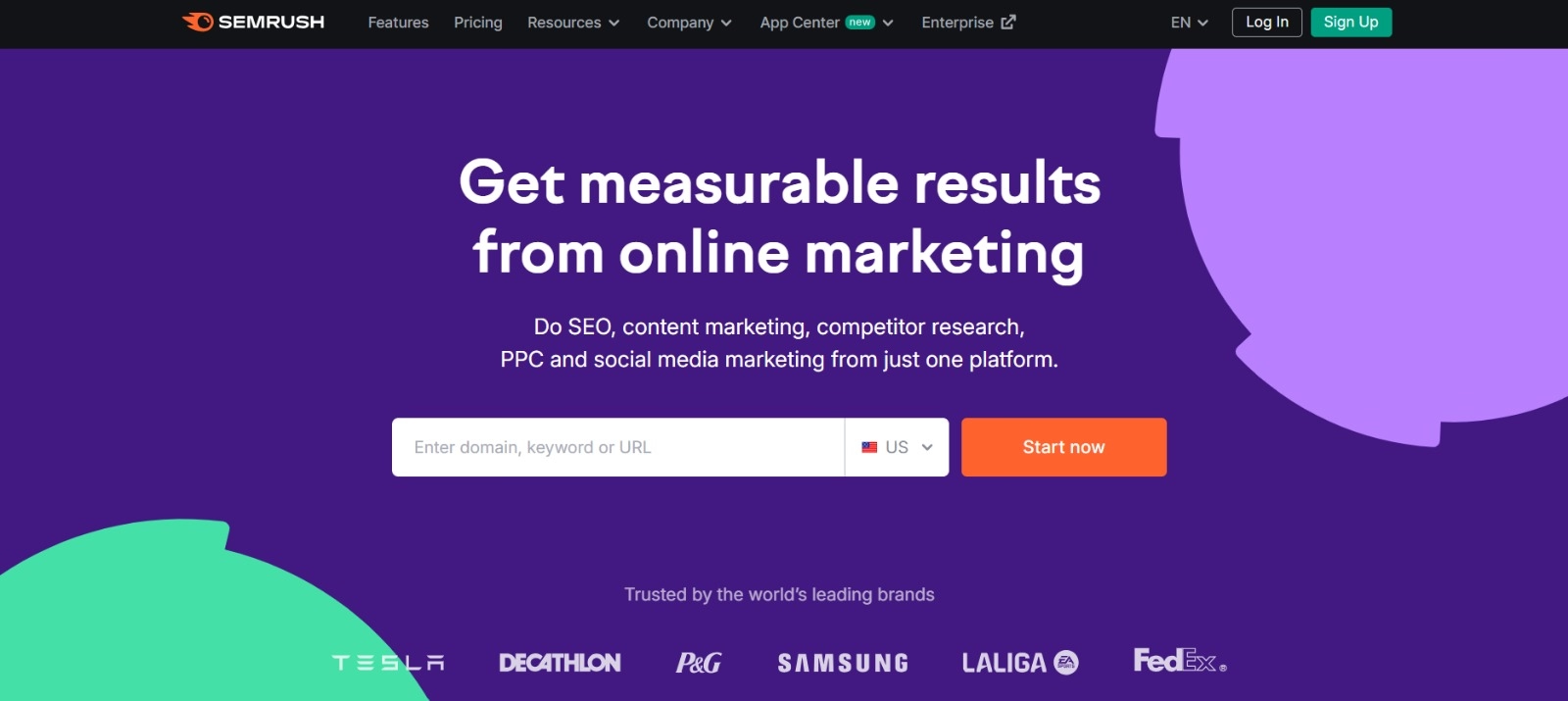

5 Semrush

Obľúbená voľba medzi SEO profesionálmi Semrush kombinuje výskum kľúčových slov s analýzou konkurencie. Jeho zameranie na objem vyhľadávania, skóre obtiažnosti a stratégie konkurencie pomáha vylepšiť obsahové plány pre maximálnu viditeľnosť.

Okrem návrhov kľúčových slov poskytuje Semrush prehľady na úrovni domény, ako sú profily spätných odkazov a analýza návštevnosti, čo umožňuje holistický prístup k taktikám SEO a digitálneho marketingu.

Podrobný sprievodca generovaním kľúčových slov pomocou Eskritor

Pokiaľ ide o jednoduchú, ale účinnú extrakciu kľúčových slov, Eskritor ponúka vynikajúcu rovnováhu medzi použiteľnosťou a pokročilými funkciami NLP . Tu je návod, ako čo najlepšie využiť jeho platformu.

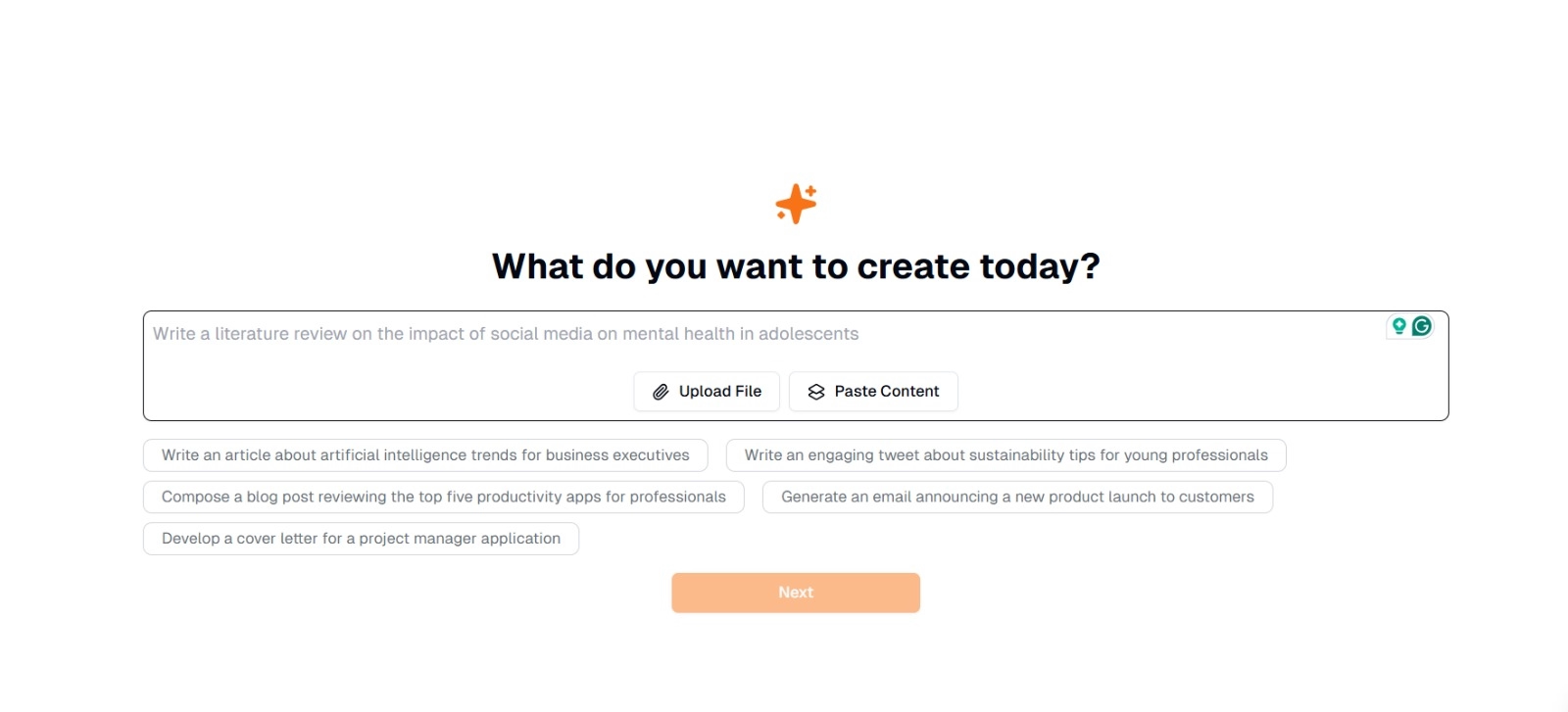

Krok 1: Zadajte alebo nahrajte svoj text

V hlavnom rozhraní Eskritoruvidíte výzvu s otázkou: "Čo chcete dnes vytvoriť?" Tu máte dve možnosti:

- Prilepiť obsah : Skopírujte a prilepte text priamo do daného textového poľa.

- Nahrať súbor : Vyberte dokument (napr. .docx, .pdf, .txt), ktorý obsahuje text, ktorý chcete analyzovať.

Tip : Ak plánujete vygenerovať alebo prepracovať text pred extrakciou, môžete si vybrať aj z navrhovaných výziev (napr. "Napíšte článok o trendoch umelej inteligencie...").

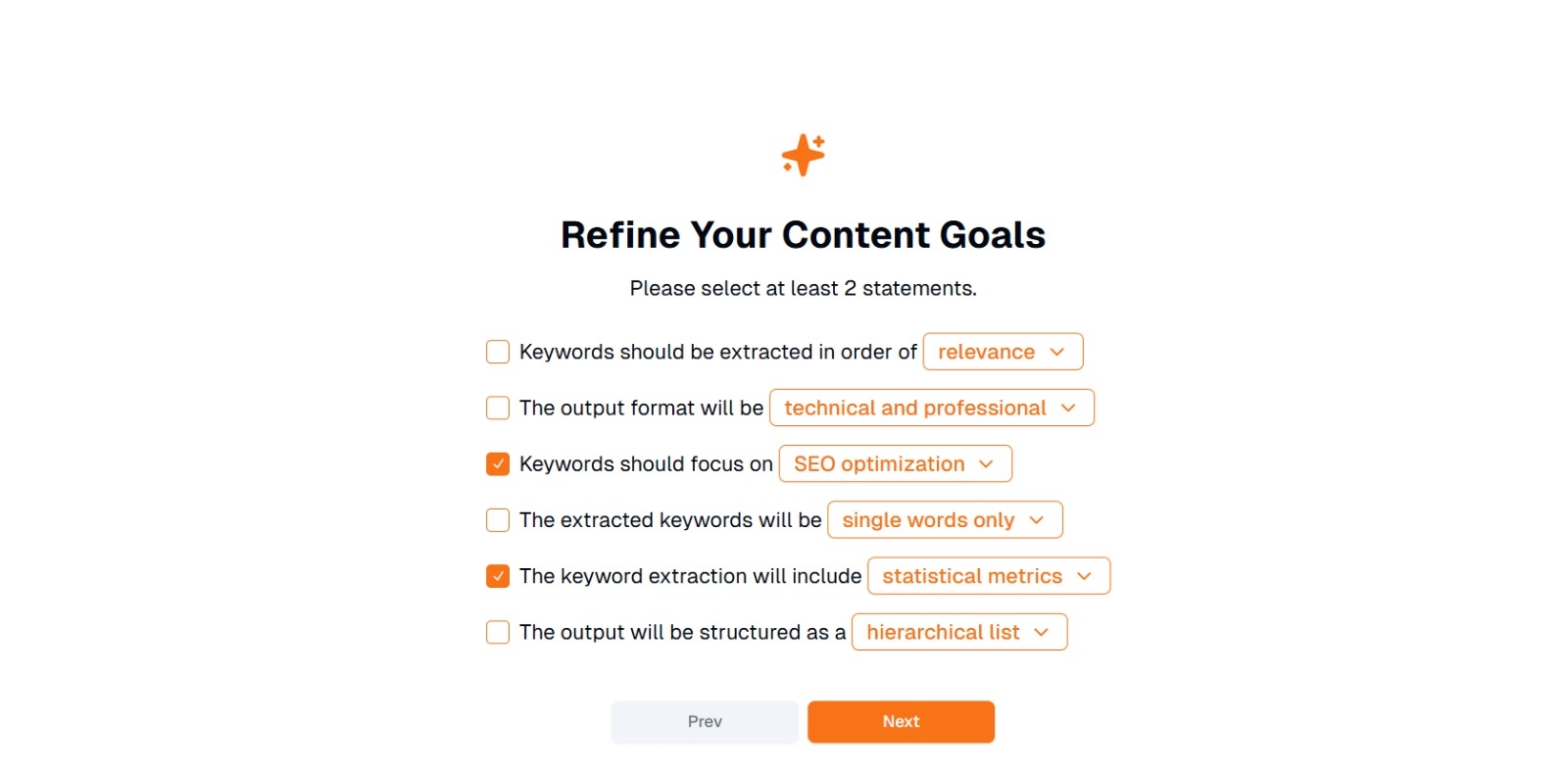

Krok 2: Spresnite ciele obsahu

Zobrazí sa výzva " Čo chcete robiť s týmto obsahom? " a požiadal o výber aspoň 2 vyhlásení . Môžete tiež napísať, čo chcete urobiť na chat. Možnosti môžu zahŕňať:

- Kľúčové slová by mali byť extrahované v poradí: (napr. relevantnosť , frekvencia , abecedné hodnotenie atď.)

- Výstupný formát bude: (napr. technický a profesionálny , neformálny a priateľský )

- Kľúčové slová by sa mali zamerať na: (napr. optimalizáciuSEO, akademický výskum, marketingové uhly pohľadu)

- Extrahované kľúčové slová budú: (napr. iba jednotlivé slová , viacslovné frázy )

- Extrakcia kľúčových slov bude zahŕňať: (napr. štatistické metriky , sémantické zoskupenie )

- Výstup bude štruktúrovaný ako: (napr. hierarchický zoznam , jednoduché odrážky )

Tip : Vyberte príkazy, ktoré najlepšie zodpovedajú potrebám vášho projektu. Napríklad, ak optimalizujete blogový príspevok pre vyhľadávače, zvážte kontrolu optimalizácieSEO, iba jednotlivé slová a extrahované v poradí podľa relevantnosti.

Krok 3: Kliknutím na tlačidlo "Ďalej" vygenerujte kľúčové slová

Po spresnení cieľov a požadovanom výbere kliknite na tlačidlo Ďalej (alebo podobné tlačidlo) a spustite extrakciu kľúčových slov. AI Eskritorspracuje text pomocou NLP metód, ako je frekvenčná analýza výrazov, TF-IDFa sémantická analýza (podľa potreby) na identifikáciu najrelevantnejších kľúčových slov.

Krok 4: Skontrolujte extrahované kľúčové slová

Eskritor zobrazí zoznam (alebo hierarchiu) kľúčových slov na základe vybratých kritérií. Zobrazenie môže obsahovať:

- Zoznam kľúčových slov : Usporiadané podľa relevantnosti, frekvencie alebo v hierarchickom formáte.

Tip : Dávajte si pozor na kľúčové slová, ktoré môže vyžadovať zlúčenie (napr. tvary jednotného čísla a množné číslo) alebo odstránenie (napr. príliš všeobecné výrazy).

Krok 5: Export alebo použitie výsledkov

Nakoniec exportujte zoznam kľúčových slov alebo ho začleňte priamo do svojho pracovného postupu:

- Možnosti exportu : Stiahnite si PDF, docx alebo HTML.

- Prípady použitia : Integrujte do SEO nástrojov, dokumentov na plánovanie obsahu, prehľadov výskumu alebo marketingových panelov.

Tipy na efektívne generovanie kľúčových slov

Zabezpečenie presnej extrakcie kľúčových slov a zosúladenia s vašimi cieľmi si vyžaduje stratégiu. Tu je niekoľko osvedčených postupov, ktoré je potrebné zvážiť.

1 Vyčistite a predbežne spracujte text

Pred analýzou odstráňte zastavené slová, špeciálne znaky a irelevantné údaje, aby ste sa vyhli neporiadku. Nástroje ako NLTK (Python) alebo niektoré textové editory môžu tento krok predbežného spracovania automatizovať.

2 Frekvencia a relevantnosť rovnováhy

Kľúčové slovo nie je len o tom, koľkokrát sa objaví, ale aj o kontextovej dôležitosti. Skombinujte metriky frekvencie so sémantickou analýzou, aby ste dosiahli správnu rovnováhu.

3 Použite kombináciu techník

Využite viaceré prístupy –TF-IDF, sémantickú analýzu alebo rozpoznávanie pomenovaných entít – na zachytenie širšieho rozsahu relevantných kľúčových slov a minimalizáciu slepých miest.

4 Priebežné testovanie a zdokonaľovanie

Trendy kľúčových slov sa môžu časom meniť, najmä v rýchlo sa rozvíjajúcich odvetviach. Kľúčové slová pravidelne aktualizujte na základe nových údajov, metrík výkonnosti alebo vyvíjajúcich sa potrieb publika.

Záver: Zjednodušte generovanie kľúčových slov pomocou AI

Generovanie efektívnych kľúčových slov je kľúčovou súčasťou moderných obsahových stratégií, výskumných pracovných postupov a úloh analýzy údajov. Nástroje založené na AI a NLP, ako je Eskritor, zjednodušili extrahovanie, spresňovanie a export kľúčových slov s vysokou hodnotou za zlomok času, ktorý by to trvalo manuálne.

Kombináciou viacerých techník –TF-IDF, sémantickej analýzy, modelovania tém a ďalších – získate komplexné pochopenie toho, na čom vo vašom texte skutočne záleží. Tento prehľad podporuje lepšie SEO výsledky, cielenejší výskum a pútavé marketingové materiály. Stručne povedané, extrakcia kľúčových slov na základe AIuž nie je voliteľná; Je to nevyhnutnosť pre profesionálov, ktorí oceňujú efektivitu, presnosť a rozhodovanie založené na údajoch.

Dubaj, Spojené arabské emiráty

Dubaj, Spojené arabské emiráty