今日のデジタル環境では、テキストからキーワードを生成する機能は、 SEO、コンテンツ作成、および学術研究に不可欠です。 コンテンツを最もよく表す用語やフレーズを特定することで、検索エンジンのランキングを向上させ、調査作業を合理化し、効果的なコンテンツ戦略を導くことができます。 キーワード抽出のための自然言語処理の最新の進歩により、このプロセスはこれまで以上に簡単かつ正確になり、 Eskritor のようなツールはイノベーションの代表的な例として際立っています。

このガイドでは、キーワード生成のためのテキスト分析の重要性を探り、キーワードの用語頻度分析やキーワード抽出のための TF-IDF の使用など、さまざまな手法を掘り下げ、コンテキストでキーワードを生成するためのセマンティック分析について説明します。 また、テキストからキーワードを生成するための最適なツールに焦点を当て、キーワード生成のステップバイステップのチュートリアルを提供します。

なぜテキストからキーワードを生成するのですか?

キーワード抽出は、ウェブサイトのランキング向上から研究文書の分類まで、さまざまな専門的なタスクを支えています。 以下は、このプロセスが現代のコンテンツおよびデータ戦略に不可欠である主な理由です。

1 コンテンツをSEO用に最適化する

キーワードは、効果的な 検索エンジン最適化 戦略のバックボーンを形成します。 ターゲットオーディエンスが使用する最も関連性の高い用語を特定することで、ブログ記事、ランディングページ、その他のオンラインコンテンツを最適化して、検索結果で上位にランク付けすることができます。 これにより、トラフィックが増加するだけでなく、コンテンツを読者の意図に合わせることで、ユーザーエンゲージメントも向上します。

2 研究効率の向上

学生、研究者、データアナリストにとって、キーワード抽出は、大きなドキュメントや学術論文をふるいにかけるのに費やす時間を大幅に短縮できます。 主要なアイデアや用語を強調することで、調査結果を迅速に分類し、重要な参考文献を特定し、さらには複数の研究の傾向を追跡することができます。 Google Scholarのようなツールは、関連する研究トピックや記事を見つけるのにさらに役立ちます。

3 コンテンツ戦略の改善

ニッチな業界のロングテールキーワードや検索ボリュームの多い広義のキーワードなど、どのキーワードがオーディエンスの共感を呼ぶかを理解することは、コンテンツカレンダーをより効果的に計画するのに役立ちます。 これにより、制作する各作品が読者や顧客が探しているものに直接語りかけるようになり、最終的にコンバージョンとユーザー満足度が向上します。

4 手動プロセスの自動化

チームが繰り返し発生するテーマやフレーズを特定するために、テキストのページを手作業でざっと見なければならなかった時代は終わりました。 最新のキーワード抽出ツールは、プロセス全体を自動化することで時間を節約し、人為的ミスを減らし、戦略、分析、実行などのより高いレベルのタスクに集中できるようにします。

5 より迅速な結果

大量のテキストを手動で処理するのは面倒です。 EskritorのようなAIソリューションは、数百ページをわずか数分で分析できるため、迅速に反復し、データドリブンな意思決定を迅速に行うことができます。

テキストからキーワードを生成するための一般的な手法

さまざまな手法が、単純な周波数カウントが必要な場合でも、より深い意味の理解が必要な場合でも、さまざまな分析ニーズに対応します。 ここでは、最も広く使用されている方法と、それらが意味のあるキーワードの抽出にどのように役立つかを探ってみましょう。

1 用語頻度分析

基本的な方法である用語頻度(TF)は、テキスト内で最も一般的に使用される単語やフレーズを特定します。 このアプローチでは、明らかなキーワードを浮かび上がらせることができますが、複数のドキュメント間でのそれらの用語の一意性や特異性は考慮されていません。

2 TF-IDF (用語の頻度 - 逆ドキュメントの頻度)

TF-IDFは、一連のドキュメント全体で用語がどの程度重要であるかを考慮に入れることにより、基本的な用語の頻度分析を洗練します。 あるドキュメントに頻繁に出現し、他のドキュメントにはめったに出現しない単語は、より高いスコアを獲得するため、この手法は、より専門的なキーワードやコンテキスト固有のキーワードを特定するのに最適です。

3 セマンティック分析

セマンティック分析は、頻繁に使用される単語だけでなく、単語間の関係を調べることにより、文脈的に関連性のあるフレーズを特定します。 これは、意味を持たない可能性のある繰り返しの単語ではなく、同義語、関連用語、またはテーマに関連したアイデアをキャプチャする場合に特に便利です。

4 NLPベースのアプローチ

名前付きエンティティ認識 (NER) やトピック モデリングなどの高度な NLP 手法は、単純な単語数を超えています。 NERは、ジャーナリズムやビジネス分析において重要なキーワードとなる可能性のある、人、場所、組織、およびその他の特定のエンティティを特定します。 トピックモデリングは、テキスト内のより広範なテーマを明らかにするため、大量のデータを分類しやすくなります。

テキストからキーワードを生成するための最良のツール

キーワード抽出は、さまざまな専用ツールとプラットフォームを使用して実行できます。 以下では、 SEO の最適化から包括的なデータ分析まで、さまざまなユーザー要件に適した主要なオプションをいくつかご紹介します。

1 Eskritor

Eskritorは、SEOの最適化、マーケティングキャンペーンの開発、学術研究の実施など、さまざまな分野のユーザーのキーワード抽出プロセスを簡素化および強化するように設計された、高度なAI主導のライティングプラットフォームです。 強力な自然言語処理(NLP)アルゴリズムを活用することで、 Eskritor テキスト内の重要な用語やフレーズを自動的に識別し、頻度ベースのキーワードとコンテキスト主導の洞察の両方を強調します。

主な機能

- SEO、マーケティング、学術用途向けに調整されたAIパワードライティングツール

- テキストを分析し、実用的なキーワードを生成するためのシンプルなインターフェース

なぜそれが際立っているのか

- 高度な NLP アルゴリズムでキーワード分析を高速化

- 周波数フィルタリングとセマンティック解析のためのカスタマイズ可能なオプションを提供

2 Google Keyword Planner

デジタルマーケターの定番である Google Keyword Planner 、提案されたキーワードを検索ボリュームデータと一致させます。 これは主に PPC キャンペーン用ですが、コンテンツ作成者が実際のユーザーのクエリに基づいてトピックを絞り込むのにも役立ちます。 Google Adsとの統合により、特定の用語が検索される頻度を直接把握できるため、ユーザーの意図に合ったコンテンツの作成を有利に進めることができます。

3 MonkeyLearn

テキスト分析に最適な MonkeyLearn 、強力な NLP APIを使用してキーワード抽出を提供します。 フィードバック、レビュー、ソーシャルメディアのチャットを分類することに優れているため、センチメント分析やトレンド分析に重点を置くブランドにとって価値があります。 MonkeyLearnのダッシュボードには、リアルタイム処理のオプションが含まれているため、受信データを継続的に分析するように設定でき、ペースの速いマーケティング チームやカスタマー サポート業務に最適です。

4 R ライブラリと Python ライブラリ

プログラミングに慣れているユーザーのために、Tidytext(R)や spaCy (Python)などのライブラリを使用すると、詳細でカスタマイズ可能なキーワード抽出が可能になります。 高度に専門化されたプロジェクトや大規模なプロジェクトに対して、 TF-IDF、トピックモデリング、感情分析を実装できます。

これらのライブラリは、パラメーターを微調整したり、機械学習フレームワークと統合したりする柔軟性を備えているため、完全にカスタマイズされたテキスト分析パイプラインを必要とするデータサイエンティストや研究者に最適です。

5 Semrush

SEOの専門家の間で人気のある選択肢であるSemrush、キーワード調査と競合分析を組み合わせたものです。 検索ボリューム、難易度スコア、競合他社の戦略に焦点を当てることで、コンテンツプランを洗練し、可視性を最大限に高めることができます。

キーワードの提案だけでなく、 Semrush はバックリンクプロファイルやトラフィック分析などのドメインレベルのインサイトを提供し、 SEO およびデジタルマーケティング戦術への包括的なアプローチを可能にします。

Eskritorでキーワードを生成するためのステップバイステップガイド

シンプルでありながら強力なキーワード抽出に関しては、 Eskritor 使いやすさと高度な NLP 機能の優れたバランスを提供します。 ここでは、そのプラットフォームを最大限に活用する方法をご紹介します。

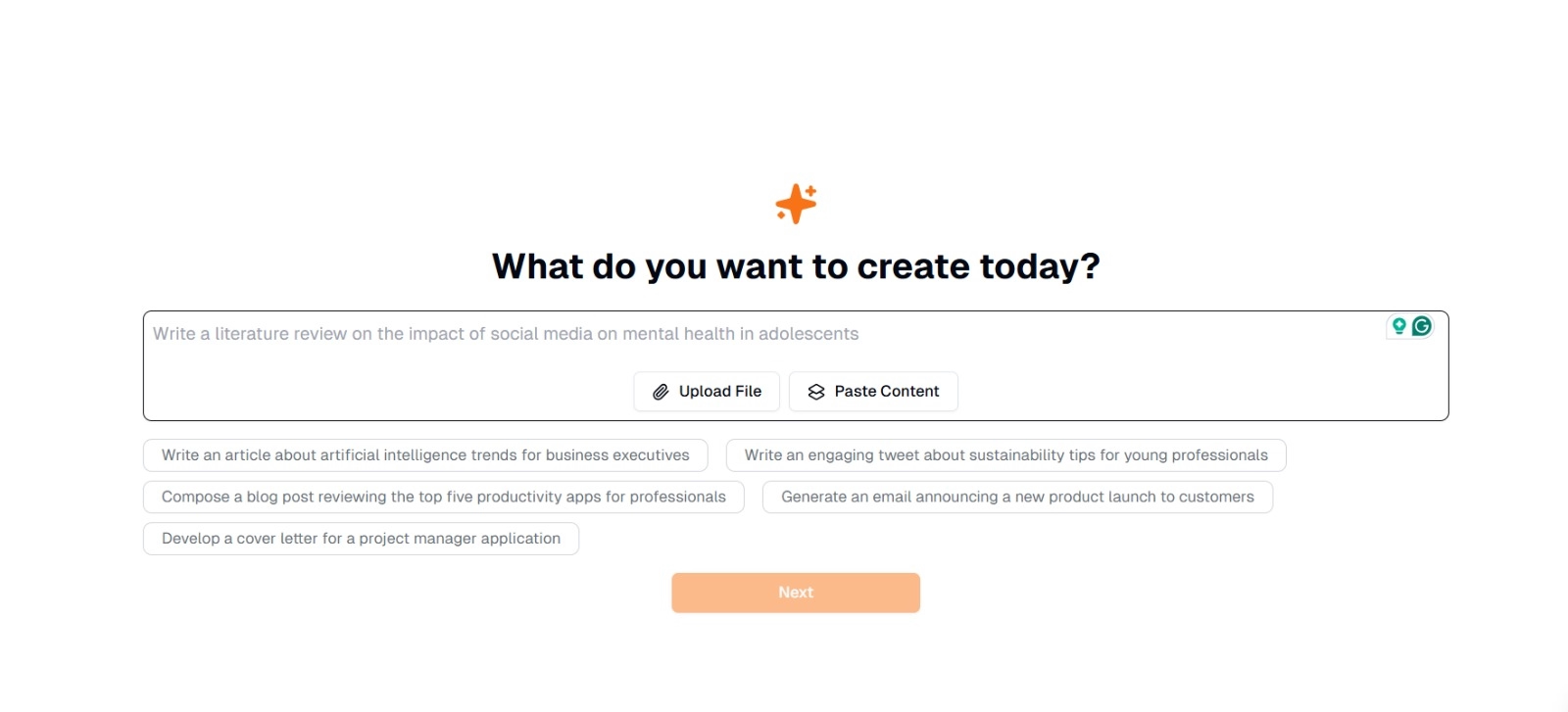

ステップ1:テキストを入力またはアップロードする

Eskritorのメインインターフェイスには、「今日は何を作成しますか?」というプロンプトが表示されます。ここでは、次の 2 つのオプションがあります。

- コンテンツの貼り付け :テキストをコピーして、指定されたテキストボックスに直接貼り付けます。

- ファイルのアップロード : 分析するテキストを含むドキュメント(.docx、.pdf、.txtなど)を選択します。

ヒント :抽出前にテキストの生成または再加工を計画している場合は、提案されたプロンプト(「人工知能のトレンドについての記事を書いてください...」など)から選択することもできます。

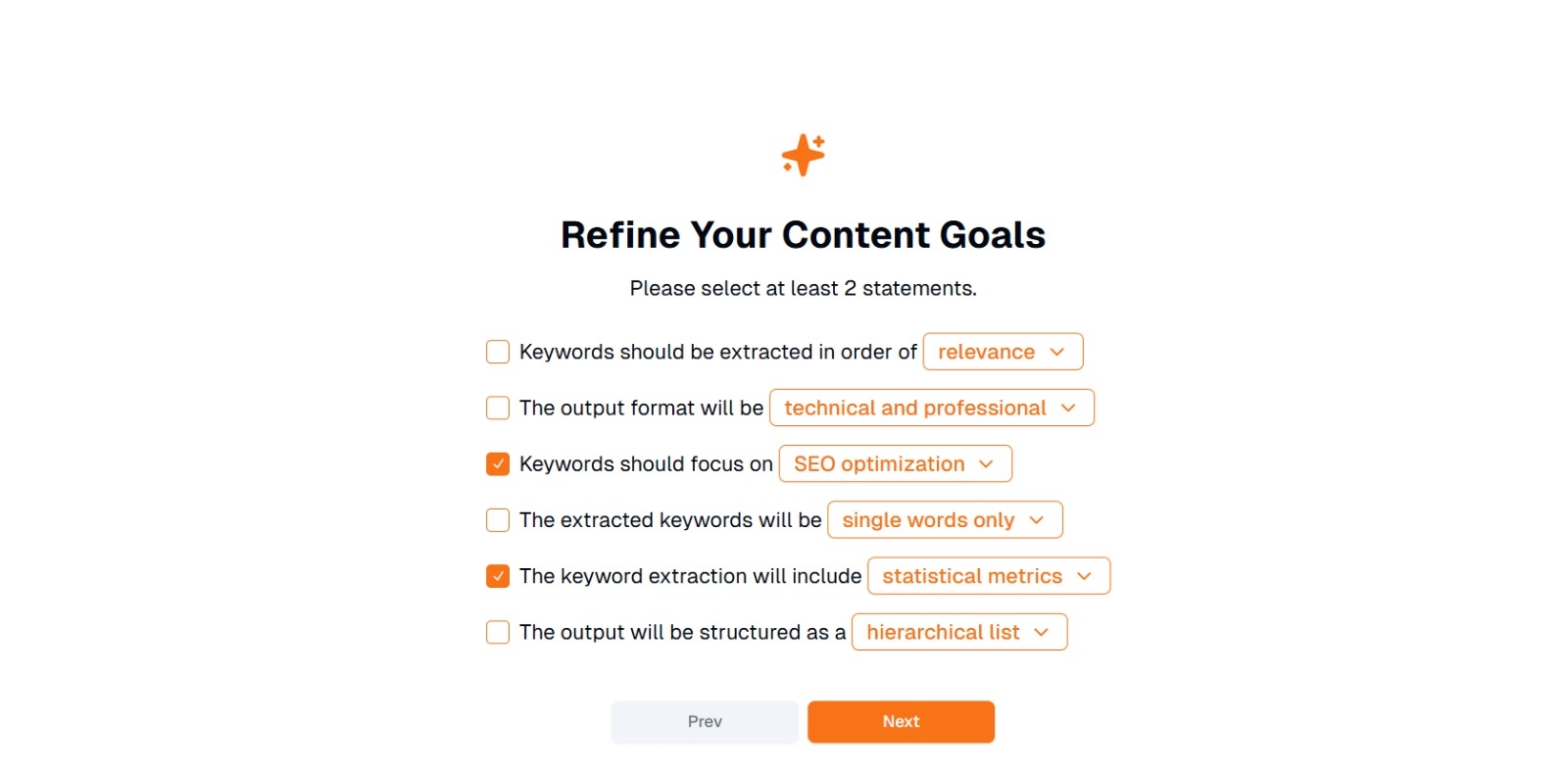

ステップ 2: コンテンツの目標を絞り込む

「このコンテンツで何をしますか?」をクリックし、少なくとも 2 つのステートメントを選択するように求められました。 また、チャットにやりたいことを書くこともできます。 オプションには次のものが含まれます。

- キーワードは、次の順序で抽出する必要があります (例: relevance 、 frequency 、 alphabetical など)。

- 出力形式は次のようになります( 例: 技術的および専門 的、 カジュアルおよびフレンドリー )

- キーワードは以下に焦点を当てるべきです(例: SEOの最適化、学術研究、マーケティングの角度)

- 抽出されるキーワードは、次のようになります( 例: 1つの単語のみ 、 複数単語のフレーズ )

- キーワード抽出には、次のものが含まれます(例:統計メトリック、セマンティックグループ化)

- 出力は次のように構成されます( 例: 階層リスト 、 単純な箇条書き )

ヒント : プロジェクトのニーズに最も適したステートメントを選択してください。 たとえば、検索エンジン向けにブログ記事を最適化する場合は、 SEO 最適化 、 1 つの単語のみ 、 関連性の高い順に抽出 することを検討してください。

ステップ3:「次へ」をクリックしてキーワードを生成します

目標を絞り込み、必要な選択を行ったら、[次へ](または同様のボタン)をクリックしてキーワード抽出を開始します。 EskritorのAIは、用語の頻度分析、TF-IDF、セマンティック分析 (該当する場合) などのNLP方法を適用して、テキストを処理し、最も関連性の高いキーワードを特定します。

ステップ 4: 抽出したキーワードを確認する

Eskritor 選択した条件に基づいて、キーワードのリスト(または階層)が表示されます。 表示には、次のものが含まれます。

- キーワードリスト : 関連性、頻度、または階層形式で配置されます。

ヒント : 統合が必要なキーワード(単数形と複数形など)や削除が必要なキーワード(過度に一般的な用語など)に注意してください。

ステップ 5: 結果をエクスポートまたは適用する

最後に、キーワードリストをエクスポートするか、ワークフローに直接組み込みます。

- エクスポートオプション : PDF、docx、または HTMLでダウンロードします。

- 使用例 : SEO ツール、コンテンツ計画ドキュメント、調査概要、またはマーケティングダッシュボードに統合します。

効果的なキーワード生成のヒント

キーワード抽出が正確で、目標に沿っていることを確認するには、戦略が必要です。 ここでは、考慮すべきベストプラクティスをいくつか紹介します。

1 テキストのクリーニングと前処理

分析前にストップワード、特殊文字、無関係なデータを削除して、混乱を防ぎます。 NLTK (Python) や特定のテキストエディターなどのツールを使用すると、この前処理手順を自動化できます。

2 頻度と関連性のバランス

キーワードは、出現回数だけでなく、文脈上の重要性も重要です。 頻度メトリクスとセマンティック分析を組み合わせて、適切なバランスを取ります。

3 さまざまな手法を組み合わせて使用する

TF-IDF、セマンティック分析、名前付きエンティティ認識など、複数のアプローチを活用して、関連するキーワードをより幅広くキャプチャし、盲点を最小限に抑えます。

4 継続的なテストと改良

キーワードのトレンドは、特に動きの速い業界では、時間の経過とともに変化する可能性があります。 新しいデータ、掲載結果の指標、進化するユーザーのニーズに基づいて、キーワードを定期的に更新します。

結論:AIによるキーワード生成の簡素化

効果的なキーワードを生成することは、現代のコンテンツ戦略、調査ワークフロー、データ分析タスクにおいて極めて重要な部分です。 EskritorのようなAIおよびNLP主導のツールにより、手動で行う時間のほんの一部で、価値の高いキーワードを抽出、絞り込み、エクスポートすることがこれまでになく簡単になりました。

TF-IDF、セマンティック分析、トピックモデリングなど、複数の手法を組み合わせることで、テキストで本当に重要なことを包括的に理解することができます。 このインサイトは、より良い SEO 成果、より焦点を絞った調査、魅力的なマーケティング資料を促進します。 つまり、 AIベースのキーワード抽出はもはやオプションではありません。効率性、精度、データドリブンな意思決定を重視するプロフェッショナルにとっては、必需品です。

アラブ首長国連邦、ドバイ

アラブ首長国連邦、ドバイ