Nel panorama digitale odierno, la capacità di generare parole chiave dal testo è essenziale per la SEO, la creazione di contenuti e la ricerca accademica. Identificare i termini e le frasi che meglio rappresentano i tuoi contenuti può migliorare il posizionamento nei motori di ricerca, semplificare le attività di ricerca e guidare strategie di contenuto efficaci. I moderni progressi nell'elaborazione del linguaggio naturale per l'estrazione di parole chiave rendono questo processo più semplice e accurato che mai, con strumenti come Eskritor che si distinguono come i primi esempi di innovazione.

In questa guida, esploreremo l'importanza dell'analisi del testo per la generazione di parole chiave, approfondiremo varie tecniche, tra cui l'analisi della frequenza dei termini per le parole chiave e l'utilizzo di TF-IDF per l'estrazione delle parole chiave, e discuteremo l'analisi semantica per la generazione di parole chiave nel contesto. Evidenzieremo anche i migliori strumenti per generare parole chiave dal testo e forniremo un tutorial passo passo per la generazione di parole chiave.

Perché generare parole chiave dal testo?

L'estrazione delle parole chiave è alla base di una serie di attività professionali, dal miglioramento del posizionamento dei siti web alla categorizzazione dei documenti di ricerca. Di seguito sono riportati alcuni motivi principali per cui questo processo è vitale per le moderne strategie di contenuti e dati.

1 Ottimizza i contenuti per SEO

Le parole chiave costituiscono la spina dorsale di qualsiasi strategia efficace di ottimizzazione per i motori di ricerca . Identificando i termini più pertinenti utilizzati dal tuo pubblico di destinazione, puoi ottimizzare i post del blog, le pagine di destinazione e altri contenuti online per posizionarti più in alto nei risultati di ricerca. Questo non solo aumenta il traffico, ma migliora anche il coinvolgimento degli utenti allineando i contenuti con l'intento del lettore.

2 Migliora l'efficienza della ricerca

Per studenti, ricercatori e analisti di dati, l'estrazione di parole chiave può ridurre significativamente il tempo impiegato per setacciare documenti di grandi dimensioni o documenti accademici. Evidenziando le idee e la terminologia principali, è possibile classificare rapidamente i risultati, individuare riferimenti importanti e persino tenere traccia delle tendenze in più studi. Strumenti come Google Scholar aiutano ulteriormente a scoprire argomenti e articoli di ricerca correlati.

3 Migliora la strategia dei contenuti

Capire quali parole chiave risuonano con il tuo pubblico, che si tratti di parole chiave a coda lunga per settori di nicchia o di termini generici con volumi di ricerca elevati, ti aiuta a pianificare il tuo calendario dei contenuti in modo più efficace. Ciò garantisce che ogni pezzo che produci parli direttamente a ciò che i tuoi lettori o clienti stanno cercando, aumentando in ultima analisi le conversioni e la soddisfazione degli utenti.

4 Automatizza i processi manuali

Sono finiti i giorni in cui i team dovevano scorrere manualmente pagine e pagine di testo per identificare temi e frasi ricorrenti. I moderni strumenti di estrazione delle parole chiave consentono di risparmiare tempo e ridurre l'errore umano automatizzando l'intero processo, consentendoti di concentrarti su attività di livello superiore come strategia, analisi ed esecuzione.

5 Risultati più rapidi

L'elaborazione manuale di grandi volumi di testo è complessa. Una soluzione AI come Eskritor è in grado di analizzare centinaia di pagine in pochi minuti, consentendoti di iterare rapidamente e prendere decisioni basate sui dati più velocemente.

Tecniche comuni per la generazione di parole chiave dal testo

Diverse tecniche soddisfano le varie esigenze analitiche, sia che si desideri un semplice conteggio delle frequenze o una comprensione semantica più approfondita. Esploriamo i metodi più utilizzati e come aiutano a estrarre parole chiave significative.

1 Analisi della frequenza dei termini

Un metodo fondamentale, la Term Frequency (TF), identifica le parole o le frasi più comunemente usate all'interno di un testo. Sebbene questo approccio possa far emergere parole chiave ovvie, non tiene conto dell'unicità o della specificità di tali termini in più documenti.

2 TF-IDF (Frequenza dei termini–Frequenza inversa dei documenti)

TF-IDF perfeziona l'analisi di base della frequenza dei termini tenendo conto dell'importanza di un termine in un insieme di documenti. Le parole che compaiono frequentemente in un documento ma raramente in altri ricevono un punteggio più alto, il che rende questa tecnica eccellente per individuare parole chiave più specializzate o specifiche del contesto.

3 Analisi semantica

L'analisi semantica identifica le frasi contestualmente rilevanti esaminando le relazioni tra le parole piuttosto che solo quelle usate di frequente. Ciò è particolarmente utile se si desidera catturare sinonimi, termini correlati o idee tematicamente collegate piuttosto che parole ripetitive che potrebbero non avere significato.

4 Approcci basati sulla NLP

Tecniche di NLP avanzate come il riconoscimento di entità denominate (NER) e la modellazione degli argomenti vanno oltre il semplice conteggio delle parole. NER identifica persone, luoghi, organizzazioni e altre entità specifiche, che possono essere parole chiave cruciali nel giornalismo o nell'analisi aziendale. La modellazione degli argomenti rivela temi più ampi all'interno di un testo, semplificando la categorizzazione di grandi volumi di dati.

I migliori strumenti per generare parole chiave dal testo

L'estrazione delle parole chiave può essere eseguita utilizzando una serie di strumenti e piattaforme specializzate. Di seguito è riportata una panoramica di alcune opzioni principali, ciascuna adatta alle diverse esigenze degli utenti, dall'ottimizzazione SEO all'analisi completa dei dati.

1 Eskritor

Eskritor è una piattaforma di scrittura avanzata e basata sul AIprogettata per semplificare e migliorare il processo di estrazione delle parole chiave per gli utenti in vari campi, sia che tu stia ottimizzando per SEO, sviluppando campagne di marketing o conducendo ricerche accademiche. Sfruttando potenti algoritmi di elaborazione del linguaggio naturale (NLP), Eskritor identifica automaticamente i termini e le frasi cruciali nel testo, evidenziando sia le parole chiave basate sulla frequenza che le informazioni basate sul contesto.

Caratteristiche principali

- AIstrumento di scrittura su misura per SEO, marketing e uso accademico

- Interfaccia semplice per l'analisi del testo e la generazione di parole chiave utilizzabili

Perché si distingue

- Velocizza l'analisi delle parole chiave con algoritmi di NLP avanzati

- Offre opzioni personalizzabili per il filtraggio della frequenza e l'analisi semantica

2 Google Keyword Planner

Un punto fermo per i marketer digitali, Google Keyword Planner allinea le parole chiave suggerite con i dati sul volume di ricerca. Sebbene sia principalmente per le campagne PPC, aiuta anche i creatori di contenuti a perfezionare i loro argomenti in base alle query degli utenti reali. L'integrazione con Google Ads fornisce informazioni dirette sulla frequenza con cui vengono cercati termini specifici, offrendoti un vantaggio nella creazione di contenuti che corrispondano alle intenzioni dell'utente.

3 MonkeyLearn

Ideale per l'analisi del testo, MonkeyLearn fornisce l'estrazione di parole chiave utilizzando potenti API NLP . Eccelle nella categorizzazione di feedback, recensioni o chiacchiere sui social media, il che lo rende prezioso per i marchi che si concentrano sull'analisi del sentiment e delle tendenze. MonkeyLearndashboard include opzioni per l'elaborazione in tempo reale, il che significa che puoi configurarlo per analizzare continuamente i dati in entrata, perfetto per i team di marketing frenetici o le operazioni di assistenza clienti.

4 Librerie R e Python

Per gli utenti che hanno dimestichezza con la programmazione, librerie come Tidytext (Python) e spaCy ( ) consentono l'estrazione di parole chiave approfondite e personalizzabili. È possibile implementare TF-IDF, la modellazione degli argomenti e l'analisi del sentiment per progetti altamente specializzati o su larga scala.

Queste librerie offrono la flessibilità necessaria per ottimizzare i parametri o integrarsi con i framework di machine learning, rendendole ideali per i data scientist o i ricercatori che necessitano di una pipeline di analisi del testo completamente personalizzata.

5 Semrush

Una scelta popolare tra i professionisti SEO , Semrush combina la ricerca di parole chiave con l'analisi della concorrenza. La sua attenzione al volume di ricerca, ai punteggi di difficoltà e alle strategie della concorrenza aiuta a perfezionare i piani di contenuto per la massima visibilità.

Oltre ai suggerimenti di parole chiave, Semrush fornisce approfondimenti a livello di dominio, come profili di backlink e analisi del traffico, consentendo un approccio olistico alle SEO e alle tattiche di marketing digitale.

Guida passo passo alla generazione di parole chiave con Eskritor

Quando si tratta di estrarre parole chiave in modo semplice ma potente, Eskritor offre un eccellente equilibrio tra usabilità e funzionalità di NLP avanzate. Ecco come sfruttare al meglio la sua piattaforma.

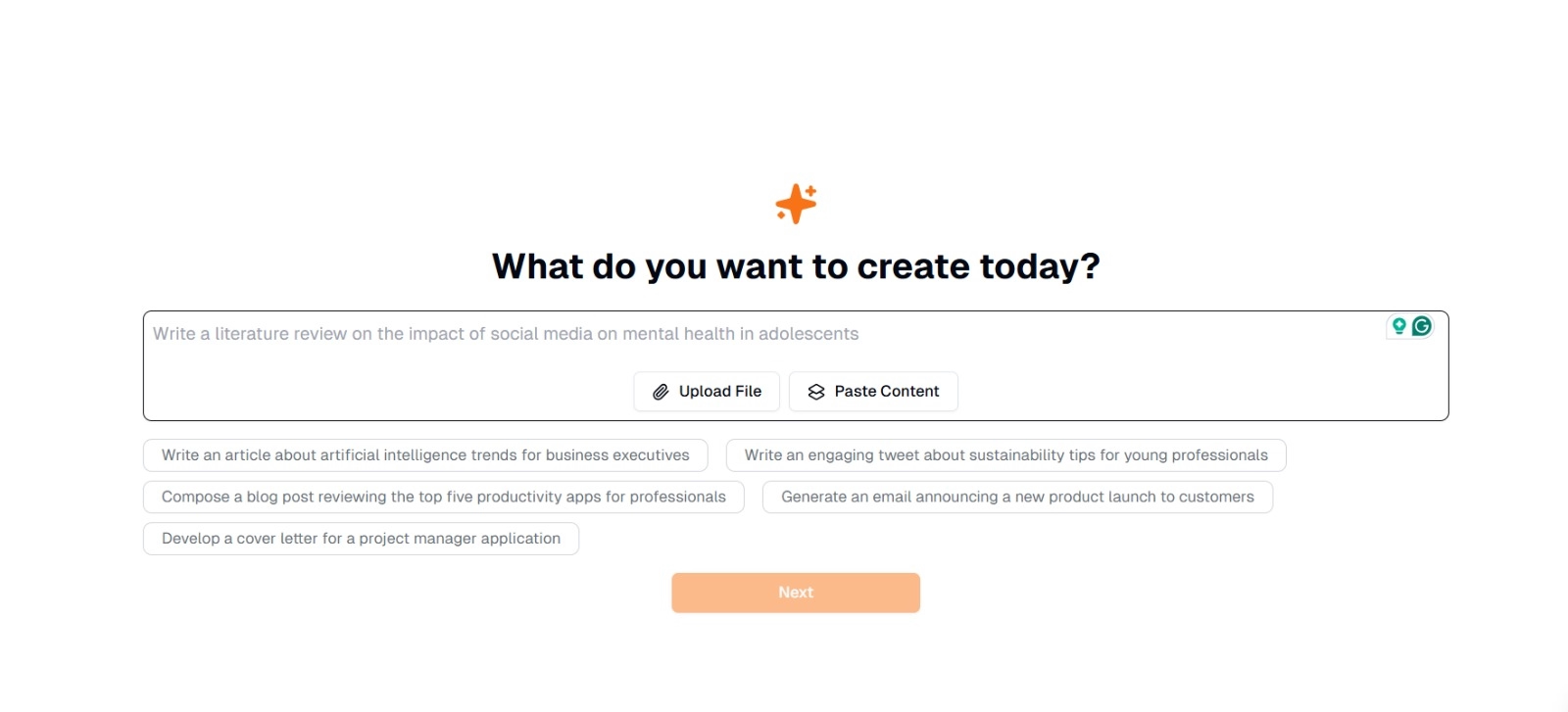

Passaggio 1: inserisci o carica il testo

Nell'interfaccia principale di Eskritor, vedrai un messaggio che chiede: "Cosa vuoi creare oggi?" Qui hai due opzioni:

- Incolla contenuto : copia e incolla il testo direttamente nella casella di testo specificata.

- Carica file : Scegli un documento (ad esempio, .docx, .pdf, .txt) che contenga il testo che desideri analizzare.

Suggerimento: puoi anche selezionare tra i suggerimenti suggeriti (ad esempio, "Scrivi un articolo sulle tendenze dell'intelligenza artificiale...") se prevedi di generare o rielaborare il testo prima dell'estrazione.

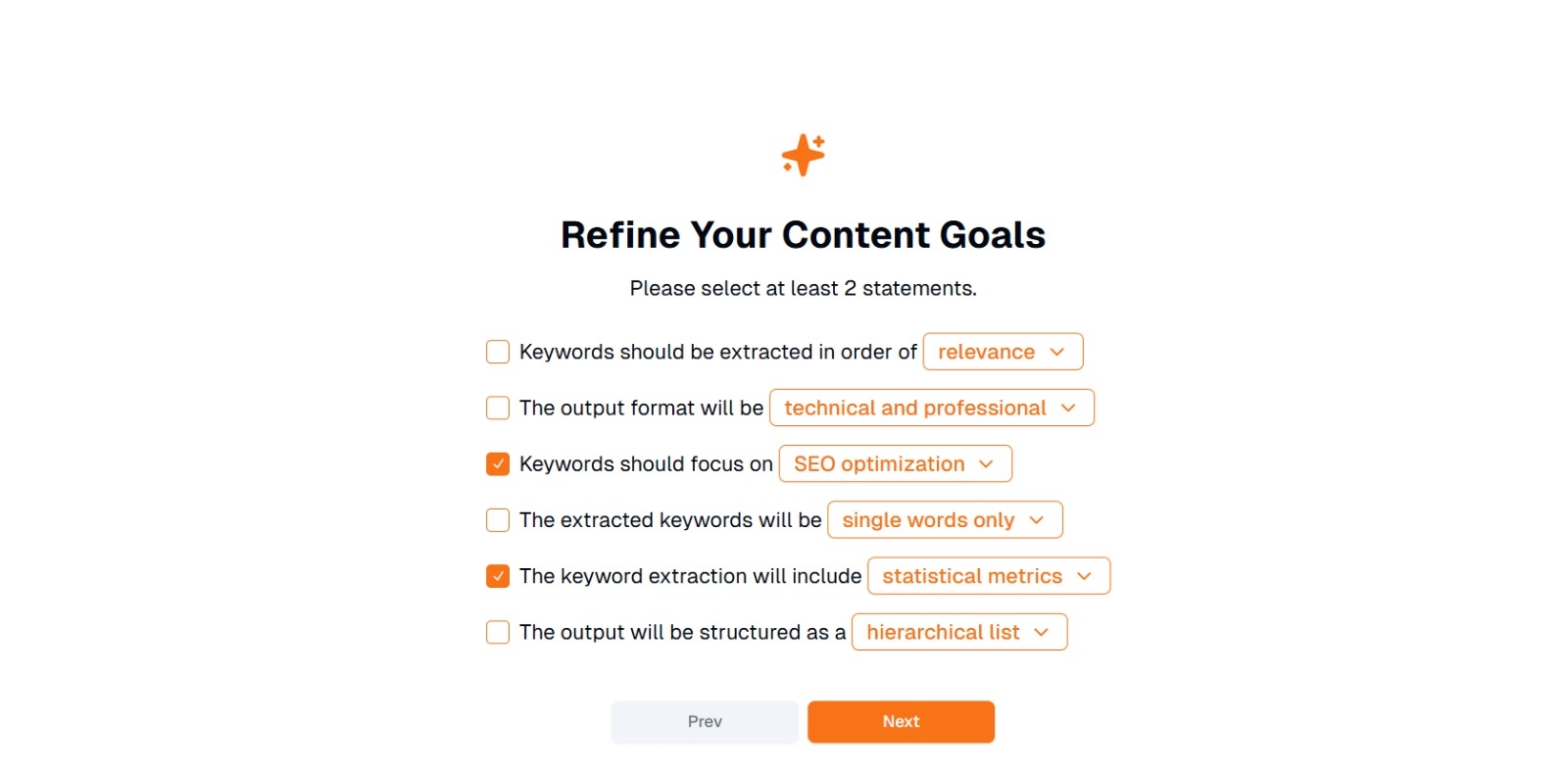

Passaggio 2: perfeziona i tuoi obiettivi di contenuto

Ti verrà chiesto " Cosa vuoi fare con questo contenuto? " e ha chiesto di selezionare almeno 2 estratti conto . Inoltre, puoi scrivere cosa vuoi fare per chattare. Le opzioni possono includere:

- Le parole chiave devono essere estratte in ordine di: (ad esempio, pertinenza , frequenza , ordine alfabetico , ecc.)

- Il formato di output sarà: (ad esempio, tecnico e professionale , informale e amichevole )

- Le parole chiave dovrebbero concentrarsi su: (ad esempio, ottimizzazioneSEO, ricerca accademica, angoli di marketing)

- Le parole chiave estratte saranno: (ad esempio, solo parole singole , frasi composte da più parole )

- L'estrazione delle parole chiave includerà: (ad esempio, metriche statistiche , raggruppamento semantico )

- L'output sarà strutturato come: (ad esempio, un elenco gerarchico , semplici elenchi puntati )

Suggerimento : seleziona le dichiarazioni che meglio corrispondono alle esigenze del tuo progetto. Ad esempio, se stai ottimizzando un post del blog per i motori di ricerca, prendi in considerazione la possibilità di controllare SEO l'ottimizzazione, solo singole parole ed estratte in ordine di pertinenza.

Passaggio 3: fare clic su "Avanti" per generare le parole chiave

Dopo aver perfezionato i tuoi obiettivi ed effettuato le selezioni desiderate, fai clic su Avanti (o un pulsante simile) per iniziare l'estrazione delle parole chiave. Eskritor AI elaborerà il testo, applicando metodi NLP come l'analisi della frequenza dei termini, la TF-IDFe l'analisi semantica (a seconda dei casi) per identificare le parole chiave più pertinenti.

Passaggio 4: esamina le parole chiave estratte

Eskritor presenterà un elenco (o una gerarchia) di parole chiave in base ai criteri selezionati. La visualizzazione potrebbe includere:

- Elenco di parole chiave : Organizzato per pertinenza, frequenza o in un formato gerarchico.

Suggerimento: fai attenzione alle parole chiave che potrebbero richiedere l'unione (ad esempio, forme singolari o plurali) o la rimozione (ad esempio, termini eccessivamente generici).

Passaggio 5: esportare o applicare i risultati

Infine, esporta l'elenco di parole chiave o incorporalo direttamente nel tuo flusso di lavoro:

- Opzioni di esportazione : Scarica in PDF, docx o HTML.

- Casi d'uso : Integrazione in strumenti SEO , documenti di pianificazione dei contenuti, schemi di ricerca o dashboard di marketing.

Suggerimenti per una generazione efficace di parole chiave

Garantire che l'estrazione delle parole chiave sia accurata e allineata con i tuoi obiettivi richiede una strategia. Di seguito sono riportate alcune best practice da considerare.

1 Pulisci e pre-elabora il testo

Rimuovi le parole non significative, i caratteri speciali e i dati irrilevanti prima dell'analisi per evitare confusione. Strumenti come NLTK (Python) o alcuni editor di testo possono automatizzare questa fase di pre-elaborazione.

2 Frequenza e pertinenza dell'equilibrio

Una parola chiave non riguarda solo il numero di volte in cui appare, ma anche l'importanza contestuale. Combina le metriche di frequenza con l'analisi semantica per trovare il giusto equilibrio.

3 Usa un mix di tecniche

Sfrutta più approcci,TF-IDF, l'analisi semantica o il riconoscimento di entità denominate, per acquisire una gamma più completa di parole chiave pertinenti e ridurre al minimo i punti ciechi.

4 Testa e perfeziona continuamente

Le tendenze delle parole chiave possono cambiare nel tempo, soprattutto nei settori in rapida evoluzione. Aggiorna regolarmente le parole chiave in base a nuovi dati, metriche di rendimento o esigenze del pubblico in evoluzione.

Conclusione: semplifica la generazione di parole chiave con AI

La generazione di parole chiave efficaci è una parte fondamentale delle moderne strategie di contenuto, dei flussi di lavoro di ricerca e delle attività di analisi dei dati. AI e strumenti basati su NLPcome Eskritor hanno reso più semplice che mai l'estrazione, il perfezionamento e l'esportazione di parole chiave di alto valore in una frazione del tempo necessario manualmente.

Combinando più tecniche,TF-IDF, l'analisi semantica, la modellazione degli argomenti e altro ancora, ottieni una comprensione completa di ciò che conta veramente nel tuo testo. Queste informazioni alimentano risultati SEO migliori, ricerche più mirate e materiali di marketing accattivanti. In breve, l'estrazione di parole chiave basata su AInon è più facoltativa; È una necessità per i professionisti che apprezzano l'efficienza, la precisione e il processo decisionale basato sui dati.

Dubai, Emirati Arabi Uniti

Dubai, Emirati Arabi Uniti