Dalam lanskap digital saat ini, kemampuan untuk menghasilkan kata kunci dari teks sangat penting untuk SEO, pembuatan konten, dan penelitian akademis. Mengidentifikasi istilah dan frasa yang paling mewakili konten Anda dapat meningkatkan peringkat mesin pencari, merampingkan upaya penelitian, dan memandu strategi konten yang efektif. Kemajuan modern dalam pemrosesan bahasa alami untuk ekstraksi kata kunci membuat proses ini lebih sederhana dan lebih akurat dari sebelumnya, dengan alat seperti Eskritor menonjol sebagai contoh utama inovasi.

Dalam panduan ini, kita akan mengeksplorasi pentingnya analisis teks untuk pembuatan kata kunci, mempelajari berbagai teknik—termasuk analisis frekuensi istilah untuk kata kunci dan menggunakan TF-IDF untuk ekstraksi kata kunci, dan membahas analisis semantik untuk menghasilkan kata kunci dalam konteks. Kami juga akan menyoroti alat terbaik untuk menghasilkan kata kunci dari teks dan memberikan tutorial langkah demi langkah untuk pembuatan kata kunci.

Mengapa Menghasilkan Kata Kunci dari Teks?

Ekstraksi kata kunci mendukung berbagai tugas profesional—mulai dari meningkatkan peringkat situs web hingga mengkategorikan dokumen penelitian. Di bawah ini adalah beberapa alasan utama mengapa proses ini sangat penting untuk konten modern dan strategi data.

1 Optimalkan Konten untuk SEO

Kata kunci membentuk tulang punggung dari setiap strategi optimasi mesin pencari yang efektif. Dengan mengidentifikasi istilah yang paling relevan yang digunakan oleh audiens target Anda, Anda dapat mengoptimalkan postingan blog, halaman arahan, dan konten online lainnya untuk mendapatkan peringkat yang lebih tinggi dalam hasil pencarian. Ini tidak hanya meningkatkan lalu lintas tetapi juga meningkatkan keterlibatan pengguna dengan menyelaraskan konten Anda dengan maksud pembaca.

2 Meningkatkan Efisiensi Penelitian

Bagi mahasiswa, peneliti, dan analis data, ekstraksi kata kunci dapat secara signifikan mengurangi waktu yang dihabiskan untuk menyaring dokumen besar atau makalah akademik. Dengan menyoroti ide dan terminologi utama, Anda dapat dengan cepat mengkategorikan temuan, menemukan referensi penting, dan bahkan melacak tren di berbagai penelitian. Alat seperti Google Scholar membantu lebih lanjut dalam menemukan topik dan artikel penelitian terkait.

3 Meningkatkan Strategi Konten

Memahami kata kunci mana yang sesuai dengan audiens Anda—baik itu kata kunci ekor panjang untuk industri khusus atau istilah luas dengan volume pencarian tinggi—membantu Anda merencanakan kalender konten dengan lebih efektif. Ini memastikan setiap karya yang Anda hasilkan berbicara langsung dengan apa yang dicari pembaca atau pelanggan Anda, yang pada akhirnya meningkatkan konversi dan kepuasan pengguna.

4 Otomatiskan Proses Manual

Lewatlah sudah hari-hari ketika tim harus membaca sekilas halaman dan halaman teks secara manual untuk mengidentifikasi tema dan frasa yang berulang. Alat ekstraksi kata kunci modern menghemat waktu dan mengurangi kesalahan manusia dengan mengotomatiskan seluruh proses, memungkinkan Anda untuk fokus pada tugas tingkat tinggi seperti strategi, analisis, dan eksekusi.

5 Hasil Lebih Cepat

Memproses teks dalam jumlah besar secara manual tidak praktis. Solusi AI seperti Eskritor dapat menganalisis ratusan halaman hanya dalam hitungan menit, memungkinkan Anda melakukan iterasi dengan cepat dan membuat keputusan berdasarkan data lebih cepat.

Teknik Umum untuk Menghasilkan Kata Kunci dari Teks

Teknik yang berbeda memenuhi berbagai kebutuhan analitis, apakah Anda menginginkan hitungan frekuensi sederhana atau pemahaman semantik yang lebih dalam. Mari kita jelajahi metode yang paling banyak digunakan dan bagaimana metode tersebut membantu mengekstrak kata kunci yang bermakna.

1 Analisis Frekuensi Istilah

Metode dasar, Frekuensi Istilah (TF), mengidentifikasi kata atau frasa yang paling umum digunakan dalam teks. Meskipun pendekatan ini dapat memunculkan kata kunci yang jelas, pendekatan ini tidak memperhitungkan keunikan atau kekhususan istilah tersebut di beberapa dokumen.

2 TF-IDF (Frekuensi Istilah–Frekuensi Dokumen Terbalik)

TF-IDF menyempurnakan analisis frekuensi istilah dasar dengan memperhitungkan seberapa penting suatu istilah di sekumpulan dokumen. Kata-kata yang sering muncul dalam satu dokumen tetapi jarang di dokumen lain menerima skor yang lebih tinggi, membuat teknik ini sangat baik untuk menentukan kata kunci yang lebih khusus atau spesifik konteks.

3 Analisis Semantik

Analisis semantik mengidentifikasi frasa yang relevan secara kontekstual dengan memeriksa hubungan antara kata-kata daripada hanya yang sering digunakan. Ini sangat berguna jika Anda ingin menangkap sinonim, istilah terkait, atau ide yang terkait secara tematik daripada kata-kata berulang yang mungkin tidak memiliki makna.

4 Pendekatan Berbasis NLP

Teknik NLP tingkat lanjut seperti Pengenalan Entitas Bernama (NER) dan pemodelan topik melampaui jumlah kata sederhana. NER mengidentifikasi orang, tempat, organisasi, dan entitas spesifik lainnya, yang dapat menjadi kata kunci penting dalam jurnalisme atau analisis bisnis. Pemodelan topik mengungkapkan tema yang lebih luas dalam teks, sehingga lebih mudah untuk mengkategorikan data dalam jumlah besar.

Alat Terbaik untuk Menghasilkan Kata Kunci dari Teks

Ekstraksi kata kunci dapat dilakukan dengan menggunakan berbagai alat dan platform khusus. Di bawah ini adalah beberapa opsi terkemuka, masing-masing cocok untuk kebutuhan pengguna yang berbeda—mulai dari pengoptimalan SEO hingga analisis data yang komprehensif.

1 Eskritor

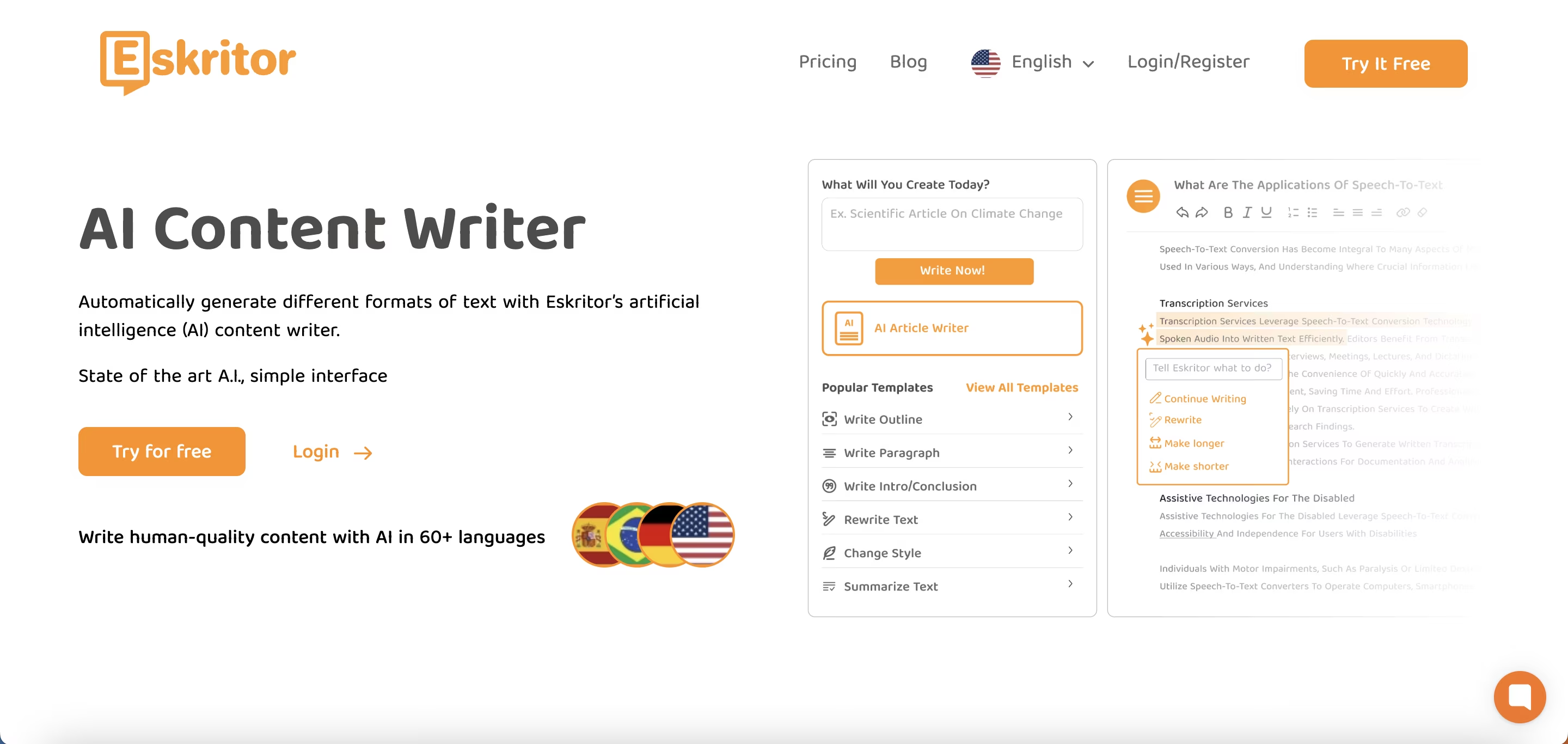

Eskritor adalah platform penulisan canggih yang digerakkan oleh AIyang dirancang untuk menyederhanakan dan meningkatkan proses ekstraksi kata kunci bagi pengguna di berbagai bidang—apakah Anda mengoptimalkan SEO, mengembangkan kampanye pemasaran, atau melakukan penelitian akademis. Dengan memanfaatkan algoritme pemrosesan bahasa alami (NLP) yang kuat, Eskritor secara otomatis mengidentifikasi istilah dan frasa penting dalam teks Anda, menyoroti kata kunci berbasis frekuensi dan wawasan berbasis konteks.

Fitur utama

- Alat tulis bertenaga AIyang disesuaikan untuk penggunaan SEO, pemasaran, dan akademik

- Antarmuka sederhana untuk menganalisis teks dan menghasilkan kata kunci yang dapat ditindaklanjuti

Mengapa Ini Menonjol

- Mempercepat analisis kata kunci dengan algoritme NLP canggih

- Menawarkan opsi yang dapat disesuaikan untuk penyaringan frekuensi dan analisis semantik

2 Google Keyword Planner

Bahan pokok bagi pemasar digital, Google Keyword Planner menyelaraskan kata kunci yang disarankan dengan data volume pencarian. Meskipun terutama untuk kampanye PPC, ini juga membantu pembuat konten menyempurnakan topik mereka berdasarkan kueri pengguna nyata. Integrasi dengan Google Ads memberikan wawasan langsung tentang seberapa sering istilah tertentu dicari, memberi Anda awal yang baik dalam membuat konten yang sesuai dengan maksud pengguna.

3 MonkeyLearn

Ideal untuk analisis teks, MonkeyLearn menyediakan ekstraksi kata kunci menggunakan API NLP yang kuat. Ini unggul dalam mengkategorikan umpan balik, ulasan, atau obrolan media sosial, sehingga berharga bagi merek yang berfokus pada analisis sentimen dan tren. Dasbor MonkeyLearnmencakup opsi untuk pemrosesan waktu nyata, yang berarti Anda dapat mengaturnya untuk terus menganalisis data yang masuk—sempurna untuk tim pemasaran yang serba cepat atau operasi dukungan pelanggan.

4 Pustaka R dan Python

Untuk pengguna yang nyaman dengan pemrograman, pustaka seperti Tidytext (R) dan spaCy (Python) memungkinkan ekstraksi kata kunci yang mendalam dan dapat disesuaikan. Anda dapat menerapkan TF-IDF, pemodelan topik, dan analisis sentimen untuk proyek yang sangat terspesialisasi atau berskala besar.

Pustaka ini menawarkan fleksibilitas untuk menyempurnakan parameter atau berintegrasi dengan kerangka kerja pembelajaran mesin, menjadikannya ideal untuk ilmuwan data atau peneliti yang membutuhkan alur analisis teks yang sepenuhnya disesuaikan.

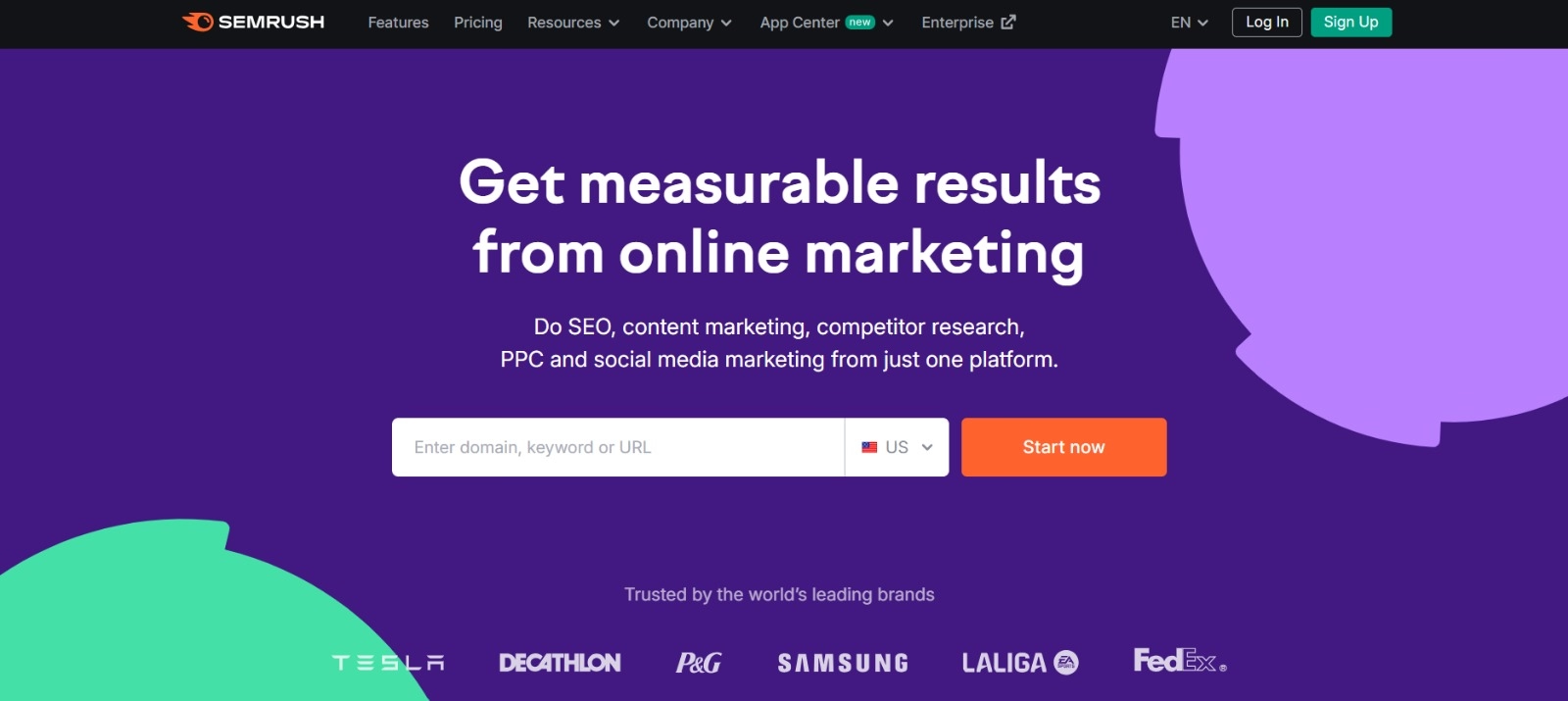

5 Semrush

Pilihan populer di kalangan profesional SEO , Semrush menggabungkan penelitian kata kunci dengan analisis kompetitif. Fokusnya pada volume pencarian, skor kesulitan, dan strategi pesaing membantu menyempurnakan rencana konten untuk visibilitas maksimum.

Di luar saran kata kunci, Semrush memberikan wawasan tingkat domain, seperti profil backlink dan analitik lalu lintas, memungkinkan pendekatan holistik untuk SEO dan taktik pemasaran digital.

Panduan Langkah demi Langkah untuk Menghasilkan Kata Kunci dengan Eskritor

Dalam hal ekstraksi kata kunci yang mudah namun kuat, Eskritor menawarkan keseimbangan yang sangat baik antara kegunaan dan fitur NLP canggih. Berikut cara memanfaatkan platformnya sebaik-baiknya.

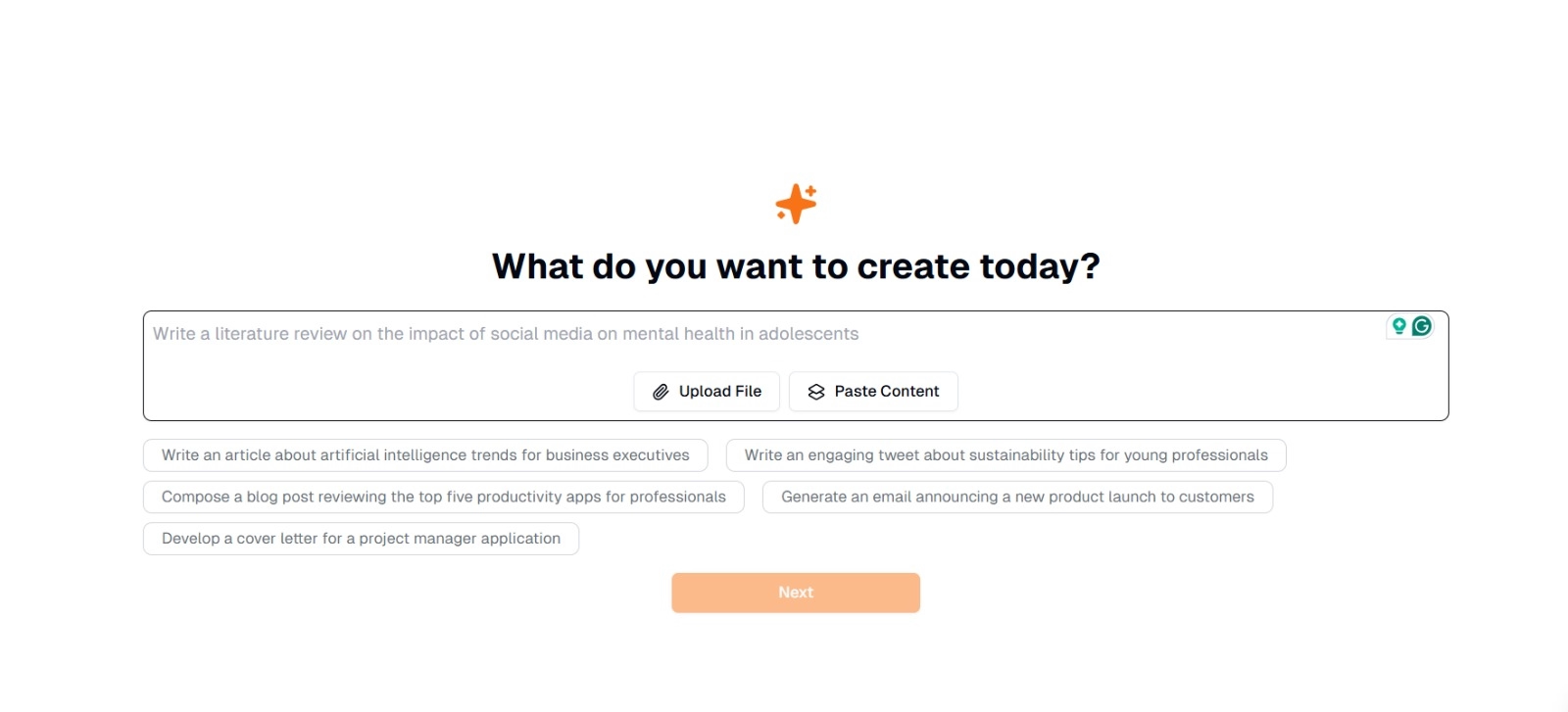

Langkah 1: Masukkan atau Unggah Teks Anda

Pada antarmuka utama Eskritor, Anda akan melihat perintah yang menanyakan, "Apa yang ingin Anda buat hari ini?" Di sini, Anda memiliki dua opsi:

- Tempel Konten : Salin dan tempel teks Anda langsung ke dalam kotak teks yang diberikan.

- Unggah File : Pilih dokumen (misalnya, .docx, .pdf, .txt) yang berisi teks yang ingin Anda analisis.

Tip : Anda juga dapat memilih dari petunjuk yang disarankan (misalnya, "Tulis artikel tentang tren kecerdasan buatan...") jika Anda berencana untuk membuat atau mengerjakan ulang teks sebelum ekstraksi.

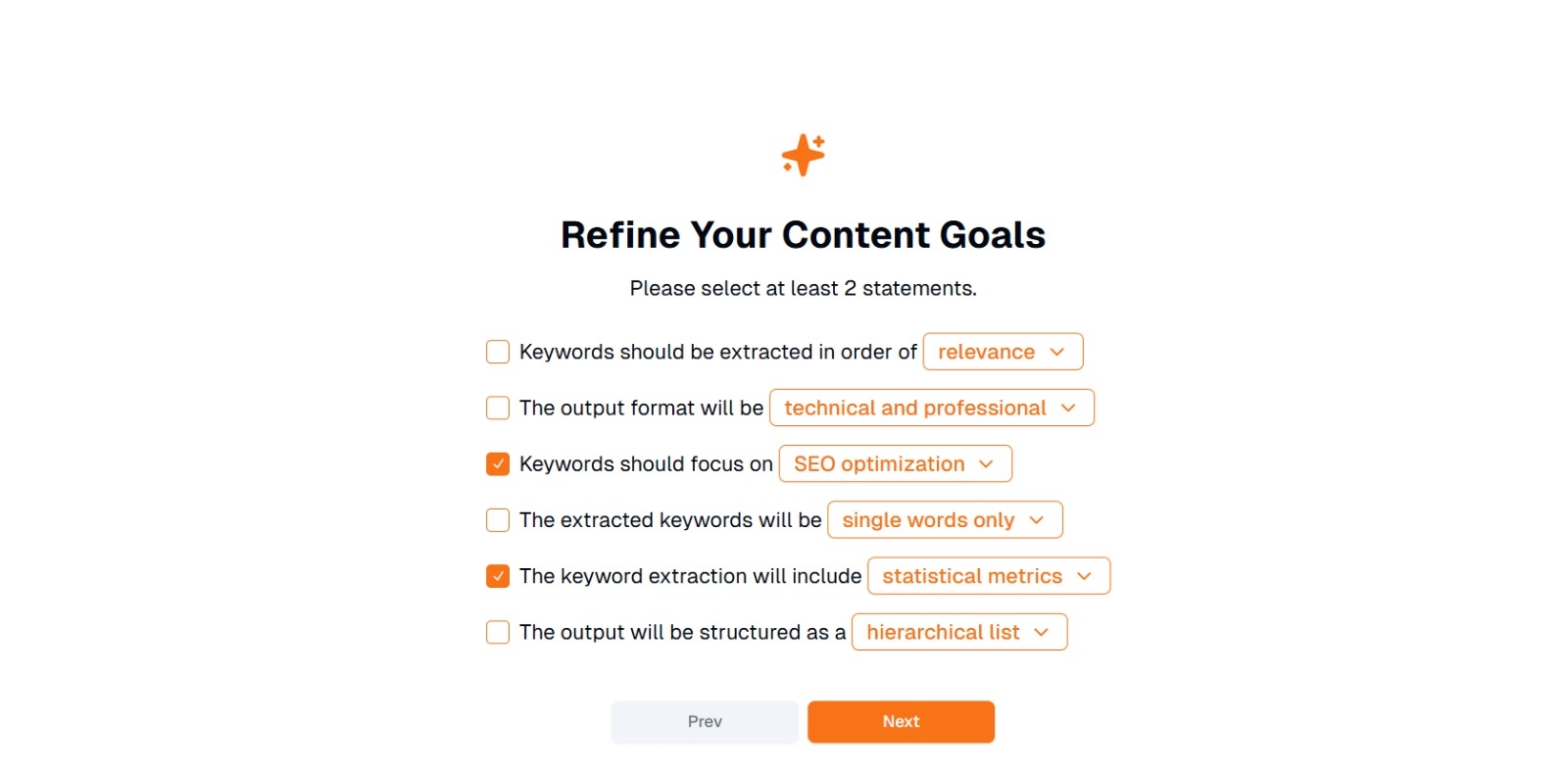

Langkah 2: Persempit Tujuan Konten Anda

Anda akan diminta dengan " Apa yang ingin Anda lakukan dengan konten ini? " dan diminta untuk memilih setidaknya 2 pernyataan . Selain itu, Anda dapat menulis apa yang ingin Anda lakukan untuk mengobrol. Opsi mungkin termasuk:

- Kata kunci harus diekstraksi dalam urutan: (misalnya, relevansi , frekuensi, abjad, dll.)

- Format keluaran adalah: (misalnya, teknis dan profesional , kasual dan ramah )

- Kata kunci harus fokus pada: (misalnya, pengoptimalanSEO, penelitian akademis, sudut pemasaran)

- Kata kunci yang diekstraksi adalah: (misalnya, hanya satu kata , frasa multi-kata )

- Ekstraksi kata kunci akan mencakup: (misalnya, metrik statistik , pengelompokan semantik )

- Keluaran akan disusun sebagai: (misalnya, daftar hierarkis , poin-poin sederhana )

Tip : Pilih pernyataan yang paling sesuai dengan kebutuhan proyek Anda. Misalnya, jika Anda mengoptimalkan posting blog untuk mesin pencari, pertimbangkan untuk memeriksa pengoptimalanSEO, hanya satu kata, dan diekstrak dalam urutan relevansi.

Langkah 3: Klik "Berikutnya" untuk Menghasilkan Kata Kunci

Setelah menyempurnakan tujuan Anda dan membuat pilihan yang diinginkan, klik Berikutnya (atau tombol serupa) untuk memulai ekstraksi kata kunci. AI Eskritorakan memproses teks, menerapkan metode NLP seperti analisis frekuensi istilah, TF-IDF, dan analisis semantik (sebagaimana berlaku) untuk mengidentifikasi kata kunci yang paling relevan.

Langkah 4: Tinjau Kata Kunci yang Diekstraksi

Eskritor akan menyajikan daftar (atau hierarki) kata kunci berdasarkan kriteria yang Anda pilih. Tampilan mungkin mencakup:

- Daftar Kata Kunci : Disusun berdasarkan relevansi, frekuensi, atau dalam format hierarkis.

Tip : Perhatikan kata kunci yang mungkin perlu digabungkan (misalnya, bentuk tunggal vs. bentuk jamak) atau penghapusan (misalnya, istilah yang terlalu umum).

Langkah 5: Ekspor atau Terapkan Hasilnya

Terakhir, ekspor daftar kata kunci atau gabungkan langsung ke dalam alur kerja Anda:

- Opsi Ekspor : Unduh di PDF, docx, atau HTML.

- Kasus Penggunaan : Integrasikan ke dalam alat SEO , dokumen perencanaan konten, garis besar penelitian, atau dasbor pemasaran.

Tips untuk Pembuatan Kata Kunci yang Efektif

Memastikan bahwa ekstraksi kata kunci Anda akurat dan selaras dengan tujuan Anda membutuhkan strategi. Berikut adalah beberapa praktik terbaik untuk dipertimbangkan.

1 Bersihkan dan Praproses Teks

Hapus kata berhenti, karakter khusus, dan data yang tidak relevan sebelum analisis untuk menghindari kekacauan. Alat seperti NLTK (Python) atau editor teks tertentu dapat mengotomatiskan langkah prapemrosesan ini.

2 Frekuensi dan Relevansi Keseimbangan

Kata kunci bukan hanya tentang berapa kali muncul—ini juga tentang kepentingan kontekstual. Gabungkan metrik frekuensi dengan analisis semantik untuk mencapai keseimbangan yang tepat.

3 Gunakan Campuran Teknik

Manfaatkan beberapa pendekatan—TF-IDF, analisis semantik, atau pengenalan entitas bernama—untuk menangkap berbagai kata kunci yang relevan dan meminimalkan titik buta.

4 Terus Menguji dan Menyempurnakan

Tren kata kunci dapat berubah dari waktu ke waktu, terutama di industri yang bergerak cepat. Perbarui kata kunci Anda secara berkala berdasarkan data baru, metrik kinerja, atau kebutuhan audiens yang terus berkembang.

Kesimpulan: Sederhanakan Pembuatan Kata Kunci dengan AI

Menghasilkan kata kunci yang efektif adalah bagian penting dari strategi konten modern, alur kerja penelitian, dan tugas analisis data. Alat yang digerakkan oleh AI dan NLPseperti Eskritor telah membuatnya lebih mudah dari sebelumnya untuk mengekstrak, menyempurnakan, dan mengekspor kata kunci bernilai tinggi dalam waktu yang lebih singkat dari waktu yang dibutuhkan secara manual.

Dengan menggabungkan beberapa teknik—TF-IDF, analisis semantik, pemodelan topik, dan banyak lagi—Anda mendapatkan pemahaman yang komprehensif tentang apa yang benar-benar penting dalam teks Anda. Wawasan ini memicu hasil SEO yang lebih baik, penelitian yang lebih terfokus, dan materi pemasaran yang menarik. Singkatnya, ekstraksi kata kunci berbasis AItidak lagi opsional; Ini adalah kebutuhan bagi para profesional yang menghargai efisiensi, presisi, dan pengambilan keputusan berbasis data.

Dubai, UEA

Dubai, UEA