A mai digitális környezetben a kulcsszavak szövegből történő generálásának képessége elengedhetetlen a SEO, a tartalomkészítéshez és a tudományos kutatáshoz. A tartalmat legjobban reprezentáló kifejezések és kifejezések azonosítása javíthatja a keresőmotorok rangsorolását, egyszerűsítheti a kutatási erőfeszítéseket, és hatékony tartalmi stratégiákat irányíthat. A kulcsszavak kinyerésére szolgáló természetes nyelvi feldolgozás modern fejlődése minden eddiginél egyszerűbbé és pontosabbá teszi ezt a folyamatot, és az olyan eszközök, mint a Eskritor , az innováció kiváló példái.

Ebben az útmutatóban megvizsgáljuk a szövegelemzés fontosságát a kulcsszavak generálása szempontjából, elmélyülünk a különböző technikákban – beleértve a kulcsszavak kifejezésgyakoriság-elemzését és a TF-IDF kulcsszavak kinyerésére való felhasználását, valamint megvitatjuk a szemantikai elemzést a kulcsszavak kontextusban történő generálásához. Kiemeljük a kulcsszavak szövegből történő generálásának legjobb eszközeit is, és lépésről lépésre bemutatjuk a kulcsszavak generálását.

Miért kell kulcsszavakat generálni szövegből?

A kulcsszavak kinyerése számos szakmai feladatot támaszt alá – a webhelyek rangsorolásának javításától a kutatási dokumentumok kategorizálásáig. Az alábbiakban felsorolunk néhány alapvető okot, amiért ez a folyamat létfontosságú a modern tartalom- és adatstratégiák szempontjából.

1 Tartalom optimalizálása SEO

A kulcsszavak minden hatékony keresőoptimalizálási stratégia gerincét képezik. A célközönség által használt legrelevánsabb kifejezések azonosításával optimalizálhatja a blogbejegyzéseket, a céloldalakat és más online tartalmakat, hogy magasabb helyezést érjenek el a keresési eredmények között. Ez nemcsak a forgalmat növeli, hanem a felhasználói elkötelezettséget is növeli azáltal, hogy a tartalmat az olvasói szándékhoz igazítja.

2 A kutatás hatékonyságának növelése

A diákok, kutatók és adatelemzők számára a kulcsszavak kinyerése jelentősen csökkentheti a nagy dokumentumok vagy tudományos dolgozatok átvizsgálására fordított időt. A fő gondolatok és terminológia kiemelésével gyorsan kategorizálhatja az eredményeket, megtalálhatja a fontos hivatkozásokat, és akár több tanulmány trendjeit is nyomon követheti. Az olyan eszközök, mint a Google Scholar további segítséget nyújtanak a kapcsolódó kutatási témák és cikkek felfedezésében.

3 Javítsa a tartalmi stratégiát

Ha megérti, hogy mely kulcsszavak rezonálnak a közönségre – legyenek azok a réságazatok hosszú kulcsszavai vagy nagy keresési volumenű tág kifejezések –, hatékonyabban tervezheti meg tartalmi naptárát. Ez biztosítja, hogy minden egyes elkészített darab közvetlenül beszéljen arról, amit olvasói vagy ügyfelei keresnek, végső soron növelve a konverziókat és a felhasználói elégedettséget.

4 Automatizálja a manuális folyamatokat

Elmúltak azok az idők, amikor a csapatoknak manuálisan kellett átfutniuk a szöveg oldalait az ismétlődő témák és kifejezések azonosítására. A modern kulcsszókitermelő eszközök időt takarítanak meg és csökkentik az emberi hibákat azáltal, hogy automatizálják a teljes folyamatot, lehetővé téve, hogy olyan magasabb szintű feladatokra összpontosítson, mint a stratégia, az elemzés és a végrehajtás.

5 Gyorsabb eredmények

Nagy mennyiségű szöveg manuális feldolgozása nehézkes. Egy olyan AI megoldás, mint a Eskritor , percek alatt több száz oldalt képes elemezni, lehetővé téve a gyors iterációt és az adatvezérelt döntések gyorsabb meghozatalát.

Gyakori technikák kulcsszavak szövegből történő generálására

A különböző technikák különböző analitikai igényeket elégítenek ki, akár egyszerű gyakoriságszámlálást, akár mélyebb szemantikai megértést szeretne. Vizsgáljuk meg a legszélesebb körben használt módszereket, és azt, hogy ezek hogyan segítenek értelmes kulcsszavak kinyerésében.

1 Kifejezési gyakoriság elemzése

Az alapvető módszer, a kifejezések gyakorisága (TF) azonosítja a szövegen belül leggyakrabban használt szavakat vagy kifejezéseket. Bár ez a megközelítés nyilvánvaló kulcsszavakat jeleníthet meg, nem veszi figyelembe ezeknek a kifejezéseknek az egyediségét vagy sajátosságát több dokumentumban.

2 TF-IDF (kifejezés gyakorisága – fordított dokumentum gyakorisága)

TF-IDF finomítja az alapvető kifejezések gyakoriságának elemzését azáltal, hogy figyelembe veszi, hogy egy kifejezés mennyire fontos egy dokumentumkészletben. Azok a szavak, amelyek gyakran előfordulnak az egyik dokumentumban, de ritkán másokban, magasabb pontszámot kapnak, így ez a technika kiválóan alkalmas speciálisabb vagy kontextusfüggőbb kulcsszavak meghatározására.

3 Szemantikai elemzés

A szemantikai elemzés a kontextus szempontjából releváns kifejezéseket a szavak közötti kapcsolatok vizsgálatával azonosítja, nem csak a gyakran használt szavak között. Ez különösen akkor hasznos, ha szinonimákat, kapcsolódó kifejezéseket vagy tematikusan kapcsolódó ötleteket szeretne rögzíteni, nem pedig ismétlődő szavakat, amelyeknek esetleg nincs jelentősége.

4 NLPalapú megközelítések

Az olyan fejlett NLP technikák, mint a nevesített entitásfelismerés (NER) és a témamodellezés túlmutatnak az egyszerű szószámon. A NER azonosítja azokat az embereket, helyeket, szervezeteket és egyéb konkrét entitásokat, amelyek kulcsfontosságú kulcsszavak lehetnek az újságírásban vagy az üzleti elemzésben. A témamodellezés szélesebb témákat tár fel a szövegen belül, megkönnyítve a nagy mennyiségű adat kategorizálását.

A legjobb eszközök kulcsszavak szövegből történő generálásához

A kulcsszavak kinyerése számos speciális eszközzel és platformmal történhet. Az alábbiakban áttekintünk néhány vezető lehetőséget, amelyek mindegyike megfelel a különböző felhasználói követelményeknek – a SEO optimalizálástól az átfogó adatelemzésig.

1 Eskritor

Eskritor egy fejlett, AIvezérelt írási platform, amelynek célja, hogy leegyszerűsítse és javítsa a kulcsszavak kinyerésének folyamatát a felhasználók számára a különböző területeken – akár SEOoptimalizál, akár marketingkampányokat fejleszt, akár tudományos kutatásokat végez. A hatékony természetes nyelvi feldolgozási (NLP) algoritmusok kihasználásával Eskritor automatikusan azonosítja a szöveg kulcsfontosságú kifejezéseit és kifejezéseit, kiemelve mind a frekvenciaalapú kulcsszavakat, mind a kontextusvezérelt betekintést.

Főbb jellemzők

- AI-alapú íróeszköz, amely SEO, marketing és tudományos használatra van szabva

- Egyszerű felület a szöveg elemzéséhez és a használható kulcsszavak generálásához

Miért tűnik ki?

- Felgyorsítja a kulcsszóelemzést fejlett NLP algoritmusokkal

- Testreszabható lehetőségeket kínál a frekvenciaszűréshez és a szemantikai elemzéshez

2 Google Keyword Planner

A digitális marketingszakemberek alappillére, Google Keyword Planner összehangolja a javasolt kulcsszavakat a keresési mennyiségi adatokkal. Bár elsősorban PPC-kampányokhoz készült, segít a tartalomkészítőknek is finomítani témáikat a valódi felhasználói lekérdezések alapján. A Google Ads -vel való integráció közvetlen betekintést nyújt abba, hogy milyen gyakran keresnek bizonyos kifejezésekre, így előnyt jelent a felhasználói szándéknak megfelelő tartalom létrehozásában.

3 MonkeyLearn

Ideális szövegelemzéshez, MonkeyLearn kulcsszavak kinyerését biztosítja hatékony NLP API-k segítségével. Kiválóan kategorizálja a visszajelzéseket, véleményeket vagy a közösségi médiában zajló csevegéseket, így értékes a hangulat- és trendelemzésre összpontosító márkák számára. A MonkeyLearnirányítópultja valós idejű feldolgozási lehetőségeket tartalmaz, ami azt jelenti, hogy beállíthatja a bejövő adatok folyamatos elemzésére – tökéletes a gyors tempójú marketingcsapatok vagy ügyfélszolgálati műveletek számára.

4 R és Python könyvtárak

A programozásban jártas felhasználók számára az olyan könyvtárak, mint a Tidytext (R) és a spaCy (Python) lehetővé teszik a mélyreható, testreszabható kulcsszavak kinyerését. Megvalósíthatja TF-IDF, témakörmodellezést és hangulatelemzést magas szintű vagy nagy léptékű projektekhez.

Ezek a kódtárak rugalmasságot kínálnak a paraméterek finomhangolásához vagy a gépi tanulási keretrendszerekkel való integrációhoz, így ideálisak az adattudósok vagy a teljesen testreszabott szövegelemzési folyamatot igénylő kutatók számára.

5 Semrush

A SEO szakemberek körében népszerű választás, Semrush a kulcsszókutatást a versenyelemzéssel ötvözi. A keresési mennyiségre, a nehézségi pontszámokra és a versenytársak stratégiáira való összpontosítása segít finomítani a tartalmi terveket a maximális láthatóság érdekében.

A kulcsszójavaslatokon túl a Semrush domainszintű betekintést nyújt, például backlink-profilokat és forgalmi elemzéseket, lehetővé téve a SEO és a digitális marketing taktikák holisztikus megközelítését.

Lépésről lépésre útmutató a kulcsszavak generálásához Eskritor

Ha egyszerű, de hatékony kulcsszókinyerésről van szó, a Eskritor kiváló egyensúlyt kínál a használhatóság és a fejlett NLP funkciók között. Így hozhatja ki a legtöbbet a platformjából.

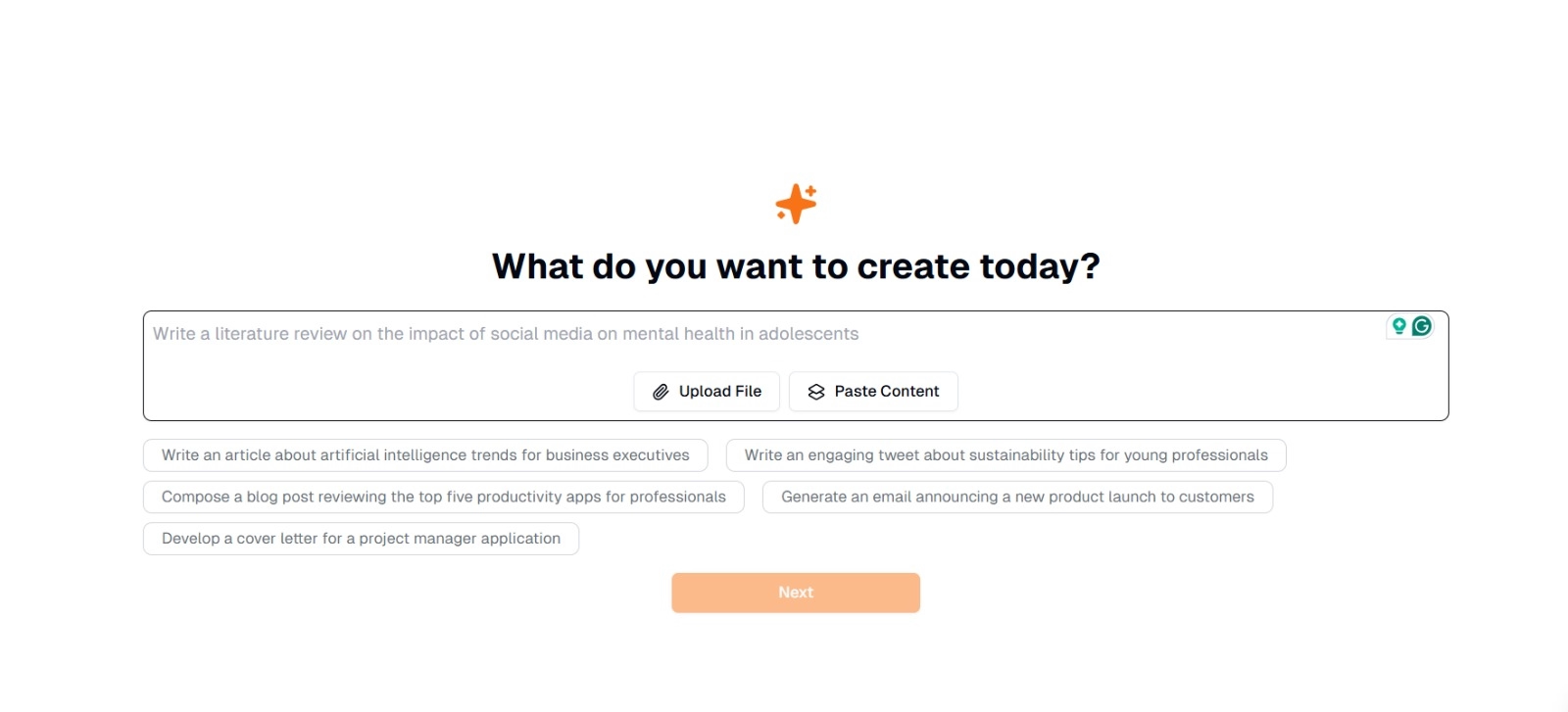

1. lépés: Írja be vagy töltse fel a szöveget

A Eskritorfő felületén megjelenik egy üzenet, amely megkérdezi: "Mit szeretnél ma létrehozni?" Itt két lehetőség közül választhat:

- Tartalom beillesztése : Másolja és illessze be a szöveget közvetlenül a megadott szövegmezőbe.

- Fájl feltöltése : Válasszon ki egy dokumentumot (pl. .docx, .pdf, .txt), amely tartalmazza az elemezni kívánt szöveget.

Tipp: A javasolt promptok közül is választhat (pl. "Írjon cikket a mesterséges intelligencia trendjeiről..."), ha szöveget szeretne generálni vagy átdolgozni a kinyerés előtt.

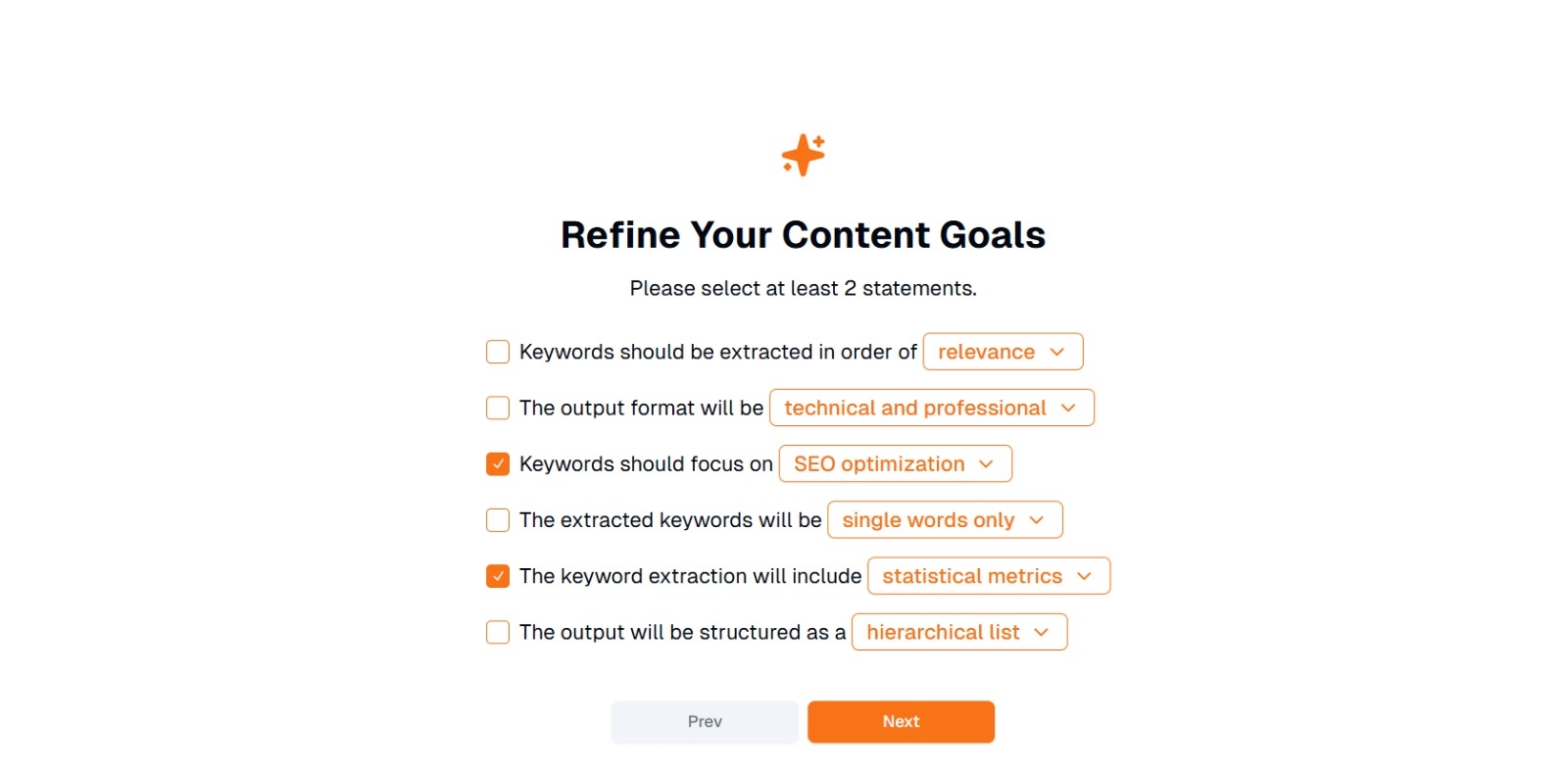

2. lépés: Finomítsa tartalmi céljait

A rendszer megkérdezi: " Mit szeretne kezdeni ezzel a tartalommal? " és legalább 2 állítás kiválasztását kérte . Azt is megírhatja, hogy mit szeretne tenni a csevegéshez. A lehetőségek a következők lehetnek:

- A kulcsszavakat a következő sorrendben kell kinyerni: (pl. relevancia , gyakoriság , ábécé sorrend stb.)

- A kimeneti formátum a következő lesz: (pl. technikai és professzionális , alkalmi és barátságos )

- A kulcsszavaknak a következőkre kell összpontosítaniuk: (pl. SEO optimalizálás, tudományos kutatás, marketing szempontok)

- A kivont kulcsszavak a következők lesznek: (pl. csak egy szó, többszavas kifejezések )

- A kulcsszó kinyerése a következőket tartalmazza: (pl. statisztikai mutatók, szemantikai csoportosítás)

- A kimenet a következőképpen lesz felépítve: (pl. hierarchikus lista, egyszerű felsoroláspontok )

Tipp: Válassza ki azokat az állításokat, amelyek a legjobban megfelelnek a projekt igényeinek. Például, ha egy blogbejegyzést keresőmotorok számára optimalizál, fontolja meg a SEO optimalizálás ellenőrzését, csak egyetlen szót, és relevancia sorrendjében kivonva.

3. lépés: Kattintson a "Tovább" gombra a kulcsszavak létrehozásához

A célok finomítása és a kívánt kiválasztás után kattintson a Tovább gombra (vagy egy hasonló gombra) a kulcsszókinyerés megkezdéséhez. Eskritor AI feldolgozza a szöveget, olyan módszereket NLP alkalmazva, mint a kifejezésgyakoriság-elemzés, a TF-IDFés a szemantikai elemzés (adott esetben) a legrelevánsabb kulcsszavak azonosítására.

4. lépés: Tekintse át a kivont kulcsszavakat

Eskritor kulcsszavak listáját (vagy hierarchiáját) jeleníti meg a kiválasztott kritériumok alapján. A kijelző a következőket tartalmazhatja:

- Kulcsszólista : Relevancia, gyakoriság vagy hierarchikus formátumban rendezve.

Tipp: Figyeljen azokra a kulcsszavakra, amelyeket össze kell vonni (pl. egyes vagy többes szám) vagy el kell távolítani (pl. túlságosan általános kifejezések).

5. lépés: Az eredmények exportálása vagy alkalmazása

Végül exportálja a kulcsszólistát, vagy építse be közvetlenül a munkafolyamatba:

- Exportálási beállítások : Letöltés PDF, docx vagy HTMLformátumban.

- Felhasználási esetek : Integrálja SEO eszközökbe, tartalomtervezési dokumentumokba, kutatási vázlatokba vagy marketing irányítópultokba.

Tippek a hatékony kulcsszógeneráláshoz

Annak biztosítása, hogy a kulcsszavak kinyerése pontos és összhangban legyen a céljaival, stratégiát igényel. Íme néhány megfontolandó ajánlott eljárás.

1 A szöveg tisztítása és előfeldolgozása

Az elemzés előtt távolítsa el a leállító szavakat, a speciális karaktereket és az irreleváns adatokat a zsúfoltság elkerülése érdekében. Az olyan eszközök, mint a NLTK (Python) vagy bizonyos szövegszerkesztők automatizálhatják ezt az előfeldolgozási lépést.

2 Mérleg gyakorisága és relevanciája

A kulcsszó nem csak arról szól, hogy hányszor jelenik meg, hanem a kontextus fontosságáról is. A gyakorisági metrikák és a szemantikai elemzés kombinálásával megtalálhatja a megfelelő egyensúlyt.

3 Használjon különböző technikákat

Többféle megközelítést –TF-IDF, szemantikai elemzést vagy elnevezett entitásfelismerést – használhat a releváns kulcsszavak teljesebb skálájának rögzítéséhez és a vakfoltok minimalizálásához.

4 Folyamatos tesztelés és finomítás

A kulcsszótrendek idővel változhatnak, különösen a gyorsan változó iparágakban. Rendszeresen frissítse kulcsszavait az új adatok, teljesítménymutatók vagy a változó közönségigények alapján.

Következtetés: Egyszerűsítse a kulcsszógenerálást AI

A hatékony kulcsszavak generálása a modern tartalomstratégiák, kutatási munkafolyamatok és adatelemzési feladatok kulcsfontosságú része. Az olyan AI és NLPvezérelt eszközök, mint a Eskritor, minden eddiginél egyszerűbbé tették a nagy értékű kulcsszavak kinyerését, finomítását és exportálását a manuális idő töredéke alatt.

Több technika –TF-IDF, szemantikai elemzés, témamodellezés és egyebek – kombinálásával átfogó képet kaphat arról, hogy mi számít igazán a szövegben. Ez a betekintés jobb SEO eredményeket, koncentráltabb kutatást és vonzó marketinganyagokat eredményez. Röviden, AI-alapú kulcsszókinyerés már nem opcionális; Olyan szakemberek számára szükséges, akik értékelik a hatékonyságot, a pontosságot és az adatvezérelt döntéshozatalt.

Dubai, Egyesült Arab Emírségek

Dubai, Egyesült Arab Emírségek