Tänapäeva digitaalsel maastikul on oskus genereerida tekstist märksõnu SEO, sisu loomise ja akadeemiliste uuringute jaoks hädavajalik. Teie sisu kõige paremini esindavate terminite ja fraaside kindlakstegemine võib parandada otsingumootorite paremusjärjestust, lihtsustada uurimistegevust ja suunata tõhusaid sisustrateegiaid. Kaasaegsed edusammud loomuliku keele töötlemisel märksõnade ekstraheerimiseks muudavad selle protsessi lihtsamaks ja täpsemaks kui kunagi varem, kusjuures sellised tööriistad nagu Eskritor paistavad silma innovatsiooni peamiste näidetena.

Selles juhendis uurime tekstianalüüsi tähtsust märksõnade genereerimisel, süveneme erinevatesse tehnikatesse - sealhulgas märksõnade terminite sageduse analüüsi ja TF-IDF kasutamist märksõnade eraldamiseks ning arutame semantilist analüüsi märksõnade genereerimiseks kontekstis. Samuti toome välja parimad tööriistad märksõnade genereerimiseks tekstist ja anname samm-sammult õpetuse märksõnade genereerimiseks.

Miks genereerida märksõnu tekstist?

Märksõnade ekstraheerimine toetab mitmesuguseid ametialaseid ülesandeid – alates veebisaitide paremusjärjestuse parandamisest kuni uurimisdokumentide kategoriseerimiseni. Allpool on toodud mõned peamised põhjused, miks see protsess on tänapäevaste sisu- ja andmestrateegiate jaoks ülioluline.

1 Optimeerige sisu SEO jaoks

Märksõnad moodustavad iga tõhusa otsingumootori optimeerimise strateegia selgroo. Tuvastades kõige asjakohasemad terminid, mida teie sihtrühm kasutab, saate optimeerida blogipostitusi, sihtlehti ja muud veebisisu, et need oleksid otsingutulemustes kõrgemal kohal. See mitte ainult ei suurenda liiklust, vaid suurendab ka kasutajate kaasatust, viies teie sisu vastavusse lugeja kavatsustega.

2 Suurendage teadusuuringute tõhusust

Üliõpilaste, teadlaste ja andmeanalüütikute jaoks võib märksõnade ekstraheerimine oluliselt vähendada suurte dokumentide või akadeemiliste tööde sõelumisele kuluvat aega. Tuues esile peamised ideed ja terminoloogia, saate kiiresti kategoriseerida tulemusi, leida olulisi viiteid ja isegi jälgida suundumusi mitmes uuringus. Sellised tööriistad nagu Google Scholar aitavad veelgi avastada seotud uurimisteemasid ja artikleid.

3 Parandage sisustrateegiat

Kui mõistate, millised märksõnad teie sihtrühmale meeldivad - olgu need siis nišitööstuste pika sabaga märksõnad või suure otsingumahuga laiad terminid - aitab teil oma sisukalendrit tõhusamalt planeerida. See tagab, et iga teie toodetud teos räägib otseselt sellest, mida teie lugejad või kliendid otsivad, suurendades lõppkokkuvõttes konversioone ja kasutajate rahulolu.

4 Automatiseerige käsitsi protsessid

Möödas on ajad, mil meeskonnad pidid korduvate teemade ja fraaside tuvastamiseks käsitsi lehekülgi ja lehekülgi teksti sirvima. Kaasaegsed märksõnade ekstraheerimise tööriistad säästavad aega ja vähendavad inimlikke vigu, automatiseerides kogu protsessi, võimaldades teil keskenduda kõrgema taseme ülesannetele, nagu strateegia, analüüs ja elluviimine.

5 Kiiremad tulemused

Suurte tekstimahtude käsitsi töötlemine on tülikas. AI lahendus nagu Eskritor suudab analüüsida sadu lehekülgi vaid minutitega, võimaldades teil kiiresti itereerida ja teha andmepõhiseid otsuseid kiiremini.

Levinud tehnikad tekstist märksõnade genereerimiseks

Erinevad tehnikad rahuldavad erinevaid analüütilisi vajadusi, olenemata sellest, kas soovite lihtsat sageduste loendamist või sügavamat semantilist mõistmist. Uurime kõige laialdasemalt kasutatavaid meetodeid ja seda, kuidas need aitavad eraldada tähendusrikkaid märksõnu.

1 Tähtaja sageduse analüüs

Põhimeetod Term Frequency (TF) tuvastab tekstis kõige sagedamini kasutatavad sõnad või fraasid. Kuigi see lähenemisviis võib esile tuua ilmseid märksõnu, ei võta see arvesse nende terminite ainulaadsust ega spetsiifilisust mitmes dokumendis.

2 TF-IDF (termini sagedus – pöördvõrdeline dokumendi sagedus)

TF-IDF täpsustab põhilist terminite sageduse analüüsi, võttes arvesse, kui oluline on termin dokumentide kogumis. Sõnad, mis esinevad ühes dokumendis sageli, kuid teistes harva, saavad kõrgema hinde, mistõttu on see tehnika suurepärane spetsiifilisemate või kontekstispetsiifilisemate märksõnade kindlakstegemiseks.

3 Semantiline analüüs

Semantiline analüüs tuvastab kontekstuaalselt asjakohased fraasid, uurides pigem sõnade kui ainult sageli kasutatavate sõnade vahelisi seoseid. See on eriti kasulik, kui soovite jäädvustada sünonüüme, seotud termineid või temaatiliselt seotud ideid, mitte korduvaid sõnu, millel ei pruugi olla tähendust.

4 NLP-põhised lähenemisviisid

Täiustatud NLP tehnikad, nagu nimelise üksuse tuvastamine (NER) ja teemade modelleerimine, lähevad lihtsast sõnade arvust kaugemale. NER tuvastab inimesed, kohad, organisatsioonid ja muud konkreetsed üksused, mis võivad olla ajakirjanduses või ärianalüüsis olulised märksõnad. Teema modelleerimine paljastab tekstis laiemad teemad, muutes suurte andmemahtude kategoriseerimise lihtsamaks.

Parimad tööriistad tekstist märksõnade genereerimiseks

Märksõnade ekstraheerimist saab teha mitmesuguste spetsiaalsete tööriistade ja platvormide abil. Allpool on ülevaade mõnest juhtivast valikust, millest igaüks sobib erinevate kasutajate nõudmistega – alates SEO optimeerimisest kuni põhjaliku andmeanalüüsini.

1 Eskritor

Eskritor on täiustatud AI-põhine kirjutamisplatvorm, mis on loodud selleks, et lihtsustada ja täiustada märksõnade eraldamise protsessi erinevate valdkondade kasutajate jaoks – olenemata sellest, kas optimeerite SEOjaoks, töötate välja turunduskampaaniaid või viite läbi akadeemilisi uuringuid. Kasutades võimsaid loomuliku keele töötlemise (NLP) algoritme, tuvastab Eskritor automaatselt teie tekstis olulised terminid ja fraasid, tuues esile nii sageduspõhised märksõnad kui ka kontekstipõhised teadmised.

Põhijooned

- AI-toega kirjutamistööriist, mis on kohandatud SEO, turunduse ja akadeemiliseks kasutamiseks

- Lihtne liides teksti analüüsimiseks ja rakendatavate märksõnade genereerimiseks

Miks see silma paistab

- Kiirendab märksõnade analüüsi täiustatud NLP algoritmidega

- Pakub kohandatavaid võimalusi sageduse filtreerimiseks ja semantiliseks analüüsiks

2 Google Keyword Planner

Digitaalsete turundajate põhitoode Google Keyword Planner viib soovitatud märksõnad vastavusse otsingumahu andmetega. Kuigi see on mõeldud peamiselt PPC-kampaaniate jaoks, aitab see ka sisuloojatel oma teemasid kasutajate tegelike päringute põhjal täpsustada. Integratsioon Google Ads -ga annab otsese ülevaate sellest, kui sageli konkreetseid termineid otsitakse, andes teile edumaa kasutaja kavatsustele vastava sisu loomisel.

3 MonkeyLearn

Ideaalne tekstianalüüsiks, MonkeyLearn pakub märksõnade ekstraheerimist võimsate NLP API-de abil. See paistab silma tagasiside, arvustuste või sotsiaalmeedia vestluste kategoriseerimisel, muutes selle väärtuslikuks brändidele, mis keskenduvad sentimentide ja trendide analüüsile. MonkeyLearnarmatuurlaud sisaldab reaalajas töötlemise võimalusi, mis tähendab, et saate seadistada selle sissetulevate andmete pidevaks analüüsimiseks – ideaalne kiire tempoga turundusmeeskondade või klienditoe toimingute jaoks.

4 R- ja Python raamatukogud

Kasutajatele, kes tunnevad programmeerimist, võimaldavad sellised teegid nagu Tidytext (R) ja spaCy (Python) põhjalikku ja kohandatavat märksõnade ekstraheerimist. Saate rakendada TF-IDF, teemade modelleerimist ja sentimentide analüüsi väga spetsialiseeritud või suuremahuliste projektide jaoks.

Need teegid pakuvad paindlikkust parameetrite peenhäälestamiseks või masinõppe raamistikega integreerimiseks, muutes need ideaalseks andmeteadlastele või teadlastele, kes vajavad täielikult kohandatud tekstianalüüsi konveierit.

5 Semrush

SEO professionaalide seas populaarne valik Semrush ühendab märksõnade uurimise konkurentsianalüüsiga. Selle keskendumine otsingumahule, raskusastmetele ja konkurentide strateegiatele aitab täpsustada sisuplaane maksimaalse nähtavuse saavutamiseks.

Lisaks märksõnasoovitustele pakub Semrush domeenitasandi teadmisi, nagu tagasilinkide profiilid ja liiklusanalüüs, võimaldades terviklikku lähenemist SEO - ja digitaalse turunduse taktikatele.

Samm-sammuline juhend märksõnade loomiseks Eskritor

Kui tegemist on lihtsa, kuid võimsa märksõnade eraldamisega, pakub Eskritor suurepärast tasakaalu kasutatavuse ja täiustatud NLP funktsioonide vahel. Siit saate teada, kuidas selle platvormi maksimaalselt ära kasutada.

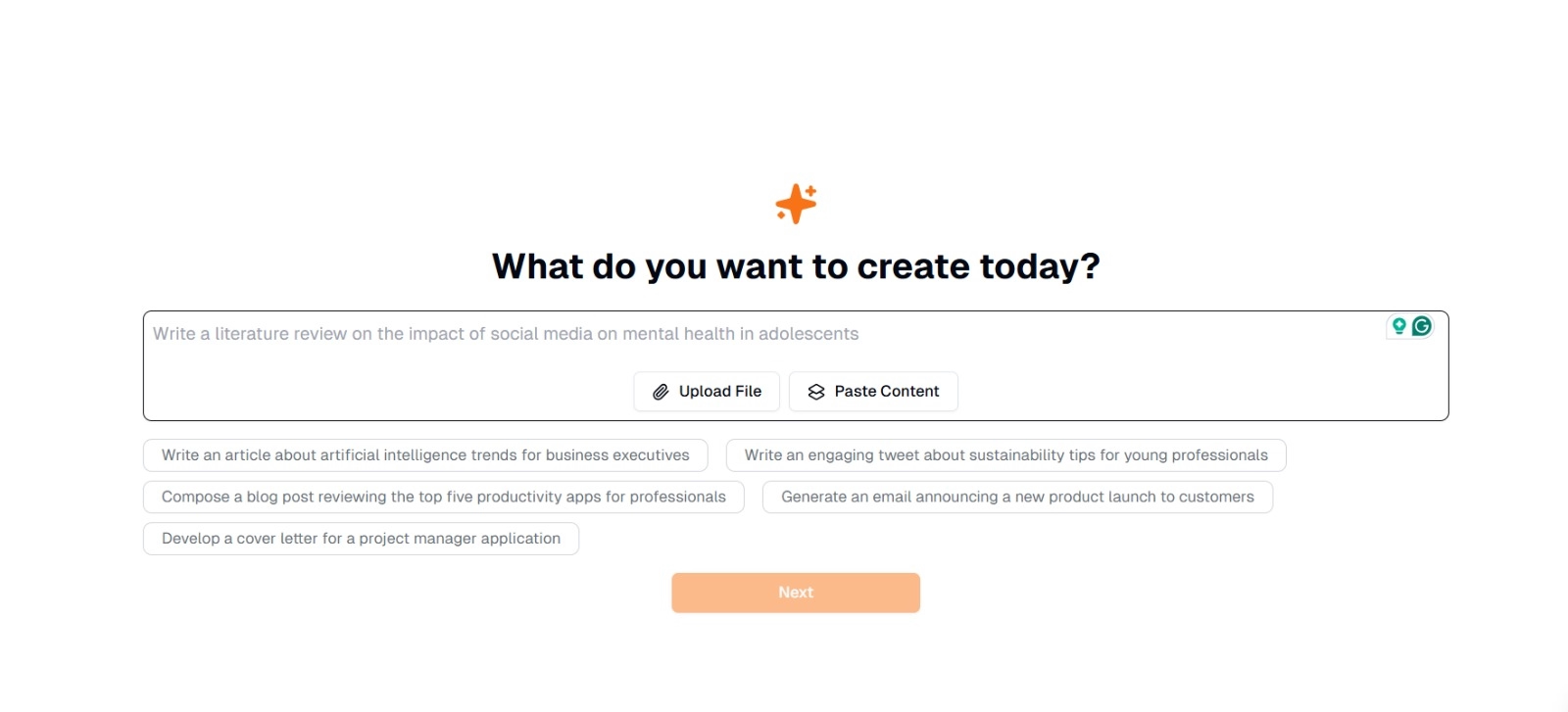

1. toiming: sisestage või laadige üles tekst

Eskritorpõhiliideses näete viipa, mis küsib: "Mida soovite täna luua?" Siin on teil kaks võimalust:

- Kleebi sisu : Kopeerige ja kleepige oma tekst otse antud tekstikasti.

- Laadi fail üles : Valige dokument (nt .docx, .pdf .txt), mis sisaldab teksti, mida soovite analüüsida.

Näpunäide : Kui kavatsete teksti enne ekstraheerimist genereerida või ümber töötada, saate valida ka soovitatud viipade hulgast (nt "Kirjutage artikkel tehisintellekti trendidest..."), kui kavatsete teksti enne ekstraheerimist genereerida või ümber töötada.

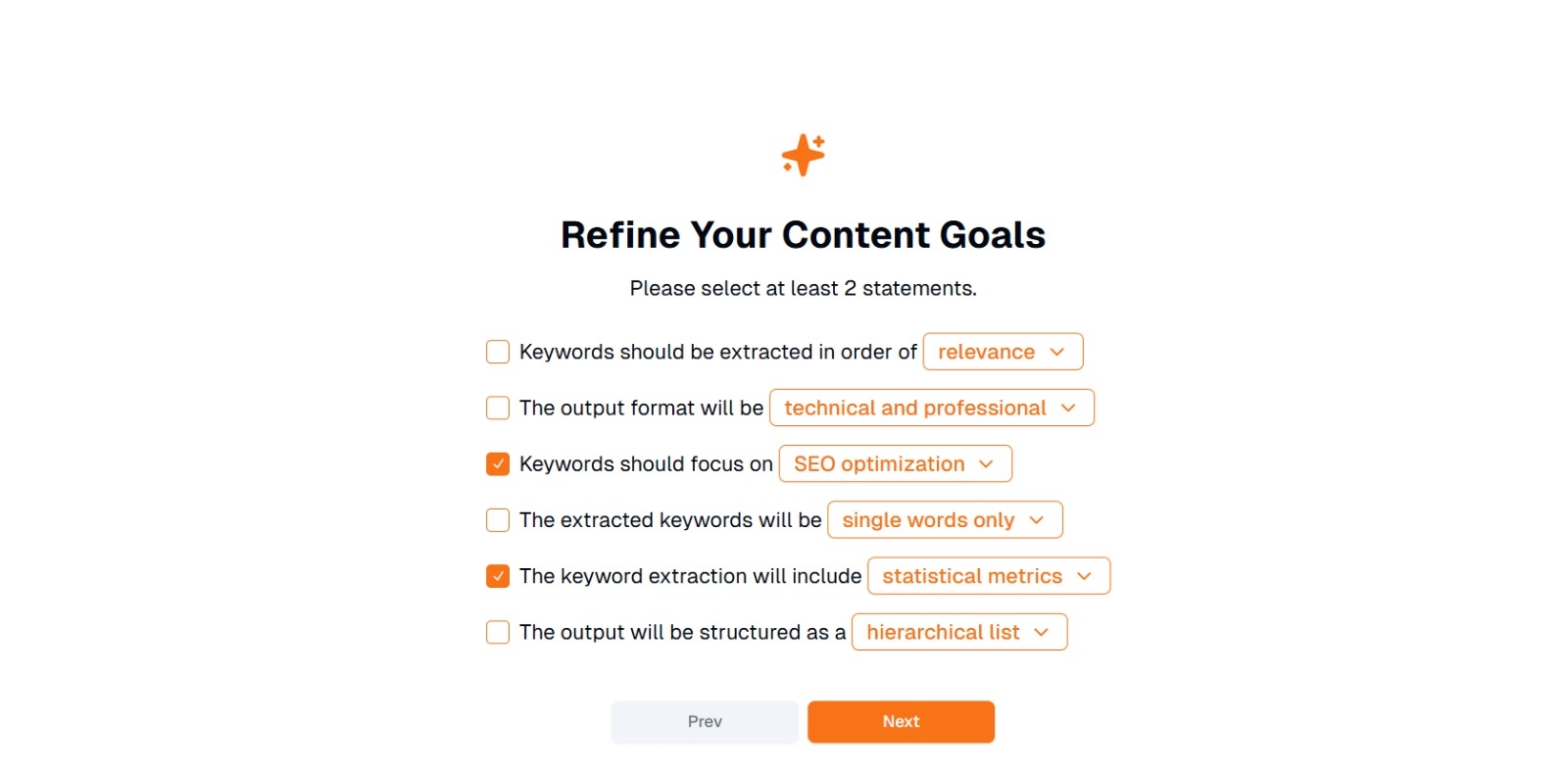

2. samm: täpsustage oma sisueesmärke

Teilt küsitakse " Mida soovite selle sisuga teha? " ja palus valida vähemalt 2 väidet . Samuti saate kirjutada, mida soovite vestluseks teha. Valikud võivad hõlmata järgmist:

- Märksõnad tuleks eraldada järgmises järjekorras: (nt asjakohasus , sagedus, tähestikuline jne )

- Väljundvorming on järgmine: (nt tehniline ja professionaalne , juhuslik ja sõbralik )

- Märksõnad peaksid keskenduma: (nt SEO optimeerimine, akadeemilised uuringud, turunduse nurgad)

- Ekstraheeritud märksõnad on järgmised: (nt ainult üksikud sõnad , mitmesõnalised fraasid )

- Märksõnade ekstraheerimine sisaldab: (nt statistilised mõõdikud , semantiline rühmitamine )

- Väljund struktureeritakse järgmiselt: (nt hierarhiline loend , lihtsad täpppunktid )

Näpunäide : Valige avaldused, mis vastavad kõige paremini teie projekti vajadustele. Näiteks kui optimeerite ajaveebi postitust otsingumootorite jaoks, kaaluge kontrollimist SEO optimeerimine , ainult üksikud sõnad ja ekstraheeritud asjakohasuse järjekorras .

3. samm: märksõnade genereerimiseks klõpsake nuppu "Järgmine"

Pärast eesmärkide täpsustamist ja soovitud valikute tegemist klõpsake märksõnade ekstraheerimise alustamiseks nuppu Edasi (või sarnast nuppu). Eskritor AI töötleb teksti, rakendades NLP meetodeid, nagu terminite sageduse analüüs, TF-IDFja semantiline analüüs (vastavalt vajadusele), et tuvastada kõige asjakohasemad märksõnad.

4. samm: vaadake üle ekstraheeritud märksõnad

Eskritor esitab märksõnade loendi (või hierarhia), mis põhineb teie valitud kriteeriumidel. Ekraan võib sisaldada järgmist.

- Märksõnade loend : Korraldatud asjakohasuse, sageduse või hierarhilises vormingus.

Nõuanne : Pöörake tähelepanu märksõnadele, mis võivad vajada ühendamist (nt ainsuse või mitmuse vormid) või eemaldamist (nt liiga üldised terminid).

5. samm: eksportige või rakendage tulemused

Lõpuks eksportige märksõnade loend või lisage see otse oma töövoogu:

- Ekspordi valikud : Laadige alla PDF, docx või HTML.

- Kasutusjuhtumid : Integreerige SEO tööriistadesse, sisu planeerimise dokumentidesse, uurimistööde ülevaadetesse või turunduse armatuurlaudadesse.

Näpunäiteid tõhusaks märksõnade genereerimiseks

Tagamaks, et teie märksõnade ekstraheerimine on nii täpne kui ka kooskõlas teie eesmärkidega, on vaja strateegiat. Siin on mõned parimad tavad, mida kaaluda.

1 Puhastage ja eeltöödelge teksti

Segaduse vältimiseks eemaldage enne analüüsi stoppsõnad, erimärgid ja ebaolulised andmed. Sellised tööriistad nagu NLTK (Python) või teatud tekstiredaktorid võivad selle eeltöötlusetapi automatiseerida.

2 Tasakaalu sagedus ja asjakohasus

Märksõna ei seisne ainult selles, mitu korda see esineb, vaid ka kontekstipõhises tähtsuses. Õige tasakaalu leidmiseks kombineerige sagedusmõõdikuid semantilise analüüsiga.

3 Kasutage erinevaid tehnikaid

Kasutage mitut lähenemisviisi –TF-IDF, semantilist analüüsi või nimelise üksuse tuvastamist –, et jäädvustada rohkem asjakohaseid märksõnu ja minimeerida pimealasid.

4 Pidev testimine ja täiustamine

Märksõnade suundumused võivad aja jooksul muutuda, eriti kiiresti muutuvates tööstusharudes. Värskendage oma märksõnu regulaarselt uute andmete, toimivusmõõdikute või vaatajaskonna muutuvate vajaduste põhjal.

Järeldus: lihtsustage märksõnade genereerimist AI

Tõhusate märksõnade genereerimine on tänapäevaste sisustrateegiate, uurimistöövoogude ja andmeanalüüsi ülesannete keskne osa. AI - ja NLP-põhised tööriistad, nagu Eskritor , on muutnud väärtuslike märksõnade ekstraheerimise, täpsustamise ja eksportimise lihtsamaks kui kunagi varem murdosa ajast, mis kuluks käsitsi.

Kombineerides mitut tehnikat –TF-IDF, semantilist analüüsi, teemade modelleerimist ja palju muud – saate põhjaliku ülevaate sellest, mis teie tekstis tõeliselt oluline on. See ülevaade soodustab paremaid SEO tulemusi, sihipärasemaid uuringuid ja kaasahaaravaid turundusmaterjale. Lühidalt öeldes ei ole AI-põhine märksõnade ekstraheerimine enam valikuline; see on vajalik professionaalidele, kes hindavad tõhusust, täpsust ja andmepõhist otsuste tegemist.

Dubai, AÜE

Dubai, AÜE