In der heutigen digitalen Landschaft ist die Fähigkeit, Schlüsselwörter aus Text zu generieren, für die SEO, die Erstellung von Inhalten und die akademische Forschung unerlässlich. Die Identifizierung der Begriffe und Phrasen, die Ihre Inhalte am besten repräsentieren, kann das Suchmaschinen-Ranking verbessern, die Recherchebemühungen rationalisieren und effektive Content-Strategien leiten. Moderne Fortschritte in der Verarbeitung natürlicher Sprache für die Keyword-Extraktion machen diesen Prozess einfacher und genauer als je zuvor, wobei Tools wie Eskritor als Paradebeispiele für Innovation hervorstechen.

In diesem Leitfaden untersuchen wir die Bedeutung der Textanalyse für die Keyword-Generierung, befassen uns mit verschiedenen Techniken – einschließlich der Begriffshäufigkeitsanalyse für Keywords und der Verwendung von TF-IDF für die Keyword-Extraktion – und diskutieren die semantische Analyse für die Generierung von Keywords im Kontext. Wir stellen Ihnen auch die besten Tools zum Generieren von Keywords aus Text vor und bieten eine Schritt-für-Schritt-Anleitung für die Keyword-Generierung.

Warum Keywords aus Text generieren?

Die Keyword-Extraktion untermauert eine Vielzahl von professionellen Aufgaben – von der Verbesserung des Website-Rankings bis hin zur Kategorisierung von Forschungsdokumenten. Im Folgenden finden Sie einige wichtige Gründe, warum dieser Prozess für moderne Content- und Datenstrategien von entscheidender Bedeutung ist.

1 Optimieren Sie Inhalte für SEO

Keywords bilden das Rückgrat jeder effektiven Strategie zur Suchmaschinenoptimierung . Indem Sie die relevantesten Begriffe identifizieren, die von Ihrer Zielgruppe verwendet werden, können Sie Blog-Posts, Landing Pages und andere Online-Inhalte optimieren, um in den Suchergebnissen einen höheren Rang einzunehmen. Dies erhöht nicht nur den Traffic, sondern verbessert auch die Benutzerbindung, indem Sie Ihre Inhalte auf die Leserabsicht ausrichten.

2 Steigern Sie die Forschungseffizienz

Für Studenten, Forscher und Datenanalysten kann die Keyword-Extraktion den Zeitaufwand für das Durchsuchen großer Dokumente oder akademischer Arbeiten erheblich reduzieren. Durch die Hervorhebung der wichtigsten Ideen und Terminologie können Sie Ergebnisse schnell kategorisieren, wichtige Referenzen finden und sogar Trends über mehrere Studien hinweg verfolgen. Tools wie Google Scholar helfen weiter, verwandte Forschungsthemen und Artikel zu entdecken.

3 Verbessern Sie die Content-Strategie

Wenn Sie wissen, welche Keywords bei Ihrer Zielgruppe Anklang finden – seien es Long-Tail-Keywords für Nischenbranchen oder weit gefasste Begriffe mit hohem Suchvolumen – können Sie Ihren Content-Kalender effektiver planen. So wird sichergestellt, dass jedes Stück, das Sie produzieren, direkt das anspricht, wonach Ihre Leser oder Kunden suchen, was letztendlich die Konversionen und die Benutzerzufriedenheit steigert.

4 Automatisieren Sie manuelle Prozesse

Vorbei sind die Zeiten, in denen Teams seitenweise Text manuell überfliegen mussten, um wiederkehrende Themen und Phrasen zu identifizieren. Moderne Tools zur Keyword-Extraktion sparen Zeit und reduzieren menschliche Fehler, indem sie den gesamten Prozess automatisieren, sodass Sie sich auf übergeordnete Aufgaben wie Strategie, Analyse und Ausführung konzentrieren können.

5 Schnellere Ergebnisse

Die manuelle Verarbeitung großer Textmengen ist umständlich. Eine AI Lösung wie Eskritor kann Hunderte von Seiten in nur wenigen Minuten analysieren, sodass Sie schnell iterieren und datengestützte Entscheidungen schneller treffen können.

Gängige Techniken zum Generieren von Schlüsselwörtern aus Text

Verschiedene Techniken decken unterschiedliche analytische Anforderungen ab, egal ob Sie eine einfache Häufigkeitszählung oder ein tieferes semantisches Verständnis wünschen. Schauen wir uns die am weitesten verbreiteten Methoden an und wie sie helfen, aussagekräftige Keywords zu extrahieren.

1 Term-Häufigkeitsanalyse

Eine grundlegende Methode, die Term Frequency (TF), identifiziert die am häufigsten verwendeten Wörter oder Ausdrücke in einem Text. Dieser Ansatz kann zwar offensichtliche Schlüsselwörter aufdecken, berücksichtigt jedoch nicht die Einzigartigkeit oder Spezifität dieser Begriffe in mehreren Dokumenten.

2 TF-IDF (Term Frequency – Inverse Document Frequency)

TF-IDF verfeinert die grundlegende Häufigkeitsanalyse von Begriffen, indem berücksichtigt wird, wie wichtig ein Begriff in einem Satz von Dokumenten ist. Wörter, die in einem Dokument häufig vorkommen, in anderen jedoch selten, erhalten eine höhere Punktzahl, sodass sich diese Technik hervorragend für die Identifizierung speziellerer oder kontextspezifischer Schlüsselwörter eignet.

3 Semantische Analyse

Die semantische Analyse identifiziert kontextuell relevante Phrasen, indem sie die Beziehungen zwischen Wörtern und nicht nur häufig verwendete Wörter untersucht. Dies ist besonders nützlich, wenn Sie Synonyme, verwandte Begriffe oder thematisch verknüpfte Ideen erfassen möchten, anstatt sich wiederholende Wörter, die möglicherweise keine Bedeutung haben.

4 NLP-basierte Ansätze

Fortschrittliche NLP Techniken wie Named Entity Recognition (NER) und Themenmodellierung gehen über die einfache Wortzahl hinaus. NER identifiziert Personen, Orte, Organisationen und andere spezifische Entitäten, die wichtige Schlüsselwörter im Journalismus oder in der Geschäftsanalyse sein können. Die Themenmodellierung zeigt breitere Themen innerhalb eines Textes auf, was die Kategorisierung großer Datenmengen erleichtert.

Die besten Tools zum Generieren von Keywords aus Text

Die Keyword-Extraktion kann mit einer Reihe von spezialisierten Tools und Plattformen durchgeführt werden. Im Folgenden finden Sie einen Blick auf einige führende Optionen, die jeweils für unterschiedliche Benutzeranforderungen geeignet sind – von der SEO Optimierung bis hin zur umfassenden Datenanalyse.

1 Eskritor

Eskritor ist eine fortschrittliche, AI-gesteuerte Schreibplattform, die entwickelt wurde, um den Prozess der Keyword-Extraktion für Benutzer in verschiedenen Bereichen zu vereinfachen und zu verbessern – egal ob Sie für SEOoptimieren, Marketingkampagnen entwickeln oder akademische Forschung betreiben. Durch den Einsatz leistungsstarker Algorithmen zur Verarbeitung natürlicher Sprache (NLPidentifiziert Eskritor automatisch wichtige Begriffe und Phrasen in Ihrem Text und hebt sowohl frequenzbasierte Keywords als auch kontextgesteuerte Erkenntnisse hervor.

Hauptmerkmale

- AI-gestütztes Schreibwerkzeug, das auf SEO, Marketing und akademische Nutzung zugeschnitten ist

- Einfache Schnittstelle zum Analysieren von Text und Generieren von umsetzbaren Keywords

Warum es heraussticht

- Beschleunigt die Keyword-Analyse mit fortschrittlichen NLP -Algorithmen

- Bietet anpassbare Optionen für Frequenzfilterung und semantische Analyse

2 Google Keyword Planner

Google Keyword Planner ist ein Grundnahrungsmittel für digitale Vermarkter und gleicht vorgeschlagene Keywords mit Daten zum Suchvolumen ab. Es ist zwar in erster Linie für PPC-Kampagnen gedacht, hilft aber auch Content-Erstellern, ihre Themen auf der Grundlage echter Benutzeranfragen zu verfeinern. Die Integration mit Google Ads bietet direkte Einblicke in die Häufigkeit der Suche nach bestimmten Begriffen und verschafft Ihnen einen Vorsprung bei der Erstellung von Inhalten, die der Nutzerabsicht entsprechen.

3 MonkeyLearn

MonkeyLearn eignet sich ideal für die Textanalyse und bietet die Extraktion von Schlüsselwörtern mithilfe leistungsstarker NLP-APIs. Es eignet sich hervorragend zur Kategorisierung von Feedback, Bewertungen oder Social-Media-Geschwätz, was es für Marken wertvoll macht, die sich auf Stimmungs- und Trendanalysen konzentrieren. Das Dashboard von MonkeyLearnenthält Optionen für die Echtzeitverarbeitung, was bedeutet, dass Sie es so einrichten können, dass eingehende Daten kontinuierlich analysiert werden – perfekt für schnelllebige Marketingteams oder Kundensupport-Operationen.

4 R- und Python -Bibliotheken

Für Benutzer, die mit der Programmierung vertraut sind, ermöglichen Bibliotheken wie Tidytext (R) und spaCy (Python) eine detaillierte, anpassbare Schlüsselwortextraktion. Sie können TF-IDF, Themenmodellierung und Stimmungsanalyse für hochspezialisierte oder groß angelegte Projekte implementieren.

Diese Bibliotheken bieten die Flexibilität, Parameter fein abzustimmen oder in Frameworks für maschinelles Lernen zu integrieren, was sie ideal für Datenwissenschaftler oder Forscher macht, die eine vollständig zugeschnittene Textanalyse-Pipeline benötigen.

5 Semrush

Semrush ist eine beliebte Wahl bei SEO Profis und kombiniert Keyword-Recherche mit Wettbewerbsanalysen. Der Fokus auf Suchvolumen, Schwierigkeitswerte und Wettbewerbsstrategien hilft dabei, Inhaltspläne für maximale Sichtbarkeit zu verfeinern.

Neben Keyword-Vorschlägen bietet Semrush Einblicke auf Domain-Ebene, wie z. B. Backlink-Profile und Traffic-Analysen, und ermöglicht so einen ganzheitlichen Ansatz für SEO und digitale Marketingtaktiken.

Schritt-für-Schritt-Anleitung zum Generieren von Keywords mit Eskritor

Wenn es um eine unkomplizierte und dennoch leistungsstarke Keyword-Extraktion geht, bietet Eskritor eine hervorragende Balance zwischen Benutzerfreundlichkeit und fortschrittlichen NLP Funktionen. Hier erfahren Sie, wie Sie die Plattform optimal nutzen können.

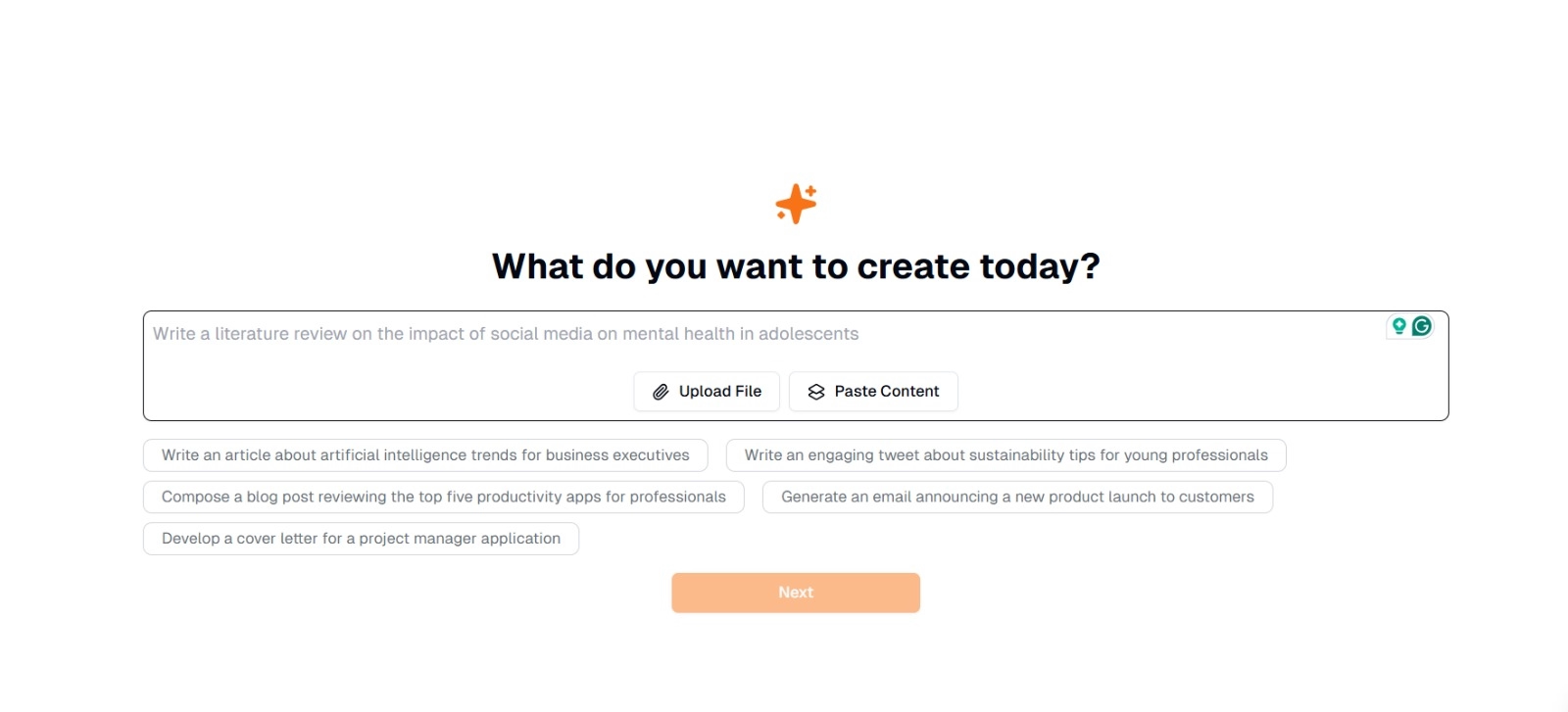

Schritt 1: Geben Sie Ihren Text ein oder laden Sie ihn hoch

Auf der Hauptoberfläche von Eskritorsehen Sie eine Eingabeaufforderung, in der Sie gefragt werden: "Was möchten Sie heute erstellen?" Hier haben Sie zwei Möglichkeiten:

- Inhalt einfügen : Kopieren Sie Ihren Text und fügen Sie ihn direkt in das angegebene Textfeld ein.

- Datei hochladen : Wählen Sie ein Dokument (z. B. .docx, .pdf .txt) aus, das den Text enthält, den Sie analysieren möchten.

Tipp : Sie können auch aus vorgeschlagenen Eingabeaufforderungen auswählen (z. B. "Schreiben Sie einen Artikel über Trends im Bereich der künstlichen Intelligenz..."), wenn Sie vorhaben, Text vor der Extraktion zu generieren oder zu überarbeiten.

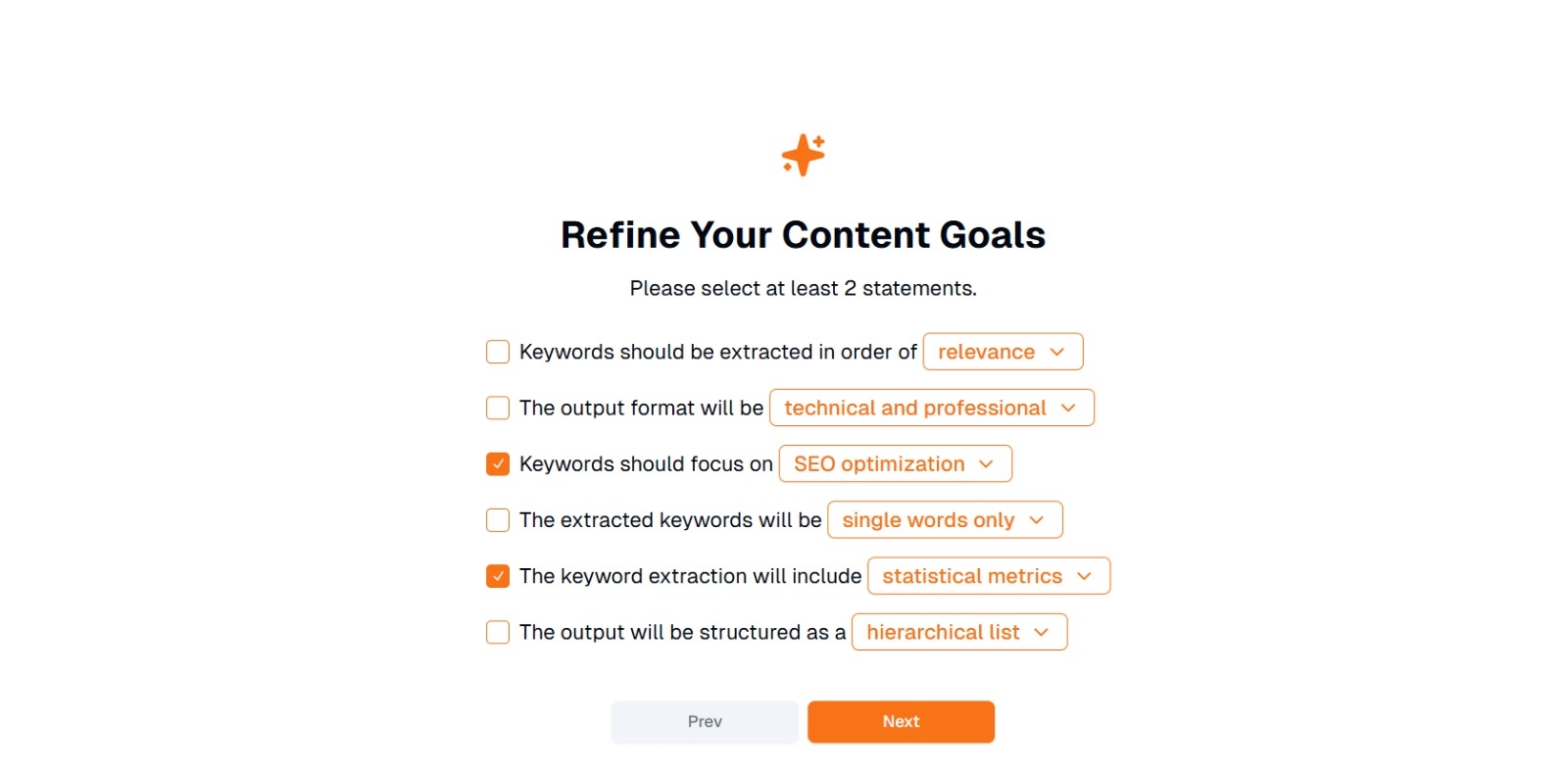

Schritt 2: Verfeinern Sie Ihre Content-Ziele

Sie werden gefragt: " Was möchten Sie mit diesen Inhalten tun? " und aufgefordert, mindestens 2 Aussagen auszuwählen . Sie können auch schreiben, was Sie tun möchten, um zu chatten. Zu den Optionen gehören:

- Schlüsselwörter sollten in der folgenden Reihenfolge extrahiert werden: (z. B. Relevanz , Häufigkeit , alphabetisch usw.)

- Das Ausgabeformat wird sein: (z. B. technisch und professionell , lässig und freundlich )

- Keywords sollten sich auf Folgendes konzentrieren: (z. B. SEO Optimierung, akademische Forschung, Marketingaspekte)

- Die extrahierten Schlüsselwörter sind: (z. B. nur einzelne Wörter , Phrasen mit mehreren Wörtern )

- Die Keyword-Extraktion umfasst: (z. B. statistische Metriken , semantische Gruppierung )

- Die Ausgabe wird wie folgt strukturiert sein: (z. B. eine hierarchische Liste , einfache Aufzählungspunkte )

Tipp : Wählen Sie die Aussagen aus, die den Anforderungen Ihres Projekts am besten entsprechen. Wenn Sie beispielsweise einen Blogbeitrag für Suchmaschinen optimieren, sollten Sie SEO Optimierung , nur einzelne Wörter und extrahiert in der Reihenfolge ihrer Relevanz zu überprüfen.

Schritt 3: Klicken Sie auf "Weiter", um Schlüsselwörter zu generieren

Nachdem Sie Ihre Ziele verfeinert und die gewünschte Auswahl getroffen haben, klicken Sie auf Weiter (oder eine ähnliche Schaltfläche), um die Keyword-Extraktion zu starten. Eskritor AI verarbeitet den Text und wendet NLP Methoden wie Häufigkeitsanalyse, TF-IDFund semantische Analyse (falls zutreffend) an, um die relevantesten Schlüsselwörter zu identifizieren.

Schritt 4: Überprüfen Sie die extrahierten Keywords

Eskritor wird eine Liste (oder Hierarchie) von Schlüsselwörtern angezeigt, die auf den von Ihnen ausgewählten Kriterien basieren. Die Anzeige kann Folgendes enthalten:

- Keyword-Liste : Geordnet nach Relevanz, Häufigkeit oder in einem hierarchischen Format.

Tipp : Achten Sie auf Keywords, die möglicherweise zusammengeführt (z. B. Singular- vs. Pluralformen) oder entfernt werden müssen (z. B. zu allgemeine Begriffe).

Schritt 5: Exportieren oder Anwenden der Ergebnisse

Exportieren Sie abschließend die Keyword-Liste oder binden Sie sie direkt in Ihren Workflow ein:

- Exportoptionen : Download in PDF, docx oder HTML.

- Anwendungsfälle : Integration in SEO Tools, Content-Planungsdokumente, Forschungsskizzen oder Marketing-Dashboards.

Tipps für eine effektive Keyword-Generierung

Um sicherzustellen, dass Ihre Keyword-Extraktion sowohl korrekt als auch auf Ihre Ziele abgestimmt ist, ist eine Strategie erforderlich. Hier sind einige Best Practices, die Sie berücksichtigen sollten.

1 Bereinigen und Vorverarbeiten des Textes

Entfernen Sie Stoppwörter, Sonderzeichen und irrelevante Daten vor der Analyse, um Unordnung zu vermeiden. Tools wie NLTK (Python) oder bestimmte Texteditoren können diesen Vorverarbeitungsschritt automatisieren.

2 Ausgewogenheit von Häufigkeit und Relevanz

Bei einem Keyword geht es nicht nur darum, wie oft es auftaucht, sondern auch um die kontextuelle Bedeutung. Kombinieren Sie Frequenzmetriken mit semantischer Analyse, um die richtige Balance zu finden.

3 Verwenden Sie eine Mischung aus Techniken

Nutzen Sie mehrere Ansätze –TF-IDF, semantische Analyse oder Erkennung benannter Entitäten –, um eine breitere Palette relevanter Keywords zu erfassen und blinde Flecken zu minimieren.

4 Kontinuierliches Testen und Verfeinern

Keyword-Trends können sich im Laufe der Zeit ändern, insbesondere in schnelllebigen Branchen. Aktualisieren Sie Ihre Keywords regelmäßig auf der Grundlage neuer Daten, Leistungsmetriken oder sich ändernder Zielgruppenanforderungen.

Fazit: Keyword-Generierung vereinfachen mit AI

Die Generierung effektiver Keywords ist ein zentraler Bestandteil moderner Content-Strategien, Recherche-Workflows und Datenanalyseaufgaben. AI und NLP-gesteuerte Tools wie Eskritor haben es einfacher denn je gemacht, hochwertige Keywords in einem Bruchteil der Zeit zu extrahieren, zu verfeinern und zu exportieren, die manuell erforderlich wäre.

Durch die Kombination mehrerer Techniken –TF-IDF, semantische Analyse, Themenmodellierung und mehr – erhalten Sie ein umfassendes Verständnis dafür, worauf es in Ihrem Text wirklich ankommt. Diese Erkenntnisse führen zu besseren SEO Ergebnissen, gezielterer Forschung und ansprechenden Marketingmaterialien. Kurz gesagt, die AI-basierte Keyword-Extraktion ist nicht mehr optional. Es ist eine Notwendigkeit für Fachleute, die Wert auf Effizienz, Präzision und datengestützte Entscheidungsfindung legen.

Dubai, Vereinigte Arabische Emirate

Dubai, Vereinigte Arabische Emirate