Dalam landskap digital hari ini, keupayaan untuk menjana kata kunci daripada teks adalah penting untuk SEO, penciptaan kandungan dan penyelidikan akademik. Mengenal pasti istilah dan frasa yang paling mewakili kandungan anda boleh meningkatkan kedudukan enjin carian, menyelaraskan usaha penyelidikan dan membimbing strategi kandungan yang berkesan. Kemajuan moden dalam pemprosesan bahasa semula jadi untuk pengekstrakan kata kunci menjadikan proses ini lebih mudah dan lebih tepat berbanding sebelum ini, dengan alat seperti Eskritor menonjol sebagai contoh utama inovasi.

Dalam panduan ini, kami akan meneroka kepentingan analisis teks untuk penjanaan kata kunci, menyelidiki pelbagai teknik—termasuk analisis kekerapan istilah untuk kata kunci dan menggunakan TF-IDF untuk pengekstrakan kata kunci, dan membincangkan analisis semantik untuk menjana kata kunci dalam konteks. Kami juga akan menyerlahkan alat terbaik untuk menjana kata kunci daripada teks dan menyediakan tutorial langkah demi langkah untuk penjanaan kata kunci.

Mengapa Menjana Kata Kunci daripada Teks?

Pengekstrakan kata kunci menyokong pelbagai tugas profesional—daripada meningkatkan kedudukan tapak web kepada mengkategorikan dokumen penyelidikan. Di bawah ialah beberapa sebab teras mengapa proses ini penting untuk kandungan moden dan strategi data.

1 Optimumkan Kandungan untuk SEO

Kata kunci membentuk tulang belakang mana-mana strategi pengoptimuman enjin carian yang berkesan. Dengan mengenal pasti istilah yang paling relevan yang digunakan oleh khalayak sasaran anda, anda boleh mengoptimumkan catatan blog, halaman pendaratan dan kandungan dalam talian lain untuk mendapat kedudukan yang lebih tinggi dalam hasil carian. Ini bukan sahaja meningkatkan trafik tetapi juga meningkatkan penglibatan pengguna dengan menyelaraskan kandungan anda dengan niat pembaca.

2 Meningkatkan Kecekapan Penyelidikan

Bagi pelajar, penyelidik dan penganalisis data, pengekstrakan kata kunci boleh mengurangkan masa yang dihabiskan untuk menapis dokumen besar atau kertas akademik dengan ketara. Dengan menyerlahkan idea dan istilah utama, anda boleh mengkategorikan penemuan dengan cepat, mencari rujukan penting dan juga menjejaki arah aliran merentas pelbagai kajian. Alat seperti Google Scholar membantu lebih lanjut dalam menemui topik dan artikel penyelidikan yang berkaitan.

3 Tingkatkan Strategi Kandungan

Memahami kata kunci yang bergema dengan khalayak anda—sama ada kata kunci ekor panjang untuk industri khusus atau istilah luas dengan volum carian yang tinggi—membantu anda merancang kalendar kandungan anda dengan lebih berkesan. Ini memastikan setiap karya yang anda hasilkan bercakap terus dengan perkara yang dicari oleh pembaca atau pelanggan anda, akhirnya meningkatkan penukaran dan kepuasan pengguna.

4 Mengautomasikan Proses Manual

Sudah berlalu hari-hari apabila pasukan terpaksa melayari halaman dan halaman teks secara manual untuk mengenal pasti tema dan frasa yang berulang. Alat pengekstrakan kata kunci moden menjimatkan masa dan mengurangkan kesilapan manusia dengan mengautomasikan keseluruhan proses, membolehkan anda menumpukan pada tugas peringkat tinggi seperti strategi, analisis dan pelaksanaan.

5 Keputusan Lebih Pantas

Memproses sejumlah besar teks secara manual adalah membebankan. Penyelesaian AI seperti Eskritor boleh menganalisis beratus-ratus halaman dalam beberapa minit sahaja, membolehkan anda mengulangi dengan cepat dan membuat keputusan berdasarkan data dengan lebih pantas.

Teknik Biasa untuk Menjana Kata Kunci daripada Teks

Teknik yang berbeza memenuhi pelbagai keperluan analisis, sama ada anda mahukan kiraan frekuensi yang mudah atau pemahaman semantik yang lebih mendalam. Mari kita terokai kaedah yang paling banyak digunakan dan cara ia membantu mengekstrak kata kunci yang bermakna.

1 Analisis Kekerapan Istilah

Kaedah asas, Kekerapan Istilah (TF), mengenal pasti perkataan atau frasa yang paling biasa digunakan dalam teks. Walaupun pendekatan ini boleh memaparkan kata kunci yang jelas, ia tidak mengambil kira keunikan atau kekhususan istilah tersebut merentas berbilang dokumen.

2 TF-IDF (Kekerapan Penggal–Kekerapan Dokumen Songsang)

TF-IDF memperhalusi analisis kekerapan istilah asas dengan mengambil kira betapa pentingnya istilah merentasi satu set dokumen. Perkataan yang kerap muncul dalam satu dokumen tetapi jarang dalam dokumen lain menerima skor yang lebih tinggi, menjadikan teknik ini sangat baik untuk menentukan kata kunci yang lebih khusus atau khusus konteks.

3 Analisis Semantik

Analisis semantik mengenal pasti frasa yang relevan secara kontekstual dengan meneliti hubungan antara perkataan dan bukannya hanya perkataan yang kerap digunakan. Ini amat berguna jika anda ingin menangkap sinonim, istilah berkaitan atau idea yang dikaitkan secara tematik dan bukannya perkataan berulang yang mungkin tidak membawa kepentingan.

4 Pendekatan berasaskan NLP

Teknik NLP lanjutan seperti Pengiktirafan Entiti Bernama (NER) dan pemodelan topik melangkaui kiraan perkataan yang mudah. NER mengenal pasti orang, tempat, organisasi dan entiti khusus lain, yang boleh menjadi kata kunci penting dalam kewartawanan atau analisis perniagaan. Pemodelan topik mendedahkan tema yang lebih luas dalam teks, menjadikannya lebih mudah untuk mengkategorikan jumlah data yang besar.

Alat Terbaik untuk Menjana Kata Kunci daripada Teks

Pengekstrakan kata kunci boleh dilakukan menggunakan pelbagai alatan dan platform khusus. Di bawah ialah beberapa pilihan utama, masing-masing sesuai untuk keperluan pengguna yang berbeza—daripada pengoptimuman SEO kepada analisis data yang komprehensif.

1 Eskritor

Eskritor ialah platform penulisan lanjutan yang dipacu AIyang direka untuk memudahkan dan meningkatkan proses pengekstrakan kata kunci untuk pengguna merentas pelbagai bidang—sama ada anda mengoptimumkan untuk SEO, membangunkan kempen pemasaran atau menjalankan penyelidikan akademik. Dengan memanfaatkan algoritma pemprosesan bahasa semula jadi (NLP) yang berkuasa, Eskritor mengenal pasti istilah dan frasa penting dalam teks anda secara automatik, menyerlahkan kedua-dua kata kunci berasaskan kekerapan dan cerapan dipacu konteks.

Ciri-ciri utama

- Alat penulisan berkuasa AIyang disesuaikan untuk kegunaan SEO, pemasaran dan akademik

- Antara muka mudah untuk menganalisis teks dan menjana kata kunci yang boleh diambil tindakan

Mengapa Ia Menonjol

- Mempercepatkan analisis kata kunci dengan algoritma NLP lanjutan

- Menawarkan pilihan yang boleh disesuaikan untuk penapisan frekuensi dan analisis semantik

2 Google Keyword Planner

Ruji untuk pemasar digital, Google Keyword Planner menyelaraskan kata kunci yang dicadangkan dengan data volum carian. Walaupun ia terutamanya untuk kempen PPC, ia juga membantu pencipta kandungan memperhalusi topik mereka berdasarkan pertanyaan pengguna sebenar. Penyepaduan dengan Google Ads memberikan cerapan langsung tentang kekerapan istilah tertentu dicari, memberikan anda permulaan yang baik dalam mencipta kandungan yang sepadan dengan niat pengguna.

3 MonkeyLearn

Sesuai untuk analisis teks, MonkeyLearn menyediakan pengekstrakan kata kunci menggunakan API NLP yang berkuasa. Ia cemerlang dalam mengkategorikan maklum balas, ulasan atau perbualan media sosial, menjadikannya berharga untuk jenama yang memfokuskan pada analisis sentimen dan trend. Papan pemuka MonkeyLearntermasuk pilihan untuk pemprosesan masa nyata, bermakna anda boleh menyediakannya untuk menganalisis data masuk secara berterusan—sesuai untuk pasukan pemasaran pantas atau operasi sokongan pelanggan.

4 Perpustakaan R dan Python

Bagi pengguna yang selesa dengan pengaturcaraan, perpustakaan seperti Tidytext (R) dan spaCy (Python) membolehkan pengekstrakan kata kunci yang mendalam dan boleh disesuaikan. Anda boleh melaksanakan TF-IDF, pemodelan topik dan analisis sentimen untuk projek yang sangat khusus atau berskala besar.

Perpustakaan ini menawarkan fleksibiliti untuk memperhalusi parameter atau menyepadukan dengan rangka kerja pembelajaran mesin, menjadikannya sesuai untuk saintis data atau penyelidik yang memerlukan saluran paip analisis teks yang disesuaikan sepenuhnya.

5 Semrush

Pilihan popular di kalangan profesional SEO , Semrush menggabungkan penyelidikan kata kunci dengan analisis persaingan. Tumpuannya pada volum carian, skor kesukaran dan strategi pesaing membantu memperhalusi rancangan kandungan untuk keterlihatan maksimum.

Di luar cadangan kata kunci, Semrush menyediakan cerapan peringkat domain, seperti profil pautan balik dan analitik trafik, membolehkan pendekatan holistik untuk SEO dan taktik pemasaran digital.

Panduan Langkah demi Langkah untuk Menjana Kata Kunci dengan Eskritor

Apabila bercakap tentang pengekstrakan kata kunci yang mudah namun berkuasa, Eskritor menawarkan keseimbangan yang sangat baik antara kebolehgunaan dan ciri NLP lanjutan. Berikut ialah cara untuk memanfaatkan sepenuhnya platformnya.

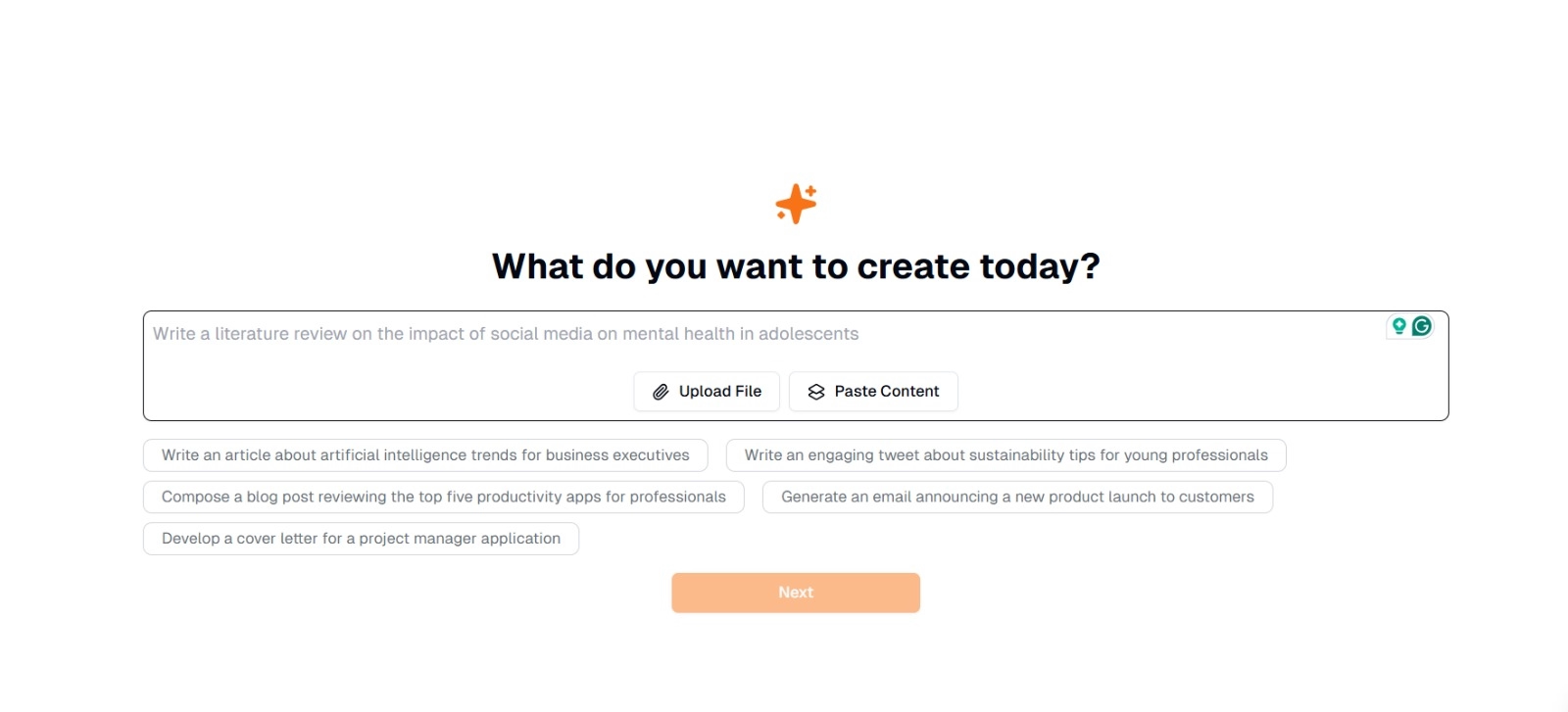

Langkah 1: Masukkan atau Muat Naik Teks Anda

Pada antara muka utama Eskritor, anda akan melihat gesaan yang bertanya, "Apa yang anda mahu buat hari ini?" Di sini, anda mempunyai dua pilihan:

- Tampal Kandungan : Salin dan tampal teks anda terus ke dalam kotak teks yang diberikan.

- Muat Naik Fail : Pilih dokumen (cth, .docx, .pdf, .txt) yang mengandungi teks yang ingin anda analisis.

Petua : Anda juga boleh memilih daripada gesaan yang dicadangkan (cth., "Tulis artikel tentang trend kecerdasan buatan...") jika anda bercadang untuk menjana atau mengolah semula teks sebelum pengekstrakan.

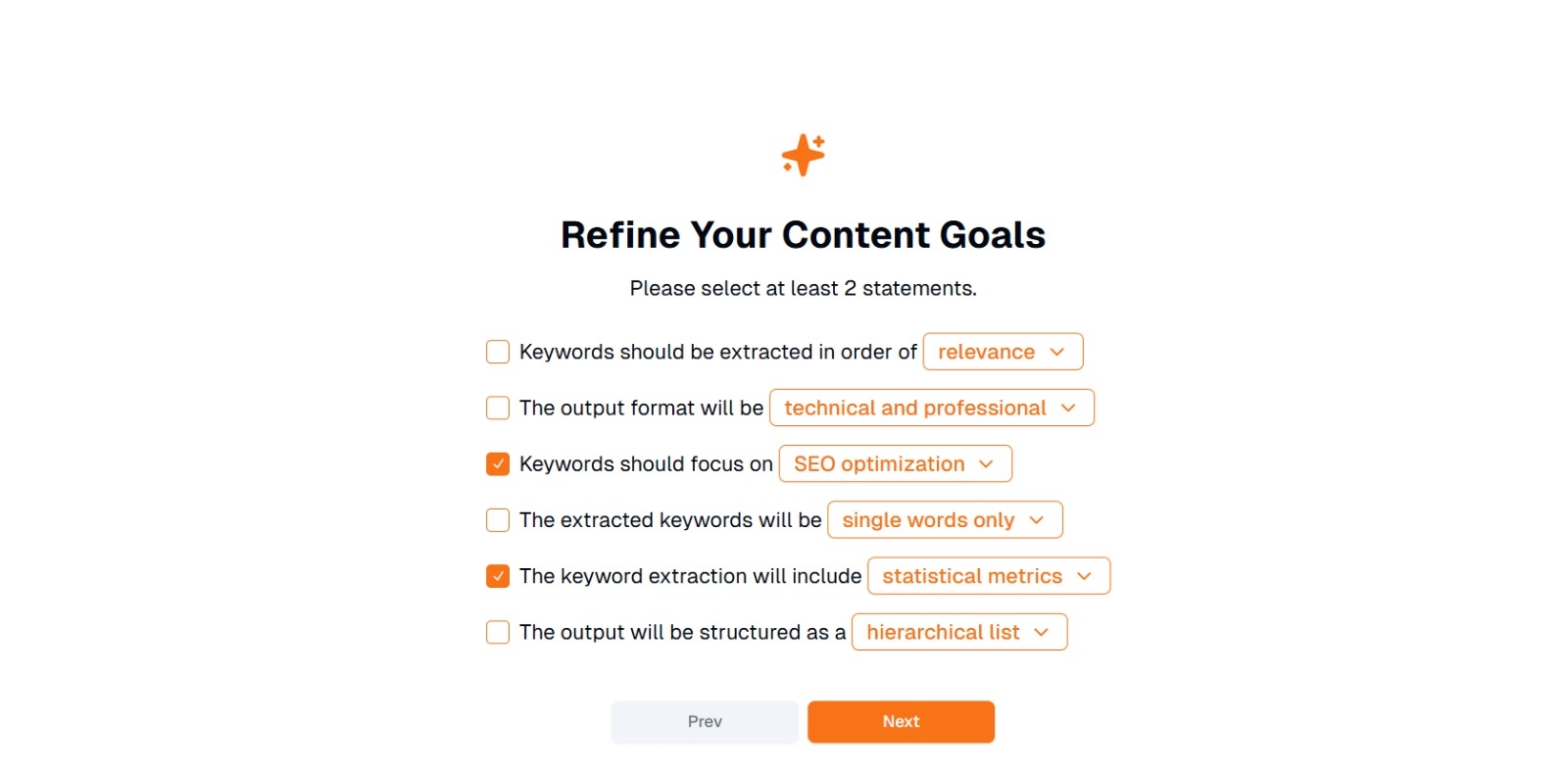

Langkah 2: Perhalusi Matlamat Kandungan Anda

Anda akan digesa dengan " Apa yang anda mahu lakukan dengan kandungan ini? " dan diminta untuk memilih sekurang-kurangnya 2 kenyataan . Selain itu, anda boleh menulis apa yang anda mahu lakukan untuk berbual. Pilihan mungkin termasuk:

- Kata kunci hendaklah diekstrak mengikut urutan: (cth, perkaitan , kekerapan , abjad , dll.)

- Format output ialah: (cth, teknikal dan profesional , kasual dan mesra )

- Kata kunci harus memberi tumpuan kepada: (cth, pengoptimumanSEO, penyelidikan akademik, sudut pemasaran)

- Kata kunci yang diekstrak ialah: (cth, perkataan tunggal sahaja , frasa berbilang perkataan )

- Pengekstrakan kata kunci akan merangkumi: (cth, metrik statistik, kumpulan semantik)

- Output akan distrukturkan sebagai: (cth, senarai hierarki , titik tumpu mudah )

Petua : Pilih pernyataan yang paling sepadan dengan keperluan projek anda. Sebagai contoh, jika anda mengoptimumkan catatan blog untuk enjin carian, pertimbangkan untuk menyemak pengoptimumanSEO , perkataan tunggal sahaja , dan diekstrak mengikut urutan perkaitan .

Langkah 3: Klik "Seterusnya" untuk menjana kata kunci

Selepas memperhalusi matlamat anda dan membuat pilihan yang dikehendaki, klik Seterusnya (atau butang yang serupa) untuk memulakan pengekstrakan kata kunci. AI Eskritorakan memproses teks, menggunakan kaedah NLP seperti analisis kekerapan istilah, TF-IDFdan analisis semantik (seperti yang berkenaan) untuk mengenal pasti kata kunci yang paling relevan.

Langkah 4: Semak Kata Kunci yang Diekstrak

Eskritor akan membentangkan senarai (atau hierarki) kata kunci berdasarkan kriteria yang anda pilih. Paparan mungkin termasuk:

- Senarai Kata Kunci : Disusun mengikut perkaitan, kekerapan, atau dalam format hierarki.

Petua : Perhatikan kata kunci yang mungkin perlu digabungkan (cth., bentuk tunggal berbanding jamak) atau penyingkiran (cth., istilah yang terlalu generik).

Langkah 5: Eksport atau Gunakan Keputusan

Akhir sekali, eksport senarai kata kunci atau gabungkan terus ke dalam aliran kerja anda:

- Pilihan Eksport : Muat turun dalam PDF, docx atau HTML.

- Kes Penggunaan : Sepadukan ke dalam alatan SEO , dokumen perancangan kandungan, garis besar penyelidikan atau papan pemuka pemasaran.

Petua untuk Penjanaan Kata Kunci yang Berkesan

Memastikan pengekstrakan kata kunci anda tepat dan sejajar dengan matlamat anda memerlukan strategi. Berikut ialah beberapa amalan terbaik untuk dipertimbangkan.

1 Bersihkan dan Praproses Teks

Alih keluar perkataan henti, aksara khas dan data yang tidak relevan sebelum analisis untuk mengelakkan kekacauan. Alat seperti NLTK (Python) atau editor teks tertentu boleh mengautomasikan langkah prapemprosesan ini.

2 Kekerapan dan Perkaitan Imbangan

Kata kunci bukan hanya tentang berapa kali ia muncul—ia juga mengenai kepentingan kontekstual. Gabungkan metrik kekerapan dengan analisis semantik untuk mencapai keseimbangan yang betul.

3 Gunakan Gabungan Teknik

Manfaatkan pelbagai pendekatan—TF-IDF, analisis semantik atau pengecaman entiti bernama—untuk menangkap rangkaian kata kunci yang berkaitan dengan lebih lengkap dan meminimumkan titik buta.

4 Menguji dan Memperhalusi Secara Berterusan

Trend kata kunci boleh berubah dari semasa ke semasa, terutamanya dalam industri yang bergerak pantas. Kemas kini kata kunci anda dengan kerap berdasarkan data baharu, metrik prestasi atau keperluan khalayak yang berkembang.

Kesimpulan: Permudahkan Penjanaan Kata Kunci dengan AI

Menjana kata kunci yang berkesan ialah bahagian penting dalam strategi kandungan moden, aliran kerja penyelidikan dan tugas analisis data. Alat yang dipacu AI dan NLPseperti Eskritor telah menjadikannya lebih mudah daripada sebelumnya untuk mengekstrak, memperhalusi dan mengeksport kata kunci bernilai tinggi dalam sebahagian kecil daripada masa yang diperlukan secara manual.

Dengan menggabungkan pelbagai teknik—TF-IDF, analisis semantik, pemodelan topik dan banyak lagi—anda memperoleh pemahaman yang komprehensif tentang perkara yang benar-benar penting dalam teks anda. Wawasan ini memacu hasil SEO yang lebih baik, penyelidikan yang lebih tertumpu dan bahan pemasaran yang menarik. Ringkasnya, pengekstrakan kata kunci berasaskan AIbukan lagi pilihan; Ia adalah satu keperluan bagi profesional yang menghargai kecekapan, ketepatan dan membuat keputusan berdasarkan data.

Dubai, UAE

Dubai, UAE