В днешния дигитален пейзаж способността за генериране на ключови думи от текст е от съществено значение за SEO, създаване на съдържание и академични изследвания. Идентифицирането на термините и фразите, които най-добре представят вашето съдържание, може да подобри класирането в търсачките, да рационализира изследователските усилия и да ръководи ефективни стратегии за съдържание. Съвременният напредък в обработката на естествен език за извличане на ключови думи прави този процес по-прост и по-точен от всякога, като инструменти като Eskritor се открояват като отлични примери за иновации.

В това ръководство ще проучим значението на анализа на текст за генериране на ключови думи, ще се задълбочим в различни техники – включително анализ на честотата на термините за ключови думи и използване на TF-IDF за извличане на ключови думи и ще обсъдим семантичен анализ за генериране на ключови думи в контекст. Също така ще подчертаем най-добрите инструменти за генериране на ключови думи от текст и ще предоставим урок стъпка по стъпка за генериране на ключови думи.

Защо да генерирате ключови думи от текст?

Извличането на ключови думи е в основата на различни професионални задачи – от подобряване на класирането на уебсайтовете до категоризиране на изследователски документи. По-долу са някои основни причини, поради които този процес е жизненоважен за съвременните стратегии за съдържание и данни.

1 Оптимизиране на съдържанието за SEO

Ключовите думи формират гръбнака на всяка ефективна стратегия за оптимизация за търсачки . Като идентифицирате най-подходящите термини, използвани от вашата целева аудитория, можете да оптимизирате публикации в блогове, целеви страници и друго онлайн съдържание, за да се класирате по-високо в резултатите от търсенето. Това не само увеличава трафика, но и подобрява ангажираността на потребителите, като привежда съдържанието ви в съответствие с намеренията на читателя.

2 Повишаване на ефективността на научните изследвания

За студенти, изследователи и анализатори на данни извличането на ключови думи може значително да намали времето, прекарано в пресяване на големи документи или академични статии. Като подчертаете основните идеи и терминология, можете бързо да категоризирате констатациите, да намерите важни препратки и дори да проследявате тенденциите в множество проучвания. Инструменти като Google Scholar допълнително помагат при откриването на свързани изследователски теми и статии.

3 Подобрете стратегията за съдържание

Разбирането кои ключови думи резонират с аудиторията ви – било то дълги ключови думи за нишови индустрии или широки термини с голям обем на търсене – ви помага да планирате календара си за съдържание по-ефективно. Това гарантира, че всяко произведение, което създавате, говори директно за това, което вашите читатели или клиенти търсят, като в крайна сметка повишава конверсиите и удовлетвореността на потребителите.

4 Автоматизирайте ръчните процеси

Отминаха дните, когато екипите трябваше ръчно да преглеждат страници и страници с текст, за да идентифицират повтарящи се теми и фрази. Съвременните инструменти за извличане на ключови думи спестяват време и намаляват човешката грешка чрез автоматизиране на целия процес, което ви позволява да се съсредоточите върху задачи от по-високо ниво като стратегия, анализ и изпълнение.

5 По-бързи резултати

Ръчната обработка на големи обеми текст е тромава. AI решение като Eskritor може да анализира стотици страници само за минути, което ви позволява да повтаряте бързо и да вземате решения, базирани на данни, по-бързо.

Общи техники за генериране на ключови думи от текст

Различните техники се грижат за различни аналитични нужди, независимо дали искате просто преброяване на честотата или по-дълбоко семантично разбиране. Нека разгледаме най-широко използваните методи и как те помагат за извличането на смислени ключови думи.

1 Анализ на честотата на термините

Основополагащ метод, честота на термините (TF), идентифицира най-често използваните думи или фрази в текста. Въпреки че този подход може да извади на повърхността очевидни ключови думи, той не отчита уникалността или спецификата на тези термини в множество документи.

2 TF-IDF (Честота на термина – Обратна честота на документа)

TF-IDF прецизира основния анализ на честотата на термините, като отчита колко важен е даден термин в набор от документи. Думите, които се появяват често в един документ, но рядко в други, получават по-висок резултат, което прави тази техника отлична за определяне на по-специализирани или специфични за контекста ключови думи.

3 Семантичен анализ

Семантичният анализ идентифицира контекстуално релевантните фрази, като изследва връзките между думите, а не само често използваните. Това е особено полезно, ако искате да уловите синоними, свързани термини или тематично свързани идеи, а не повтарящи се думи, които може да нямат значение.

4 Подходи, базирани на NLP

Усъвършенстваните техники за NLP като разпознаване на именувани обекти (NER) и моделиране на теми надхвърлят простия брой думи. NER идентифицира хора, места, организации и други специфични субекти, които могат да бъдат ключови ключови думи в журналистиката или бизнес анализа. Моделирането на теми разкрива по-широки теми в текста, което улеснява категоризирането на големи обеми данни.

Най-добрите инструменти за генериране на ключови думи от текст

Извличането на ключови думи може да се извърши с помощта на набор от специализирани инструменти и платформи. По-долу е даден поглед към някои водещи опции, всяка от които е подходяща за различни потребителски изисквания – от оптимизация на SEO до цялостен анализ на данни.

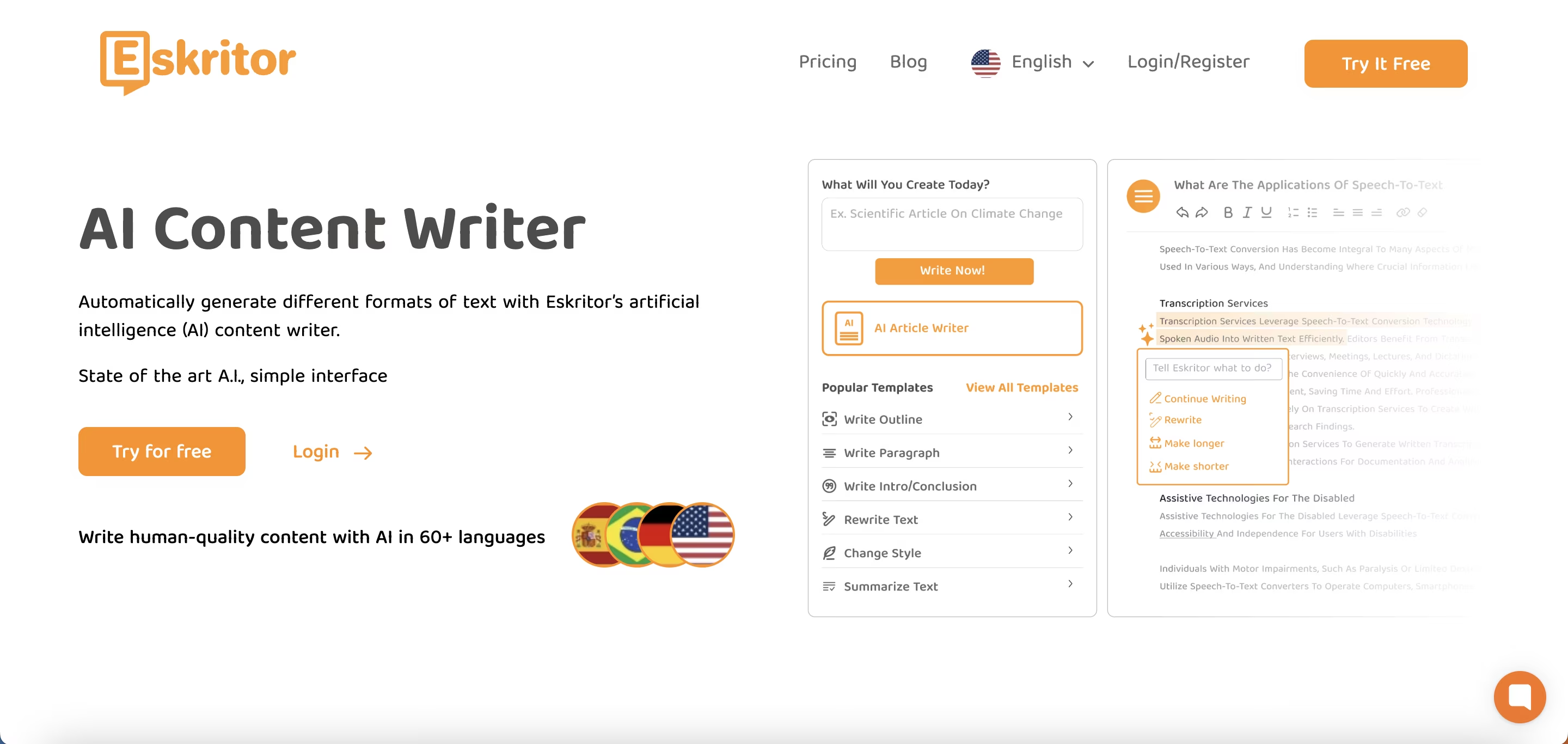

1 Eskritor

Eskritor е усъвършенствана платформа за писане, управлявана от AI, предназначена да опрости и подобри процеса на извличане на ключови думи за потребители в различни области – независимо дали оптимизирате за SEO, разработвате маркетингови кампании или провеждате академични изследвания. Чрез използване на мощни алгоритми за обработка на естествен език (NLP) Eskritor автоматично идентифицира важни термини и фрази във вашия текст, подчертавайки както ключови думи, базирани на честота, така и контекстно ориентирани прозрения.

Основни характеристики

- AIзахранван от инструмент за писане, пригоден за SEO, маркетинг и академична употреба

- Прост интерфейс за анализиране на текст и генериране на ключови думи за действие

Защо се откроява

- Ускорява анализа на ключови думи с усъвършенствани алгоритми за NLP

- Предлага персонализирани опции за честотно филтриране и семантичен анализ

2 Google Keyword Planner

Основен продукт за дигиталните търговци, Google Keyword Planner привежда предложените ключови думи в съответствие с данните за обема на търсене. Въпреки че е предимно за PPC кампании, той също така помага на създателите на съдържание да прецизират темите си въз основа на реални потребителски заявки. Интеграцията с Google Ads предоставя директна представа за това колко често се търсят конкретни термини, което ви дава преднина в създаването на съдържание, което отговаря на намеренията на потребителя.

3 MonkeyLearn

Идеален за анализ на текст, MonkeyLearn осигурява извличане на ключови думи с помощта на мощни NLP API. Той се отличава с категоризирането на обратна връзка, отзиви или разговори в социалните медии, което го прави ценен за марки, фокусирани върху анализа на настроенията и тенденциите. Таблото за управление на MonkeyLearnвключва опции за обработка в реално време, което означава, че можете да го настроите за непрекъснат анализ на входящите данни - идеално за бързо развиващи се маркетингови екипи или операции за поддръжка на клиенти.

4 Библиотеки за R и Python

За потребители, които се чувстват комфортно с програмирането, библиотеки като Tidytext (R) и spaCy (Python) позволяват задълбочено, персонализирано извличане на ключови думи. Можете да приложите TF-IDF, моделиране на теми и анализ на настроенията за високоспециализирани или мащабни проекти.

Тези библиотеки предлагат гъвкавостта за фина настройка на параметрите или интегриране с рамки за машинно обучение, което ги прави идеални за учени по данни или изследователи, които се нуждаят от напълно персонализиран конвейер за анализ на текст.

5 Semrush

Популярен избор сред SEO професионалисти, Semrush съчетава проучване на ключови думи с конкурентен анализ. Неговият фокус върху обема на търсене, резултатите за трудност и стратегиите на конкурентите помага за прецизиране на плановете за съдържание за максимална видимост.

Освен предложенията за ключови думи, Semrush предоставя информация на ниво домейн, като профили на обратни връзки и анализ на трафика, позволявайки холистичен подход към тактиките за SEO и дигитален маркетинг.

Ръководство стъпка по стъпка за генериране на ключови думи с Eskritor

Когато става въпрос за лесно, но мощно извличане на ключови думи, Eskritor предлага отличен баланс между използваемост и разширени NLP функции. Ето как да се възползвате максимално от неговата платформа.

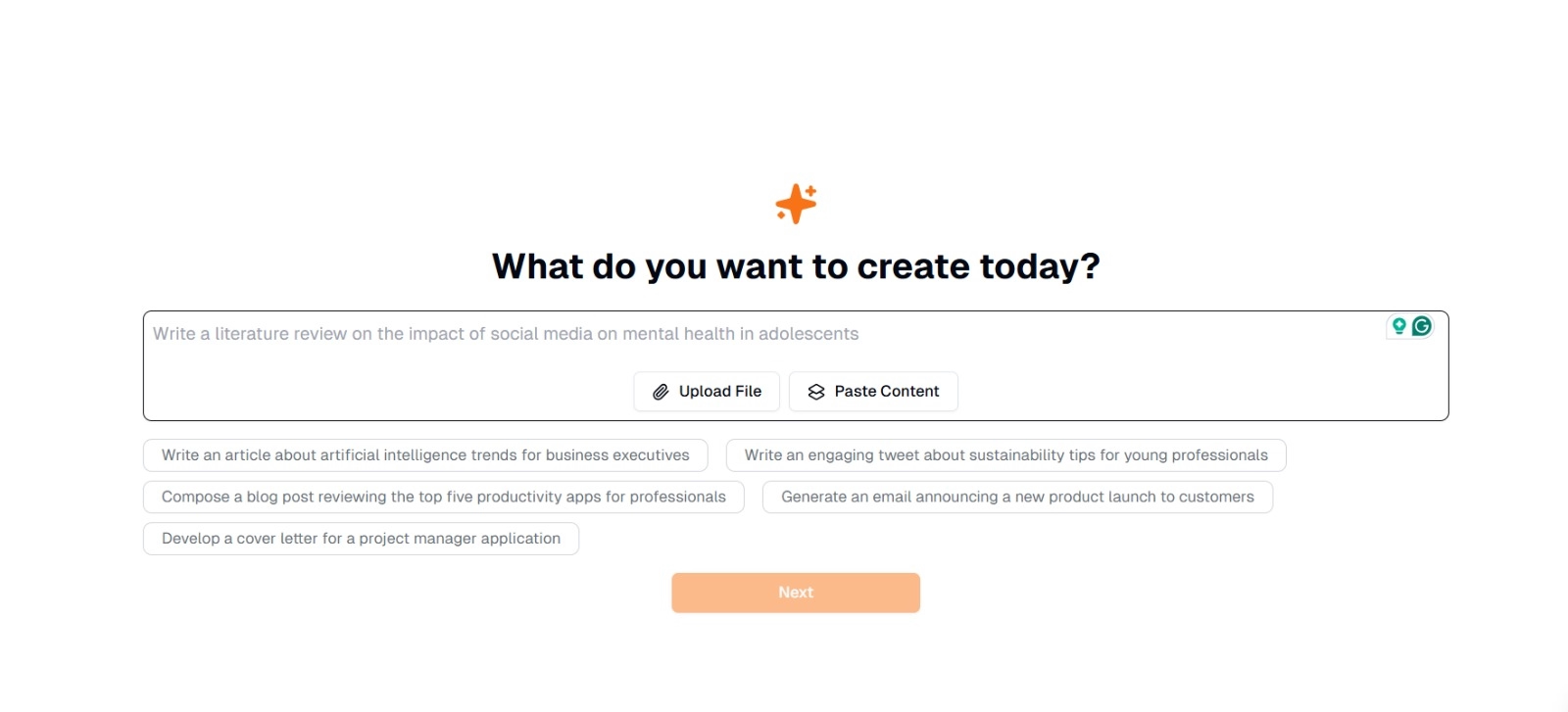

Стъпка 1: Въведете или качете текста си

В основния интерфейс на Eskritorще видите подкана с въпрос : "Какво искате да създадете днес?" Тук имате две възможности:

- Поставяне на съдържание : Копирайте и поставете текста си директно в даденото текстово поле.

- Качване на файл : Изберете документ (напр. .docx, .pdf, .txt), който съдържа текста, който искате да анализирате.

Съвет : Можете също да избирате от предложените подкани (напр. "Напишете статия за тенденциите в изкуствения интелект..."), ако планирате да генерирате или преработите текст преди извличане.

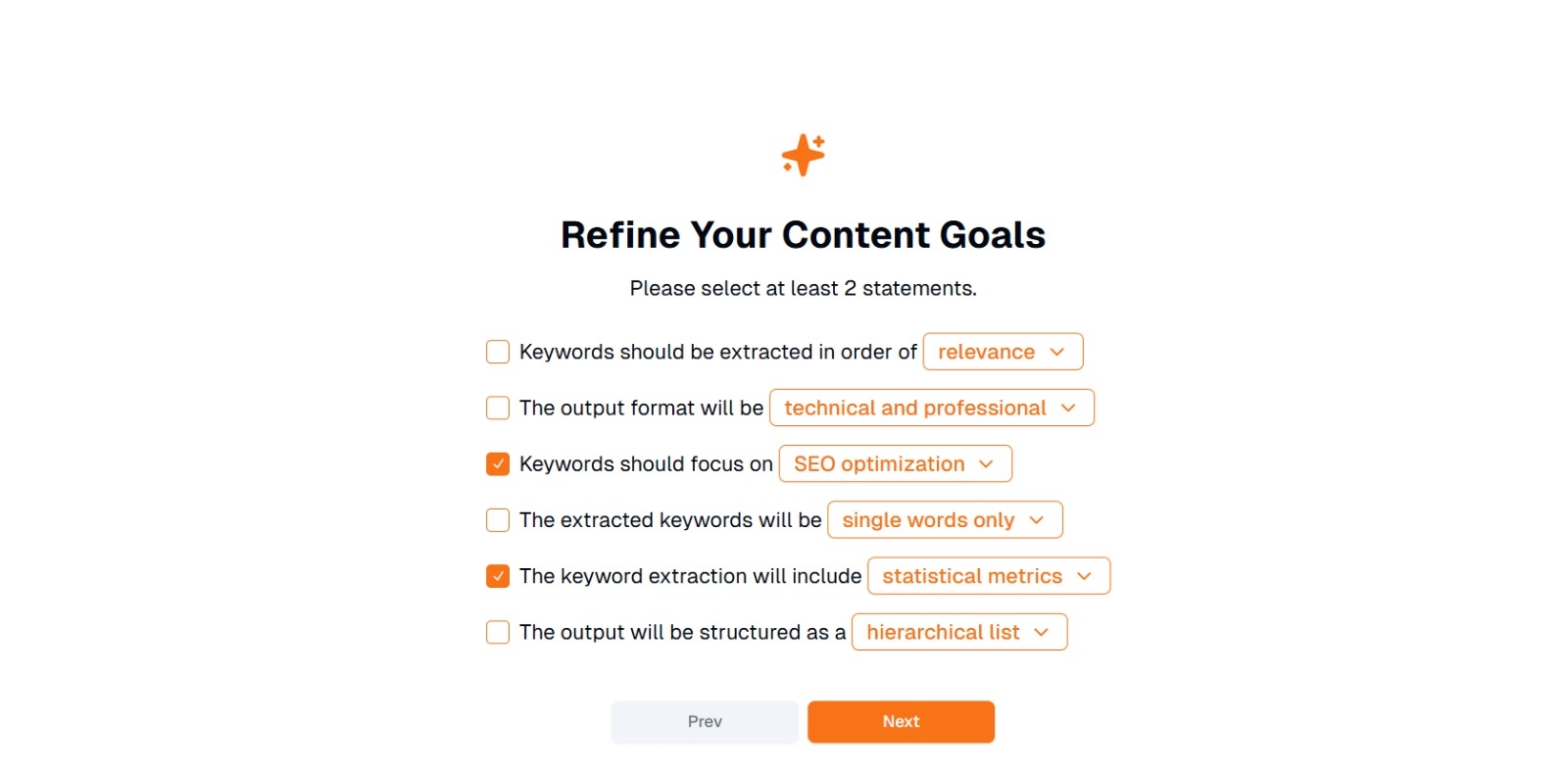

Стъпка 2: Прецизирайте целите си за съдържание

Ще бъдете подканени с " Какво искате да правите с това съдържание? " и помолени да изберат поне 2 твърдения . Освен това можете да напишете какво искате да направите, за да разговаряте. Опциите могат да включват:

- Ключовите думи трябва да се извличат по реда: (напр. уместност , честота , азбучен ред и т.н.)

- Изходният формат ще бъде: (напр. технически и професионален , непринуден и приятелски )

- Ключовите думи трябва да се фокусират върху: (напр. SEO оптимизация, академични изследвания, маркетингови ъгли )

- Извлечените ключови думи ще бъдат: (напр. само единични думи , фрази от няколко думи )

- Извличането на ключови думи ще включва: (напр. статистически показатели , семантично групиране )

- Резултатът ще бъде структуриран като: (напр. йерархичен списък , прости точки )

Съвет : Изберете твърденията, които най-добре отговарят на нуждите на вашия проект. Например, ако оптимизирате публикация в блог за търсачките, помислете за проверка SEO оптимизация, само единични думи и извлечени по реда на уместност.

Стъпка 3: Щракнете върху "Напред", за да генерирате ключови думи

След като прецизирате целите си и направите желания избор, щракнете върху Напред (или подобен бутон), за да започнете извличането на ключови думи. AI на Eskritorще обработва текста, като прилага NLP методи като честотен анализ на термините, TF-IDFи семантичен анализ (според случая), за да идентифицира най-подходящите ключови думи.

Стъпка 4: Прегледайте извлечените ключови думи

Eskritor ще представи списък (или йерархия) от ключови думи въз основа на избраните от вас критерии. Дисплеят може да включва:

- Списък с ключови думи : Подредени по уместност, честота или в йерархичен формат.

Съвет : Внимавайте за ключови думи, които може да се нуждаят от сливане (напр. форми за единствено и множествено число) или премахване (напр. прекалено общи термини).

Стъпка 5: Експортирайте или приложете резултатите

И накрая, експортирайте списъка с ключови думи или го включете директно в работния си процес:

- Опции за експортиране : Изтеглете в PDF, docx или HTML.

- Случаи на употреба : Интегрирайте в SEO инструменти, документи за планиране на съдържанието, очертания на изследвания или маркетингови табла.

Съвети за ефективно генериране на ключови думи

Гарантирането, че извличането на ключови думи е точно и съобразено с целите ви, изисква стратегия. Ето някои най-добри практики, които трябва да имате предвид.

1 Почистете и обработете предварително текста

Премахнете стоп думи, специални знаци и неподходящи данни преди анализа, за да избегнете бъркотия. Инструменти като NLTK (Python) или определени текстови редактори могат да автоматизират тази стъпка на предварителна обработка.

2 Балансирайте честотата и уместността

Ключовата дума не е само за това колко пъти се появява, но и за контекстуалната важност. Комбинирайте показатели за честота със семантичен анализ, за да постигнете правилния баланс.

3 Използвайте комбинация от техники

Използвайте множество подходи -TF-IDF, семантичен анализ или разпознаване на именувани обекти - за да уловите по-пълен набор от подходящи ключови думи и да сведете до минимум слепите петна.

4 Непрекъснато тестване и усъвършенстване

Тенденциите в ключовите думи могат да се променят с течение на времето, особено в бързо развиващите се индустрии. Редовно актуализирайте ключовите си думи въз основа на нови данни, показатели за ефективност или променящи се нужди на аудиторията.

Заключение: Опростете генерирането на ключови думи с AI

Генерирането на ефективни ключови думи е основна част от съвременните стратегии за съдържание, изследователски работни процеси и задачи за анализ на данни. AI и NLPуправлявани инструменти като Eskritor направиха по-лесно от всякога извличането, усъвършенстването и експортирането на ключови думи с висока стойност за част от времето, което би отнело ръчно.

Чрез комбиниране на множество техники -TF-IDF, семантичен анализ, моделиране на теми и други - вие получавате цялостно разбиране за това какво наистина има значение във вашия текст. Това прозрение подхранва по-добри SEO резултати, по-фокусирани изследвания и ангажиращи маркетингови материали. Накратко, извличането на ключови думи, базирано на AI, вече не е задължително; Това е необходимост за професионалисти, които ценят ефективността, прецизността и вземането на решения, базирани на данни.

Дубай, ОАЕ

Дубай, ОАЕ